Бурное развитие Интернета и социальных сетей привело к тому, что пользовательский контент стал пользоваться все большей популярностью, и в то же время к широкому распространению фейковых и неофициальных новостей.

Эта ложная информация не только вызывает путаницу у людей в таких деликатных областях, как здравоохранение, стихийные бедствия, государственная политика и т. д., но и приводит к серьезным последствиям, таким как экономические потери, потеря репутации организации и угрозы национальной безопасности.

VeGraph — это метод проверки информации, исследованный и разработанный группой инженеров Центра услуг данных и искусственного интеллекта Viettel (Viettel AI) (Фото: Viettel AI).

Если раньше эта информация имела значение только в определённое время и в определённом объёме, то теперь она становится всё более опасной, становясь частью входных данных для систем искусственного интеллекта (ИИ). В процессе поиска и сбора информации для ответа пользователям такие системы, как чат-боты и виртуальные помощники, вполне способны использовать, создавать или распространять ложную информацию, если у них нет возможности самопроверки.

Фактчекинг — это процесс проверки достоверности информации. Например, цель проверки фактов в заявлении «НАСА обнаружило жизнь на Марсе» — проверить, основана ли эта информация на опубликованных фактах, полученных из достоверных источников, таких как газеты, научные данные или базы знаний.

Чтобы самостоятельно проверять информацию, системы ИИ должны уметь понимать предложения, находить релевантную информацию и делать логические выводы на основе объективных данных.

VeGraph (Verify-in-the-Graph) — метод проверки информации, исследованный, разработанный и представленный группой инженеров Центра услуг данных и искусственного интеллекта Viettel (Viettel AI) на NAACL 2025 — одной из трех ведущих международных конференций по обработке естественного языка.

Экспериментальные результаты на двух популярных проверочных наборах данных, HoVer и FEVEROUS, показывают, что VeGraph повышает точность на 2–5 % по сравнению с существующими методами.

Большинство современных методов проверки фактов по-прежнему испытывают трудности с обработкой двусмысленных, метафорических или многослойных утверждений, которые часто используются для «маскировки» ложной информации, и не могут четко объяснить, почему часть контента считается ложной, из-за чего пользователям сложно доверять результатам.

Многие методы также в значительной степени опираются на большие языковые модели (LLM), которые не имеют возможности перекрестной проверки с авторитетными источниками знаний, что приводит к риску формирования ложных выводов, также известных как «галлюцинации».

В отличие от инструментов, которые делают только внутренние выводы внутри модели, VeGraph проактивно разбивает запрос на проверку информации на небольшие предложения, а затем сравнивает их с надёжными источниками, такими как юридические документы, правительственные базы данных, специализированные документы и т. д. Весь процесс проверки систематизирован и чётко структурирован, что позволяет пользователям легко отслеживать и проверять информацию, повышая точность, что становится всё более важным фактором в приложениях ИИ. Эта функция также позволяет организациям быстро корректировать и улучшать систему при необходимости.

Стремясь к созданию прозрачной и безопасной цифровой среды, VeGraph высоко ценится за её практическое применение. Помимо возможности интеграции в системы искусственного интеллекта для повышения точности, эта технология может быть использована в качестве системы проверки информации во многих областях, таких как здравоохранение, журналистика, юриспруденция или государственное управление... Благодаря этому пользователи могут самостоятельно проверять важную информацию, требующую высокой достоверности, например, текущие новости, информацию о лекарствах, вакцинах, фармацевтических препаратах или правовых нормах...

Такие системы, как чат-боты и виртуальные помощники, вполне способны использовать, создавать или распространять ложную информацию, если они не способны к самопроверке (Фото: Viettel AI).

В будущем VeGraph будет расширен для обработки различных форматов данных, таких как изображения, видео, аудио и т. д., распознавания сложных языковых форм, таких как метафоры, импликации, а также включения графов знаний для улучшения возможностей рассуждения.

NAACL 2025 (Ежегодная конференция отделений стран Америки Ассоциации компьютерной лингвистики) — ведущий мировой научный форум в области обработки естественного языка и компьютерной лингвистики.

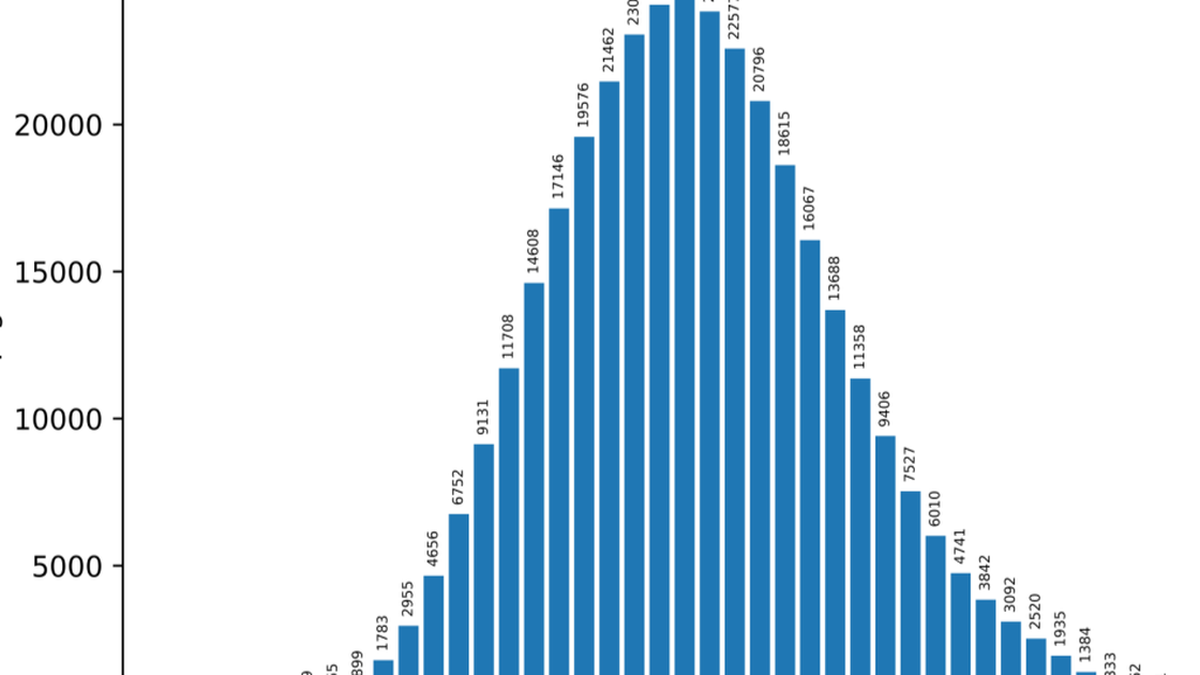

В этом году на конференцию было подано более 3000 докладов, причём процент принятых работ для основных направлений был весьма конкурентоспособным (около 22%), что позволило собрать воедино наиболее новаторские исследования. NAACL 2025 фокусируется на прорывных достижениях в разработке больших языковых моделей, кросс-культурной и многоязычной обработке естественного языка, новых возможностях логического вывода и ответственном ИИ.

Viettel AI — подразделение Военно-промышленной и телекоммуникационной группы (Viettel) — пионера в освоении и разработке продуктов и услуг в области ИИ, больших данных, робототехники и цифровых двойников.

В настоящее время экосистема искусственного интеллекта Viettel включает множество линеек продуктов лидирующего качества во Вьетнаме, которым доверяют и которые используют многие крупные отечественные и международные организации и предприятия.

Источник: https://dantri.com.vn/cong-nghe/khi-ai-biet-kiem-chung-thong-tin-buoc-tien-moi-tu-viettel-ai-tai-naacl-2025-20250519084620026.htm

Комментарий (0)