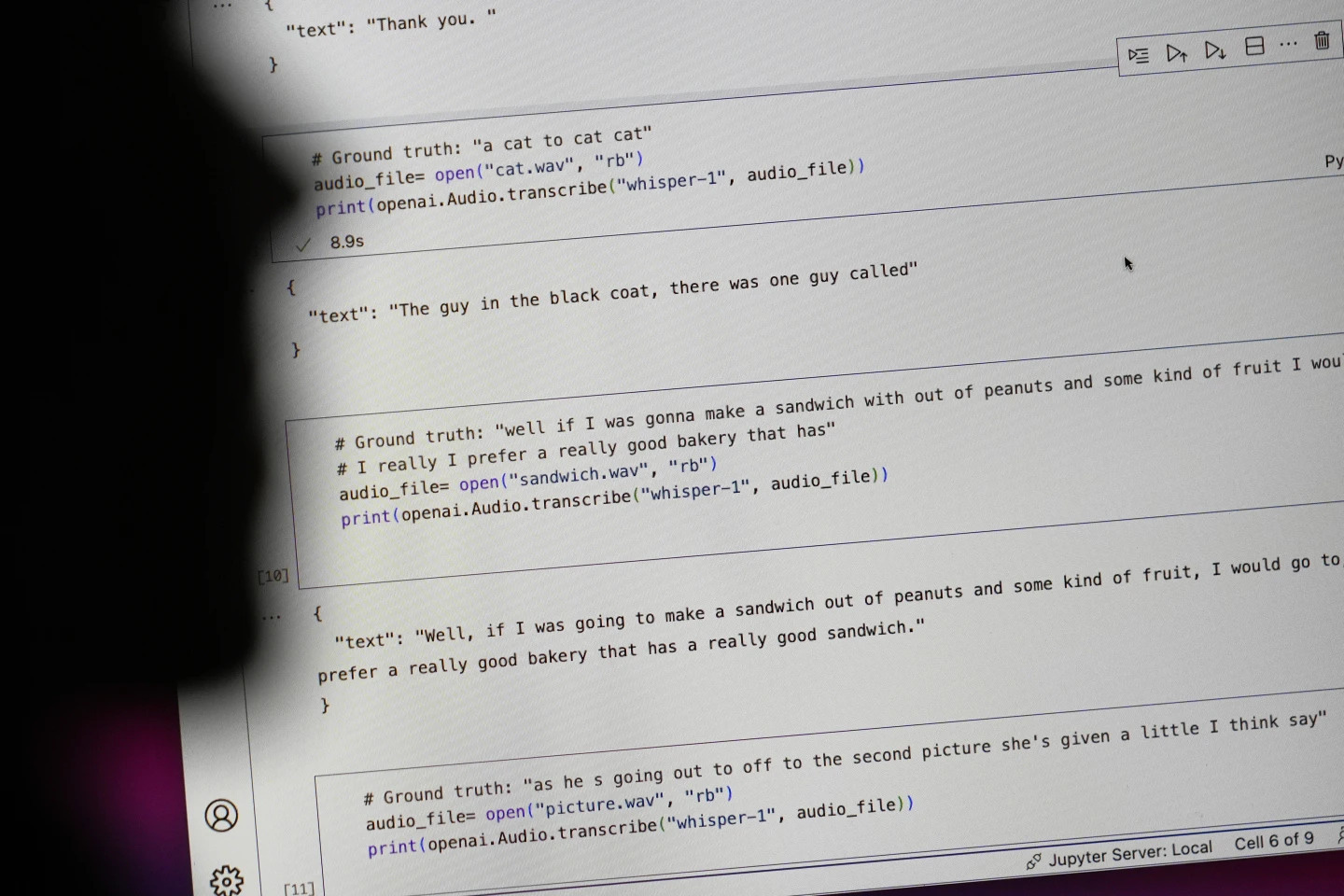

Teknoloji devi OpenAI, konuşmayı metne dönüştürme aracı Whisper'ı 'insan benzeri doğruluk ve sağlamlığa' sahip bir yapay zeka olarak tanıttı. Ancak Whisper'ın önemli bir kusuru vardı: Tamamen sahte metinler ve cümleler üretiyordu.

Yapay zeka tarafından üretilen ve "halüsinasyon" olarak adlandırılan metinlerin bir kısmı ırkçı yorumlar, şiddet içeren ifadeler ve hatta hayali tıbbi tedaviler içerebiliyor. Fotoğraf: AP

AP'ye göre uzmanlar, yapay zeka tarafından üretilen metinlerin bir kısmının "halüsinasyon" niteliğinde olduğunu, ırkçı yorumlar, şiddet içeren dil ve hatta hayali tıbbi tedaviler içerdiğini söylüyor.

Yapay zeka tarafından oluşturulan metinlerde yüksek oranda "illüzyon" var

Uzmanlar, Whisper'ın dünya çapında pek çok sektörde röportajları çevirmek ve yazıya dökmek, popüler tüketici teknolojilerinde metin oluşturmak ve videolar için altyazı oluşturmak amacıyla yaygın olarak kullanılması nedeniyle özellikle endişeli.

Daha da endişe verici olanı, birçok tıp merkezinin doktorlar ve hastalar arasında konsültasyonları aktarmak için Whisper'ı kullanmasıdır; ancak OpenAI, aracın "yüksek riskli" bölgelerde kullanılmaması gerektiği konusunda uyardı.

Sorunun tam boyutunu belirlemek zor, ancak araştırmacılar ve mühendisler çalışmalarında düzenli olarak Fısıltı "halüsinasyonlarıyla" karşılaştıklarını söylüyorlar.

Michigan Üniversitesi'nden bir araştırmacı, incelediği on ses kaydının sekizinde "halüsinasyon" bulduğunu söyledi. Bir bilgisayar mühendisi, analiz ettiği 100 saatten fazla ses kaydının yaklaşık yarısında "halüsinasyon" buldu. Başka bir geliştirici ise, Whisper kullanarak oluşturduğu 26.000 kaydın neredeyse tamamında "halüsinasyon" bulduğunu söyledi.

Sorun, kısa ve net kaydedilmiş ses örneklerinde bile devam ediyor. Bilgisayar bilimcileri tarafından yapılan yakın tarihli bir çalışma, inceledikleri 13.000'den fazla net ses klibinde 187 "illüzyon" tespit etti. Araştırmacılar, bu eğilimin milyonlarca kayıtta on binlerce yanlış transkripsiyona yol açacağını belirtti.

Biden yönetiminde geçen yıla kadar Beyaz Saray Bilim ve Teknoloji Ofisi'nin başkanlığını yürüten Alondra Nelson'a göre, bu tür hatalar özellikle hastane ortamlarında "çok ciddi sonuçlara" yol açabilir.

Şu anda New Jersey, Princeton'daki İleri Araştırmalar Enstitüsü'nde profesör olan Nelson, "Kimse yanlış teşhis istemez," dedi. "Daha yüksek bir standarda ihtiyaç var."

Fısıltı, özellikle yanlış çeviri riski altında olan sağır ve işitme güçlüğü çeken kişiler için altyazı oluşturmak amacıyla da kullanılır. Gallaudet Üniversitesi'nde Teknoloji Erişilebilirliği Programı direktörü ve işitme engelli olan Christian Vogler'a göre, bunun nedeni sağır ve işitme güçlüğü çeken kişilerin "diğer tüm metinlerde gizlenmiş" uydurma pasajları tespit etmelerinin hiçbir yolu olmamasıdır.

Sorunu çözmek için OpenAI'ye başvuruluyor

Bu tür "halüsinasyonların" yaygınlığı, uzmanları, savunucuları ve eski OpenAI çalışanlarını federal hükümetten yapay zeka düzenlemelerini değerlendirmesini istemeye yöneltti. OpenAI'nin en azından bu kusuru ele alması gerekiyor.

Şirketin gidişatı hakkındaki endişeler nedeniyle Şubat ayında OpenAI'dan ayrılan San Francisco'lu araştırma mühendisi William Saunders, "Şirket buna öncelik vermeye istekli olursa bu sorun çözülebilir" dedi.

"Bunu ortaya koyarsanız ve insanlar bunun neler yapabileceği konusunda o kadar kendilerine güvenirlerse ve onu diğer tüm sistemlere entegre ederlerse bu bir sorun olur." OpenAI sözcüsü, şirketin "yanılsamaları" azaltmanın yolları üzerinde sürekli çalıştığını ve araştırmacıların bulgularını takdir ettiğini, OpenAI'nin model güncellemelerine geri bildirimleri dahil ettiğini söyledi.

Çoğu geliştirici, metinden sese dönüştürme araçlarının yazım hataları veya diğer hatalar yapabileceğini varsayarken, mühendisler ve araştırmacılar, Whisper kadar "halüsinasyon" gören yapay zeka destekli bir metinden sese dönüştürme aracı görmediklerini söylüyor.

2024 Nobel Fizik Ödülü: Yapay zekanın temellerini atanlar

2024 Nobel Fizik Ödülü: Yapay zekanın temellerini atanlar[reklam_2]

Kaynak: https://tuoitre.vn/cong-cu-ai-chuyen-loi-noi-thanh-van-ban-cua-openai-bi-phat-hien-bia-chuyen-20241031144507089.htm

![[Fotoğraf] Dong Nai'den geçen otoyollar](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/12/1762940149627_ndo_br_1-resize-5756-jpg.webp)

![Dong Nai OCOP geçişi: [Madde 3] Turizmin OCOP ürün tüketimiyle ilişkilendirilmesi](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/10/1762739199309_1324-2740-7_n-162543_981.jpeg)

Yorum (0)