Yapay zekâ destekli katil robotların kullanımının karmaşık tablosu.

Yapay zekanın silah sistemlerini kontrol etmesine izin vermek, hedeflerin insan müdahalesi olmadan belirlenmesi, saldırıya uğraması ve imha edilmesi anlamına gelebilir. Bu durum ciddi hukuki ve etik soruları gündeme getiriyor.

Avusturya Dışişleri Bakanı Alexander Schallenberg, durumun ciddiyetini vurgulayarak, "Bu, bizim neslimizin Oppenheimer anı" dedi.

Yapay zekâ ile çalışan robotlar ve silahlar, birçok ülkenin ordusunda yaygın olarak kullanılmaya başlandı. Fotoğraf: Forbes

Nitekim, dünya genelindeki ordular tarafından insansız hava araçlarının ve yapay zekanın (YZ) yaygın kullanımı göz önüne alındığında, "cin kavanozdan kaçmış mı" sorusu giderek daha acil bir hal almıştır.

GlobalData savunma analisti Wilson Jones şunları paylaştı: “Rusya ve Ukrayna'nın modern çatışmalarda insansız hava araçlarını kullanması, ABD'nin Afganistan ve Pakistan'daki hedefli saldırı operasyonlarında insansız hava araçlarını kullanması ve geçtiğimiz ay ortaya çıktığı üzere İsrail'in Lavender programının bir parçası olarak, yapay zekanın bilgi işleme yeteneklerinin dünyanın orduları tarafından saldırı güçlerini artırmak için nasıl aktif olarak kullanıldığını göstermektedir.”

Londra merkezli Savaş Soruşturmaları Ofisi'nin yaptığı araştırmalar, İsrail ordusunun Lavender yapay zekâ sisteminin Hamas'la bağlantılı kişileri tespit etmede %90 doğruluk oranına sahip olduğunu, yani %10'unun tespit edilemediğini ortaya koydu. Bu durum, yapay zekânın tespit ve karar verme yetenekleri nedeniyle sivil kayıplara yol açtı.

Küresel güvenliğe yönelik bir tehdit.

Yapay zekanın bu şekilde kullanılması, silah sistemlerinde teknoloji yönetiminin gerekliliğini vurgulamaktadır.

Stockholm Uluslararası Barış Araştırma Enstitüsü'nde (SIPRI), küresel güvenliğe odaklanan bağımsız bir araştırma grubu olan Yapay Zeka Yönetişimi programında kıdemli araştırma görevlisi Dr. Alexander Blanchard, Army Technology'ye şunları açıkladı: "Yapay zekanın silah sistemlerinde, özellikle hedefleme amacıyla kullanılması, biz insanların kim olduğumuz ve savaşla ilişkimiz, daha spesifik olarak da silahlı çatışmalarda şiddeti nasıl kullanabileceğimize dair varsayımlarımız hakkında temel soruları gündeme getiriyor."

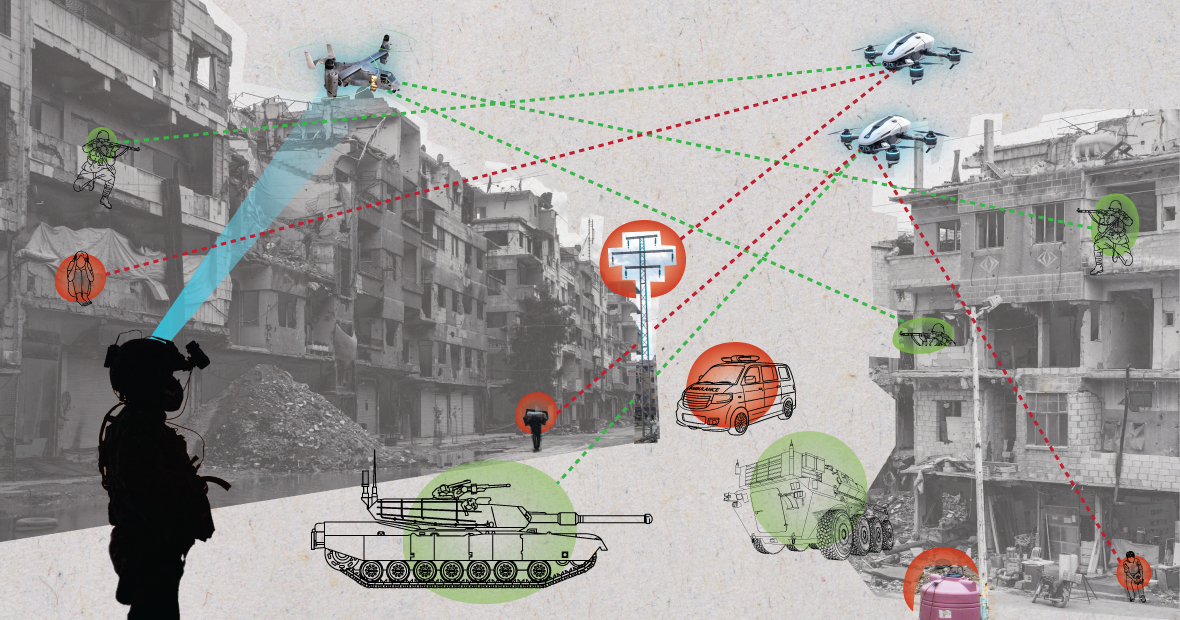

Kaotik ortamlarda kullanıldığında, yapay zeka sistemleri öngörülemez şekilde çalışabilir ve hedefleri doğru bir şekilde belirleyemeyebilir. (Görsel: MES)

Dr. Blanchard sözlerine şöyle devam etti: “Yapay zeka, orduların hedef seçme ve güç uygulama biçimini değiştirecek mi? Bu değişiklikler de beraberinde bir dizi hukuki, etik ve operasyonel soruyu getiriyor. En büyük endişe ise insani boyut.”

SIPRI uzmanı şu açıklamayı yaptı: “Birçok insan, otomatik sistemlerin nasıl tasarlanıp kullanıldığına bağlı olarak, uluslararası hukuk tarafından korunan sivilleri ve diğer kişileri daha büyük bir zarar riskine maruz bırakabileceğinden endişe duyuyor. Bunun nedeni, yapay zeka sistemlerinin, özellikle kaotik ortamlarda kullanıldığında, öngörülemez bir şekilde çalışabilmesi ve hedefleri doğru bir şekilde belirleyemeyerek sivillere saldırabilmesi veya ateş hattının dışında kalan savaşçıları tespit edemeyebilmesidir.”

GlobalData savunma analisti Wilson Jones, bu konuyu daha ayrıntılı ele alarak, suçun nasıl tanımlandığı sorusunun sorgulanabileceğini belirtiyor.

Jones, “Mevcut savaş hukukuna göre, komuta sorumluluğu kavramı vardır,” dedi. “Bu, bir subayın, generalin veya diğer bir liderin, emri altındaki birliklerin eylemlerinden yasal olarak sorumlu olduğu anlamına gelir. Birlikler savaş suçları işlerse, subay emri vermemiş olsa bile sorumlu tutulur; ispat yükü onlardadır ve savaş suçlarını önlemek için mümkün olan her şeyi yaptıklarını göstermeleri gerekir.”

Jones, “Yapay zeka sistemleriyle bu durum işleri karmaşıklaştırıyor. Bir BT teknisyeni mi sorumlu? Bir sistem tasarımcısı mı? Bu net değil. Eğer net değilse, aktörler eylemlerinin mevcut yasalar tarafından korunmadığını düşünürlerse ahlaki bir risk oluşur,” diye vurguladı.

Bir ABD askeri robot köpekle devriye geziyor. Fotoğraf: Forbes

Silah kontrol sözleşmeleri: Birçok önemli uluslararası anlaşma, silahların belirli kullanımlarını kısıtlar ve düzenler. Bunlar arasında kimyasal silah yasağı, nükleer silahların yayılmasını önleme anlaşmaları ve belirli konvansiyonel silahların kullanımını yasaklayan veya kısıtlayan, savaşan taraflara gereksiz veya haksız acı çektirdiği veya sivilleri ayrım gözetmeksizin etkilediği düşünülen belirli silahların kullanımını kısıtlayan Belirli Konvansiyonel Silahlar Sözleşmesi yer almaktadır.

Savunma analisti Wilson Jones, “Nükleer silah kontrolü, uygulanabilir olması için on yıllarca süren uluslararası iş birliğini ve ardından gelen anlaşmaları gerektirir” diye açıklıyor. “Buna rağmen, 1990'lara kadar atmosferik testlere devam ettik. Nükleer silahların yayılmasının önlenmesindeki başarının en büyük nedenlerinden biri, iki kutuplu dünya düzeninde Amerika Birleşik Devletleri ve Sovyetler Birliği arasındaki iş birliğiydi. Bu artık mevcut değil ve yapay zeka teknolojisi, atom enerjisinden daha fazla ülke için daha erişilebilir hale geldi.”

"Bağlayıcı bir anlaşma, ilgili tüm tarafları bir araya getirerek askeri güçlerini artıran bir aracı kullanmamayı kabul etmelerini gerektirir. Ancak bu, etkili olma olasılığı düşük çünkü yapay zeka, minimum maliyet ve maddi masrafla askeri etkinliği artırabilir."

Güncel jeopolitik bakış açısı

Birleşmiş Milletler'deki ülkeler, askeri amaçlarla yapay zekanın sorumlu bir şekilde kullanılmasının gerekliliğini kabul etmiş olsalar da, yapılacak daha çok iş var.

GlobalData'da baş analist olan Laura Petrone, Army Technology'ye şunları söyledi: "Net bir yönetim çerçevesinin olmaması nedeniyle, bu açıklamalar büyük ölçüde iddialı kalıyor. Özellikle mevcut jeopolitik gerilimler bağlamında, bazı ülkelerin iç savunma ve ulusal güvenlik konularında karar verirken kendi egemenliklerini korumak istemeleri şaşırtıcı değil."

Bayan Petrone, AB'nin Yapay Zeka Yasası'nın yapay zeka sistemleri için bazı şartlar belirlediğini ancak askeri amaçlı yapay zeka sistemlerini ele almadığını da sözlerine ekledi.

“Bence bu dışlamaya rağmen, Yapay Zeka Yasası, gelecekte ilgili standartların belirli bir ölçüde uyumlaştırılmasına yol açabilecek, uzun zamandır beklenen bir yapay zeka uygulamaları çerçevesi oluşturma yönünde önemli bir çabadır,” diye belirtti. “Bu uyumlaştırma, askeri alanda yapay zeka için de çok önemli olacaktır.”

Nguyen Khanh

[reklam_2]

Kaynak: https://www.congluan.vn/moi-nguy-robot-sat-thu-ai-dang-de-doa-an-ninh-toan-cau-post304170.html

![[Fotoğraf] Başbakan Pham Minh Chinh, Laos Eğitim ve Spor Bakanı Thongsalith Mangnormek'i kabul ediyor.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765876834721_dsc-7519-jpg.webp&w=3840&q=75)

![[Fotoğraf] Başbakan Pham Minh Chinh, Tochigi Eyaleti Valisi'ni kabul ediyor (Japonya)](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765892133176_dsc-8082-6425-jpg.webp&w=3840&q=75)

![[Resim] 2025 Topluluk Eylem Ödülleri galası öncesinde sızdırılan görüntüler.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765882828720_ndo_br_thiet-ke-chua-co-ten-45-png.webp&w=3840&q=75)

![[Canlı Yayın] 2025 Toplumsal Eylem Ödülleri Galası](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765899631650_ndo_tr_z7334013144784-9f9fe10a6d63584c85aff40f2957c250-jpg.webp&w=3840&q=75)

![[Video] Bach Mai Hastanesi, dünyanın en modern ekipmanlarından oluşan bir grubu hizmete soktu.](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/17/1765931442107_dung00-58-18-13still010-jpg.webp)

Yorum (0)