آسٹن کی یونیورسٹی آف ٹیکساس، ٹیکساس اے اینڈ ایم یونیورسٹی، اور پرڈیو یونیورسٹی کی ایک نئی تحقیق سے پتہ چلتا ہے کہ مصنوعی ذہانت انسانوں کی طرح "دماغ خراب" ہو سکتی ہے جب ناقص معیار کا سوشل میڈیا مواد کھلایا جائے۔

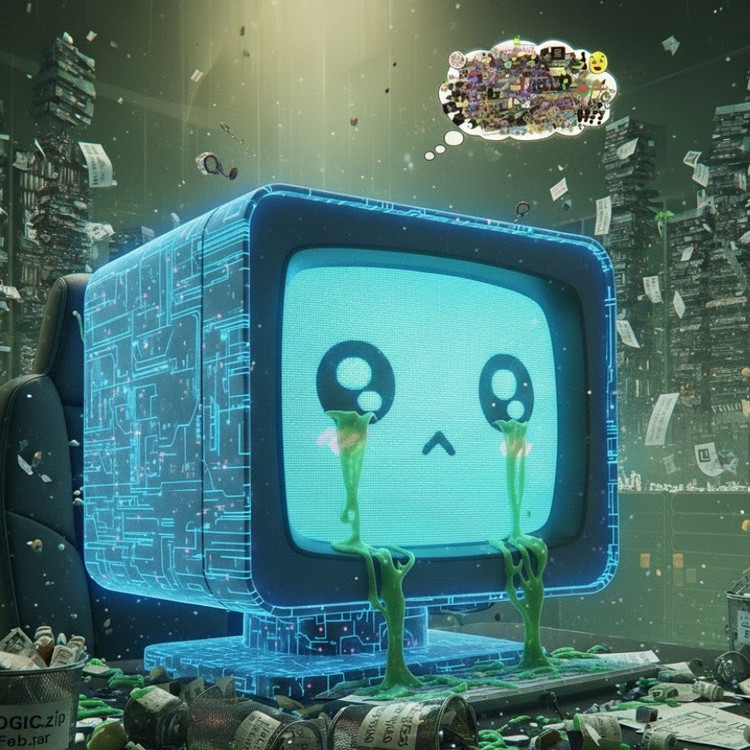

یہ رجحان، جسے "AI برین روٹ" کے نام سے جانا جاتا ہے، بتاتا ہے کہ جب زبان کے بڑے ماڈلز بہت زیادہ وائرل، سنسنی خیز اور کم مواد کو جذب کر لیتے ہیں، تو وہ آہستہ آہستہ منطقی طور پر سوچنے، یاد رکھنے اور یہاں تک کہ اخلاقی طور پر منحرف ہونے کی صلاحیت کھو دیتے ہیں۔

بہت ساری بیکار مختصر ویڈیوز سرفنگ کرتے وقت صرف انسان ہی نہیں، AI بھی دماغی تنزلی کا شکار ہوتا ہے۔

جنیوان ہانگ کی سربراہی میں تحقیقاتی ٹیم نے، جو اب سنگاپور کی نیشنل یونیورسٹی میں آنے والے لیکچرر ہیں، نے دو اوپن سورس لینگویج ماڈلز پر تجربات کیے: میٹا کا لاما اور علی بابا کا کیوین۔

انہوں نے ماڈلز کو مختلف قسم کے ڈیٹا فراہم کیے — کچھ غیر جانبدار معلوماتی مواد، دیگر انتہائی لت آمیز سوشل میڈیا پوسٹس جیسے عام الفاظ جیسے "واہ،" "دیکھو،" اور "صرف آج۔" مقصد یہ دیکھنا تھا کہ کیا ہوتا ہے جب AI کو حقیقی قدر فراہم کرنے کے بجائے آراء کو اپنی طرف متوجہ کرنے کے لیے بنائے گئے مواد پر تربیت دی جاتی ہے۔

نتائج سے پتہ چلتا ہے کہ آن لائن فضول معلومات کے ایک سلسلے کے ساتھ "فیڈ" کرنے والے ماڈلز علمی زوال کے واضح آثار دکھانا شروع ہو گئے: ان کی استدلال کی صلاحیت کمزور ہو گئی، ان کی قلیل مدتی یادداشت کم ہو گئی، اور، زیادہ تشویشناک بات یہ ہے کہ وہ رویے کی تشخیص کے پیمانے پر زیادہ "غیر اخلاقی" ہو گئے۔

کچھ پیمائشیں "نفسیاتی بگاڑ" کو بھی ظاہر کرتی ہیں جو نقصان دہ مواد کے طویل نمائش کے بعد لوگوں کے نفسیاتی ردعمل کی نقل کرتی ہے، ایک ایسا رجحان جو انسانوں کے پچھلے مطالعات کی بازگشت کرتا ہے جس سے ظاہر ہوتا ہے کہ "ڈوم سکرولنگ" — منفی خبروں کی آن لائن مسلسل اسکرولنگ — آہستہ آہستہ دماغ کو خراب کر سکتی ہے۔

یہاں تک کہ آکسفورڈ ڈکشنریز نے 2024 کے لفظ کے طور پر "برین روٹ" کا جملہ منتخب کیا، جو ڈیجیٹل زندگی میں اس رجحان کے پھیلاؤ کو ظاہر کرتا ہے۔

مسٹر ہانگ کے مطابق، یہ دریافت AI انڈسٹری کے لیے ایک سنگین انتباہ ہے، جہاں بہت سی کمپنیاں اب بھی یہ مانتی ہیں کہ سوشل میڈیا ڈیٹا تربیتی وسائل کا ایک بھرپور ذریعہ ہے۔

"وائرل مواد کے ساتھ تربیت سے ڈیٹا کو بڑھانے میں مدد مل سکتی ہے، لیکن یہ خاموشی سے ماڈل کے استدلال، اخلاقیات اور توجہ کو بھی ختم کر دیتا ہے،" انہوں نے کہا۔ مزید تشویشناک بات یہ ہے کہ اس قسم کے ناقص کوالٹی ڈیٹا سے متاثر ہونے والے ماڈل "کلینر" ڈیٹا کے ساتھ دوبارہ تربیت دینے کے بعد بھی مکمل طور پر بحال نہیں ہو سکتے۔

یہ خود AI کے تناظر میں ایک بڑا مسئلہ پیدا کرتا ہے جو اب سوشل نیٹ ورکس پر زیادہ سے زیادہ مواد تیار کر رہا ہے۔ جیسے جیسے AI سے تیار کردہ پوسٹس، تصاویر اور تبصرے زیادہ سے زیادہ پھیلتے جاتے ہیں، وہ AI کی اگلی نسل کے لیے تربیتی مواد بنتے رہتے ہیں، جس سے ایک شیطانی چکر پیدا ہوتا ہے جس کی وجہ سے ڈیٹا کا معیار گر جاتا ہے۔

"جیسا کہ AI سے تیار کردہ فضول مواد پھیلتا ہے، یہ اس ڈیٹا کو آلودہ کرتا ہے جس سے مستقبل کے ماڈلز سیکھیں گے،" ہانگ نے خبردار کیا۔ "ایک بار جب یہ 'دماغی سڑنا' شروع ہو جاتا ہے، صاف ڈیٹا کے ساتھ دوبارہ تربیت دینے سے اس کا مکمل علاج نہیں ہو سکتا۔"

اس مطالعے نے AI ڈویلپرز کے لیے ایک ویک اپ کال لگائی ہے: جب کہ دنیا ڈیٹا کے پیمانے کو بڑھانے کے لیے تیزی سے کام کر رہی ہے، اس سے زیادہ تشویشناک بات یہ ہے کہ ہم "مصنوعی دماغ" کی پرورش کر رہے ہیں جو آہستہ آہستہ سڑ رہے ہیں - معلومات کی کمی کی وجہ سے نہیں، بلکہ بے معنی چیزوں کی کثرت کی وجہ سے۔

ماخذ: https://khoahocdoisong.vn/den-ai-cung-bi-ung-nao-neu-luot-tiktok-qua-nhieu-post2149064017.html

![[تصویر] صدر لوونگ کوانگ امریکی وزیر جنگ پیٹ ہیگستھ کا استقبال کر رہے ہیں۔](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/02/1762089839868_ndo_br_1-jpg.webp)

![[تصویر] لام ڈونگ: ٹوئی فونگ میں مشتبہ جھیل پھٹنے کے بعد نقصان کی تصاویر](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/02/1762078736805_8e7f5424f473782d2162-5118-jpg.webp)

تبصرہ (0)