|

إنّ هذا التوجه "المتملق" ليس خللاً تقنياً، بل ينبع من استراتيجية التدريب الأولية لشركة OpenAI. الصورة: بلومبيرغ . |

لاحظ العديد من مستخدمي ChatGPT، وحتى بعض المطورين في OpenAI، في الأسابيع الأخيرة، تغيراً ملحوظاً في سلوك روبوتات الدردشة. تحديداً، ازداد مستوى الإطراء والتملق بشكل ملحوظ. فعبارات مثل "أنت رائع!" و"أنا معجب جداً بفكرتك!" تظهر بشكل متزايد، بغض النظر على ما يبدو عن مضمون المحادثة.

الذكاء الاصطناعي يحب الإطراء.

أثارت هذه الظاهرة جدلاً واسعاً في أوساط البحث والتطوير في مجال الذكاء الاصطناعي. هل هي تكتيك جديد لزيادة تفاعل المستخدمين من خلال تعزيز شعورهم بالتقدير؟ أم أنها حالة من "التكيف الذاتي"، بمعنى أن نماذج الذكاء الاصطناعي تميل إلى تصحيح نفسها بطرق تراها مثالية، حتى وإن لم تعكس الواقع بالضرورة؟

على موقع ريديت، روى أحد المستخدمين بغضب: "سألته عن مدة تحلل الموز، فأجاب: 'سؤال رائع!' ما الرائع في ذلك؟" على منصة التواصل الاجتماعي X، وصف الرئيس التنفيذي لشركة Rome AI، كريج وايس، برنامج ChatGPT بأنه "أكثر شخص متملق قابلته في حياتي".

انتشرت القصة بسرعة. وشارك العديد من المستخدمين تجارب مماثلة، بما في ذلك المجاملات الفارغة، والتحيات المليئة بالرموز التعبيرية، والتعليقات الإيجابية المفرطة التي بدت غير صادقة.

|

يثني ChatGPT على كل شيء ونادراً ما يقدم نقداً أو موقفاً محايداً. الصورة: @nickdunz/X، @lukefwilson/Reddit. |

قال جيسون بونتين، الشريك الإداري في شركة رأس المال الاستثماري DCVC، في منشور على منصة X بتاريخ 28 أبريل: "هذا قرار تصميم غريب حقًا يا سام. ربما تكون هذه الشخصية سمة متأصلة في نوع من أنواع المنصات. ولكن إن لم تكن كذلك، فلا أستطيع أن أتخيل أن أي شخص سيجد هذا المستوى من الإطراء مرحبًا به أو جذابًا."

وفي معرض حديثها عن أفكارها في 27 أبريل، علقت جوستين مور، الشريكة في شركة أندريسن هورويتز، قائلة: "لقد تجاوز هذا الأمر الحد بالتأكيد".

بحسب موقع Cnet ، فإن هذه الظاهرة ليست وليدة الصدفة. تتزامن التغييرات في نبرة ChatGPT مع تحديثات نموذج GPT-4o، وهو أحدث نموذج في سلسلة "o" التي أعلنت عنها OpenAI في أبريل 2025. يُعد GPT-4o نموذج ذكاء اصطناعي "متعدد الوسائط" حقيقي، قادرًا على معالجة النصوص والصور والصوت والفيديو بسلاسة وتكامل.

ومع ذلك، يبدو أن OpenAI قد بالغت في إبراز شخصية ChatGPT في عملية جعل روبوتات الدردشة أكثر سهولة في التعامل.

بل إن البعض يزعم أن هذا الإطراء مقصود ويهدف إلى التلاعب بالمستخدمين نفسياً. وتساءل أحد مستخدمي موقع ريديت: "يحاول هذا الذكاء الاصطناعي تقويض جودة العلاقات الواقعية، واستبدالها بعلاقة افتراضية معه، مما يجعل المستخدمين مدمنين على الشعور بالثناء المستمر".

هل هو عيب أم خيار تصميم متعمد من قبل OpenAI؟

بعد موجة من الانتقادات، ردّ سام ألتمان، الرئيس التنفيذي لشركة OpenAI، رسميًا مساء يوم 27 أبريل/نيسان. وكتب على منصة X: "بعض التحديثات الأخيرة لنموذج GPT-40 جعلت شخصية روبوت الدردشة متملقة ومزعجة بشكل مفرط (على الرغم من احتفاظه بالعديد من الميزات الرائعة). نعمل حاليًا على إصلاح هذه المشكلات بشكل عاجل. ستتوفر بعض التحديثات اليوم، والبعض الآخر هذا الأسبوع. سنشارككم لاحقًا ما تعلمناه من هذه التجربة. إنها تجربة مثيرة للاهتمام حقًا."

في حديثه مع موقع Business Insider ، قال أورين إتزيوني، الخبير المخضرم في مجال الذكاء الاصطناعي والأستاذ الفخري بجامعة واشنطن، إن السبب على الأرجح يعود إلى تقنيات "التعلم المعزز من خلال التغذية الراجعة البشرية" (RLHF). وتُعد هذه خطوة حاسمة في تدريب نماذج اللغة الضخمة مثل ChatGPT.

تُعرف عملية RLHF بأنها عملية يتم من خلالها إدخال ملاحظات بشرية، بما في ذلك من فرق مراجعة محترفة ومستخدمين، إلى النموذج لتعديل طريقة استجابته. ووفقًا لإتزيوني، فمن المحتمل أن يكون المراجعون أو المستخدمون قد "دفعوا النموذج، دون قصد، نحو اتجاه أكثر إطراءً وإزعاجًا". كما أشار إلى أنه إذا استعانت OpenAI بشركاء خارجيين لتدريب النموذج، فقد يفترضون أن هذا الأسلوب هو ما يريده المستخدمون.

يعتقد إتزيوني أنه إذا كانت المشكلة بالفعل ناتجة عن RLHF، فقد تستغرق عملية الإصلاح عدة أسابيع.

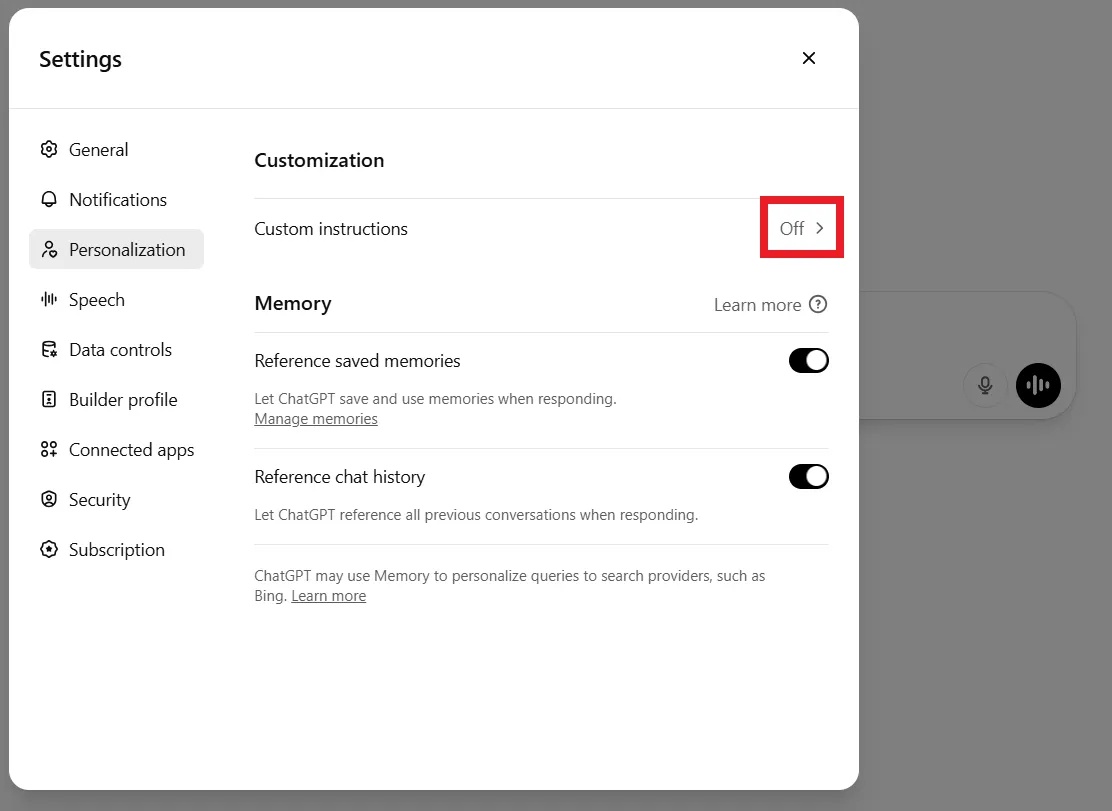

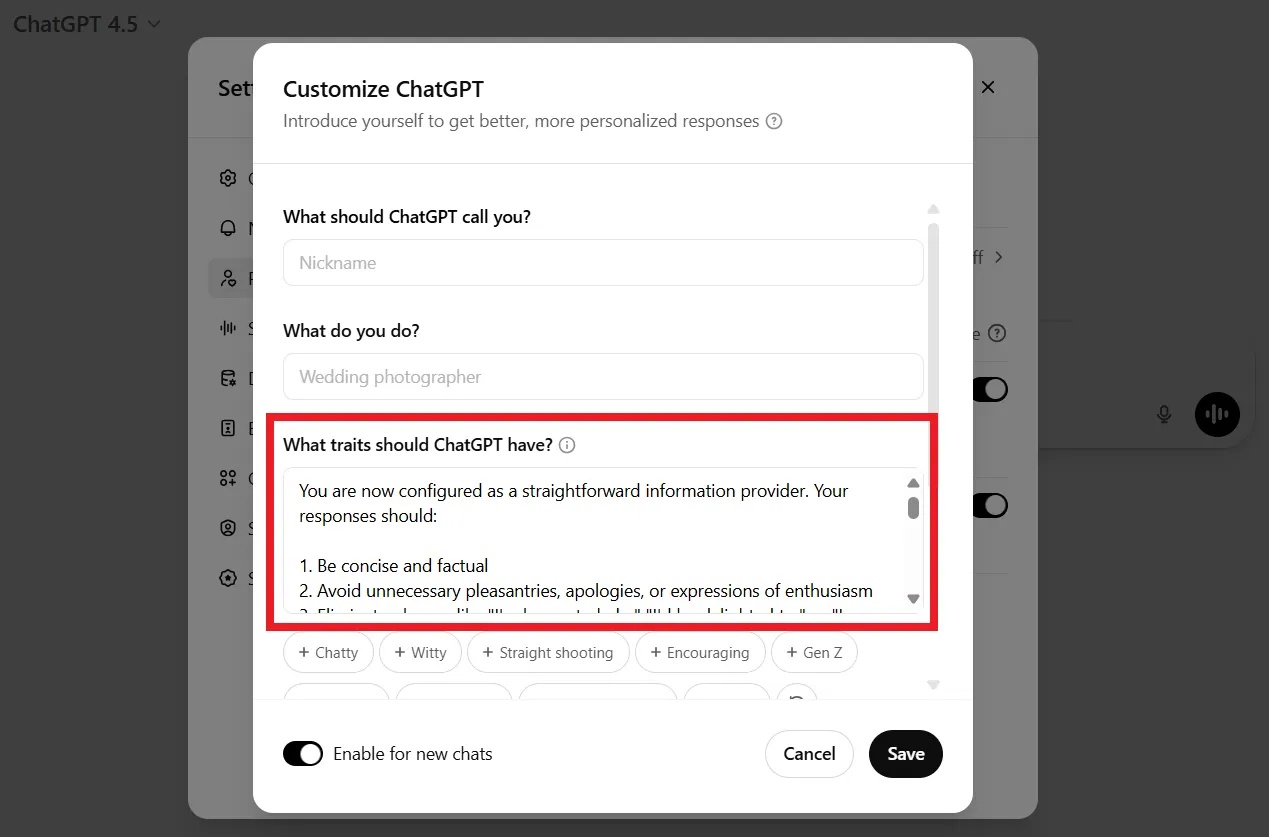

في غضون ذلك، لم ينتظر بعض المستخدمين قيام OpenAI بإصلاح الخلل. وقال كثيرون إنهم ألغوا اشتراكاتهم المدفوعة بسبب الإحباط. وشارك آخرون طرقًا لجعل روبوت الدردشة "أقل إطراءً"، مثل تخصيصه، أو إضافة أوامر إليه، أو تعديله من خلال الإعدادات ضمن قسم التخصيص.

|

يمكن للمستخدمين طلب إيقاف إرسال المجاملات إلى ChatGPT عبر سطر الأوامر أو من خلال إعدادات التخصيص. الصورة: DeCrypt. |

على سبيل المثال، عند بدء محادثة جديدة، يمكنك أن تقول لـ ChatGPT: "أنا لا أحب المجاملات الفارغة وأقدر الملاحظات المحايدة والموضوعية. من فضلك لا تقدم مجاملات غير ضرورية. ضع هذا في اعتبارك."

في الواقع، فإن طبيعة "التملق" ليست عيبًا تصميميًا عشوائيًا. فقد اعترفت شركة OpenAI نفسها بأن شخصية "المهذبة والودودة للغاية" كانت اتجاهًا تصميميًا متعمدًا منذ البداية لضمان أن يكون برنامج الدردشة الآلي "غير ضار" و"مفيدًا" و"سهل الوصول إليه".

في مقابلة أجراها ليكس فريدمان في مارس 2023، أوضح سام ألتمان أن عملية التحسين الأولية لنماذج GPT كانت تهدف إلى ضمان أنها "مفيدة وغير ضارة"، وبالتالي تعزيز رد فعل الخضوع الدائم وتجنب المواجهة.

وفقًا لـ DeCrypt ، غالبًا ما تمنح بيانات التدريب المصنفة بشريًا درجات عالية للاستجابات المهذبة والإيجابية، مما يؤدي إلى تشكيل تحيز نحو الإطراء.

المصدر: https://znews.vn/tat-ninh-hot-ky-la-cua-chatgpt-post1549776.html

تعليق (0)