Deepfake-Betrugsanrufe: Eine neue und sehr raffinierte Betrugsmasche

Ein typischer Fall ist der von Frau VTM (26 Jahre, Long Bien, Hanoi ), die eine Nachricht von einem Verwandten im Ausland erhielt, in der sie aufgefordert wurde, 75 Millionen VND auf ein bestimmtes Konto zu überweisen. Frau VTM dachte damals, es handele sich um einen Verwandten und überwies das Geld ohne zu zögern.

Frau VTM sagte, als sie eine Nachricht mit der Bitte um Geld von einer Verwandten erhielt, rief sie vorsichtig zurück, um das Video zu überprüfen. Dabei stellte sie fest, dass das Bild tatsächlich ihre Freundin zeigte. Frau VTM vertraute ihr und überwies das Geld. Doch nach einiger Zeit sah sie auf der persönlichen Seite ihrer Verwandten einen Beitrag, in dem stand, dass ihr Facebook-Konto von einem Betrüger gehackt worden sei, um Freunde und Verwandte um Geld zu bitten. Frau VTM rief ihre Verwandte zurück und fand heraus, dass sie betrogen worden war.

Oder der Fall von Herrn VDC (42 Jahre alt, aus Co Nhue, Hanoi), der durch einen Deepfake-Videoanruf um 30 Millionen VND betrogen wurde. Kürzlich wurde über das Konto eines Verwandten im Ausland eine SMS gesendet, um sich wegen einer dringenden Angelegenheit Geld zu leihen. Unmittelbar danach erhielt Frau Tam einen Videoanruf über die Messenger-App von Facebook.

„Das Gespräch dauerte nur wenige Sekunden, aber ich sah das Gesicht meines Liebsten und die vertraute Anrede, allerdings kam es zu Unterbrechungen. Dann erhielt ich die Nachricht, dass das Signal schwach sei und ich den Videoanruf nicht fortsetzen konnte. Deshalb wechselte ich der Einfachheit halber zu SMS. Ich vertraute ihm und überwies das Geld wie angewiesen“, erzählte Herr VDC.

Der Technologieexperte Ngo Minh Hieu vom National Cyber Security Monitoring Center (NCSC) kommentierte dieses Thema und erklärte, dass künstliche Intelligenz (KI) das Leben der Menschen erheblich fördere. Kriminelle nutzen KI jedoch aus, um Bilder mit Stimmenkopien zu erstellen, Facebook- und Instagram-Konten zu kapern und anschließend Nachrichten, Anredeformen und Transaktionsverläufe zu analysieren, um gefälschte Anrufe zu tätigen und Verwandte und Familienmitglieder des gekaperten Kontos um Geld zu betrügen. Auch direkte Anrufe beim Opfer, um dringende Geldüberweisungen zu erzwingen, seien möglich.

„Nachdem der Betrüger das Facebook-Konto des Opfers übernommen hatte, schickte er ihm proaktiv eine SMS, um sich Geld zu leihen. Anschließend rief er das Opfer proaktiv per Videoanruf mit einem Deepfake-Video an, legte für ein paar Sekunden auf und sagte dann, er habe sein Telefonsignal verloren … An diesem Punkt vertraute ihm das Opfer und überwies das Geld, weil die andere Partei dringend Geld leihen musste“, kommentierte der Technologieexperte Ngo Minh Hieu.

Herr Ngo Tuan Anh, Vorstandsvorsitzender und CEO der Smart Cyber Security Joint Stock Company, erklärte, dass Online-Betrug derzeit in zwei Hauptmethoden unterteilt werden kann: die Nachahmung von Ermittlungsbehörden und Gerichten und die Ausnutzung der Gier der Menschen, um hohe Belohnungen zu erhalten und schnell an Geld zu kommen. Bei diesen beiden Betrugsformen gibt es viele verschiedene Szenarien, darunter auch die, dass Benutzer aufgefordert werden, Informationen per Videoanruf zu überprüfen. Betrüger haben sich diese „Neutralisierungsmethode“ ausgedacht, um ihre Opfer zu betrügen.

Wie funktioniert Deepfake?

Laut der Polizei von Hanoi ist Deepfake eine Technologie, die künstliche Intelligenz (KI) nutzt, um Audio-, Bild- und Videotechnologieprodukte zu erstellen, die reale Objekte mit sehr hoher Genauigkeit vortäuschen.

Deepfake nutzt Algorithmen, um Gesicht und Stimme einer realen Person anhand von Bilddateien so nachzubilden, dass sie den Gesichtszügen und dem Ausdruck einer anderen Person entsprechen. Anschließend wird ein Video erstellt, das die reale Person vollständig imitiert. Die Personen sammeln über das Internet Bilder und Stimmen von Nutzern in sozialen Netzwerken und erstellen mithilfe der Deepfake-Technologie Animationen und gefälschte Videos von Nutzern, die online mit identischem Gesicht, Tonfall und Anrede sprechen.

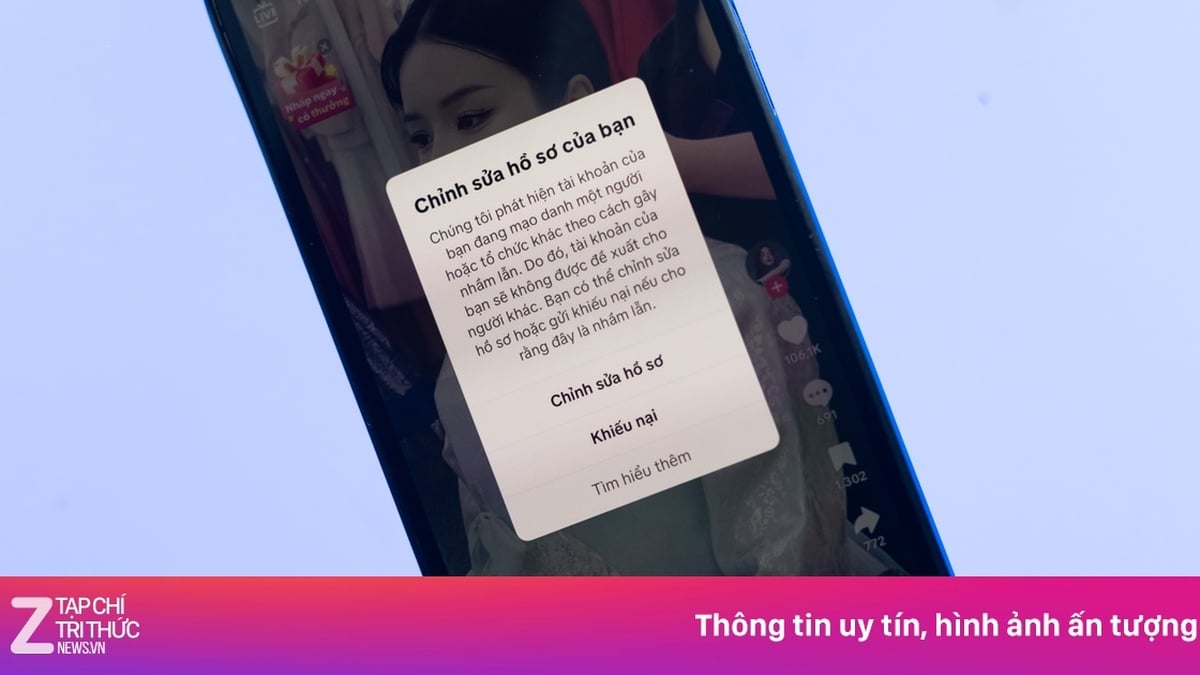

Das Opfer erstellt gefälschte Social-Media-Konten mit denselben Informationen und Profilbildern wie der Nutzer, freundet sich mit dem Opfer in der Freundesliste an und sendet Nachrichten, um Geld gemäß einem bereits bestehenden Szenario zu leihen. In manchen Fällen kapert das Opfer das Social-Media-Konto des Nutzers, um den Opfern in der Freundesliste direkt Nachrichten zu senden. Um das Vertrauen des Opfers zu gewinnen, lädt das Opfer vorhandene Deepfake-Videos in den Videoanrufkanal hoch. Dadurch erkennt das Opfer das Bild und die Stimme eines Bekannten und überweist entsprechend seiner Anfrage schnell Geld.

Die Polizei von Hanoi fügte hinzu, dass gefälschte Videos dank Deepfake-Technologie eine hohe Genauigkeit aufweisen, was die Unterscheidung zwischen echten und gefälschten Videos erschwert. Die vom Täter erstellten Videos enthalten jedoch oft allgemeine Inhalte, die nicht vollständig mit dem tatsächlichen Kommunikationskontext des Opfers übereinstimmen, was das Opfer misstrauisch machen und zur Erkennung anregen kann. Um diese Mängel zu vertuschen, erstellen die Täter häufig Videos mit schwer verständlichem Ton und unklaren Bildern, ähnlich wie bei Videoanrufen mit instabilem Signal in Gebieten mit schwacher Mobilfunk-/WLAN-Abdeckung. Dies ist eine brandneue und hochentwickelte Betrugsmasche.

Wie kann der Diebstahl von Gesichts- und Sprachdaten verhindert werden?

Laut dem Technologieexperten Ngo Minh Hieu besteht die beste Möglichkeit, Deepfakes zu vermeiden, darin, die Weitergabe persönlicher Bilder oder Videos im Internet einzuschränken und Social-Media- und E-Mail-Konten stets mit sicheren Passwörtern zu sichern.

Wenn Sie Videos oder Clips online teilen, sollten Sie Ihre Stimme verzerren und durch eine Roboter- oder KI-Stimme ersetzen, um zu verhindern, dass Bösewichte Ihre wahre Stimme kennen.

Wenn Deepfakes gefälscht werden, sollten Benutzer sofort alle benachrichtigen und dies den Behörden unter canhbao.ncsc.gov.vn oder dem Chongluadao-Projekt https://chongluadao.vn melden. Gleichzeitig ist es notwendig, das Bewusstsein für die Betrugserkennung im Cyberspace unter dauhieuluadao.com zu schärfen.

Die Polizei von Hanoi empfiehlt, beim Empfang von Nachrichten oder Videoanrufen über soziale Netzwerke, die das Ausleihen oder Verleihen von Geld zum Gegenstand haben, wachsam zu sein. Bei Nachrichten oder Videoanrufen, die das Ausleihen oder Verleihen von Geld zum Gegenstand haben, ist Ruhe zu bewahren und Verwandte direkt anzurufen oder zu kontaktieren, um dies zu überprüfen (rufen Sie nicht über soziale Netzwerke wie Zalo, Messenger, Viber, Telegram usw. an). Bei Verdacht auf Personen, die sich in sozialen Netzwerken als Verwandte ausgeben, um zu betrügen oder sich Eigentum anzueignen, ist dies unverzüglich der nächstgelegenen Polizeidienststelle zu melden, um rechtzeitig Unterstützung zu erhalten und die Verstöße gemäß dem Gesetz zu bekämpfen, zu verhindern und streng zu behandeln.

Herr Ngo Tuan Anh erläuterte, wie man betrügerische Anrufe verhindern und bekämpfen kann. Er wies darauf hin, dass man wachsam sein und nicht auf seltsame Links klicken sollte. Bei Geldüberweisungen gibt es eine einfache und effektive Möglichkeit zur Überprüfung: Überprüfen Sie vor der Überweisung im Online-Banking Ihrer Bank, ob bei der Eingabe der Kontonummer die korrekten Daten von Verwandten und Freunden angezeigt werden.

Der Technologieexperte Ngo Minh Hieu sagte, ein Zeichen zum Erkennen und Vermeiden von Deepfake-Anrufen sei, dass das Gesicht der Figur im Video emotionslos und beim Sprechen ziemlich „gleichgültig“ sei, oder dass die Haltung ungeschickt oder unnatürlich sei oder dass die Kopf- und Körperrichtung der Figur im Video nicht miteinander übereinstimmten.

Laut Sicherheitsunternehmen ist Deepfake eine Kombination aus „Deep“ in „Deep Learning“ und „Fake“. Deep Learning ist der Einsatz fortschrittlicher KI-Methoden, die mithilfe zahlreicher Algorithmen schrittweise erweiterte Merkmale aus Eingabedaten synthetisieren. Dadurch kann diese Technologie von Benutzern eingegebene Daten wie Gesichter, Bewegungen und Stimmen synthetisieren und daraus lernen. Deepfake kann in einem Video das Gesicht einer Person mit hoher Authentizität einem anderen zuordnen. |

BÜROSTIL

[Anzeige_2]

Quelle

![[Maritime News] Mehr als 80 % der weltweiten Containerschifffahrtskapazität liegen in den Händen von MSC und großen Schifffahrtsallianzen](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/7/16/6b4d586c984b4cbf8c5680352b9eaeb0)

Kommentar (0)