Bösewichte können mithilfe von KI sensible Fotos und Videos kombinieren, um andere zu diffamieren und zu erpressen – Foto: KI-Zeichnung

Früher wurde bei der Technik des Ausschneidens und Einfügens des Gesichts einer Person auf den Körper einer anderen Person häufig Photoshop oder spezielle Bildbearbeitungssoftware verwendet – was mühsam ist und mit bloßem Auge leicht zu erkennen ist.

Mit KI-Tools ist das heute ganz einfach mit „ein paar Notizen“ möglich, mit bloßem Auge ist es jedoch nicht leicht zu erkennen.

Sexvideo mit Face-Swapping zur Erpressung

Aufgrund beruflicher Kontakte ist Herr H. (Geschäftsführer eines Unternehmens in Ho-Chi-Minh-Stadt) häufig in sozialen Netzwerken aktiv.

Einmal freundete er sich mit einem jungen Mädchen an, das ihn nach seiner Arbeit fragte. Nachdem sie sich eine Weile übereinander erkundigt, geplaudert und sich über Arbeit und Privatleben ausgetauscht hatten, schienen sich die beiden ziemlich nahe zu sein.

Zwischen den beiden gab es auch viele Textnachrichten mit sehr liebevollen Worten, hin- und hergeschickte Bilder und Videoanrufe, um sich zu sehen.

Eines Tages erhielt Herr H. plötzlich einen Anruf von einem Mann, der behauptete, der Ehemann des Mädchens zu sein. Nach einem „Präventivschlag“ gegen Herrn H. forderte der „Ehemann“ von ihm die Überweisung einer Entschädigungssumme, andernfalls würde er Fotos ihrer Chats und Sexvideos an seine Verwandten und Geschäftspartner schicken.

Anschließend wurde Herrn H. von seinem „Ehemann“ ein Sexvideo von ihm und dem anderen Mädchen gezeigt, zusammen mit einem Videoanruf zwischen den beiden und aufgezeichneten intimen Textnachrichten …

„Ich habe das Mädchen nie getroffen, daher bin ich sicher, dass das Sexvideo ein Photoshop-Bild ist“, bekräftigte Herr H. Allerdings sind das Bild des Gesichts des Mädchens im Sexvideo und das des Mädchens in seinem Videoanruf identisch, ebenso wie ein Foto der liebevollen Textnachricht, was Herrn H. dazu zwang, seinem „Ehemann“ mehrmals Geld zu überweisen, um seinen Ruf zu wahren.

Durch die Ermittlungen von Tuoi Tre wurde Herr H. nach einem perfekten Szenario auf organisierte Weise betrogen. Bei diesem Betrug wurde Herr H. zweimal durch Deepfake getäuscht. Das erste Mal war es ein Videoanruf und das zweite Mal ein Sexvideo.

Bemerkenswert ist, dass das Gesicht von Herrn H. im Sexvideo so gekonnt implantiert wurde, dass die Zuschauer kaum glauben konnten, dass es sich um ein Video mit Gesichtstransplantation handelte. Ein KI-Experte bestätigte Tuoi Tre , dass die Bösewichte ein neues KI-Tool verwendet haben, mit dem Gesichter perfekt in Videos implantiert werden können – wie echte.

Es gibt zahlreiche KI-Tools zum Gesichtsaustausch

Derzeit gibt es viele KI-Anwendungstools, die über Funktionen wie die Erstellung einer beliebigen Person mit dem gewünschten Gesicht und die Einfügung des gewünschten Gesichts in den Körper einer anderen Person verfügen.

Darunter befinden sich Tools mit Funktionen, die schlechten Zwecken dienen, wie etwa das Verwandeln normaler Fotos in Nacktfotos, indem die Person auf dem Foto „abgestreift“ wird, oder das Ersetzen des Gesichts einer Person in Videos durch ein gewünschtes Gesicht …

Die meisten dieser KI-Tools stehen als Testversion zur Verfügung. Wenn Sie jedoch dafür bezahlen, erhalten Sie alle Funktionen mit sehr schneller Transformationszeit.

Bei der Face-to-Body-Funktion müssen Nutzer beispielsweise lediglich zwei zueinander passende Fotos hochladen und einige Sekunden auf die Ergebnisse warten.

Oder mit der Funktion, aus normalen Fotos Nacktfotos zu erstellen, kann das KI-Tool dies sehr schnell erledigen, in nur wenigen Dutzend Sekunden, und den Betrachter zum Staunen bringen.

Sogar die Funktion zum Ersetzen von Gesichtern in Sexvideos erledigt das KI-Tool sehr schnell und benötigt bei Videos mit einer Länge von wenigen Sekunden weniger als eine Minute.

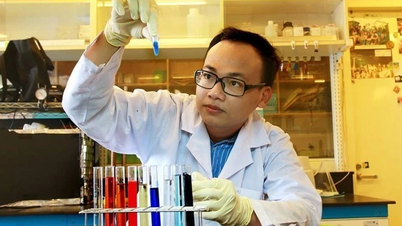

Im Gespräch mit Tuoi Tre analysierte Herr Nguyen Kim Tho, Leiter des Forschungs- und Entwicklungsteams des Cybersicherheitsunternehmens VNetwork, den Begriff Deepfake. Damit sind gefälschte Videos und Bilder gemeint, die mithilfe künstlicher Intelligenz erstellt wurden, um den Betrachtern vorzugaukeln, sie seien echt.

Die Deepfake-Technologie verwendet Deep-Learning-Modelle wie neuronale Netzwerke, um die Gesichts- und Stimmdaten einer Person zu analysieren und gefälschte Inhalte zu erstellen, die genau wie diese Person aussehen.

„Dank leistungsstarker Algorithmen können Kriminelle das Gesicht des Opfers in sensible Videos (z. B. „Bett“-Videos, Pornos) einfügen oder Bilder bearbeiten, um gefälschte Nacktfotos zu erstellen.

„Deepfake-Software und -Anwendungen erfreuen sich mittlerweile im Internet großer Beliebtheit, sogar bei mobilen Anwendungen, Open-Source-Code oder kostenlosen Online-Diensten. Dadurch hat jeder leicht Zugriff auf Tools zum Erstellen gefälschter Videos und Fotos. Daher ist Wachsamkeit geboten“, sagte Herr Tho.

Finger weg vom „Sex-Chat“

Viele Betrügereien beginnen damit, online Freundschaften zu schließen und das Opfer dann zu einem „Sex-Chat“ zu verleiten oder vertrauliche Fotos zu senden. Daher sollten Nutzer niemals private Fotos oder Videos an Personen senden, die sie nur online kennengelernt haben, egal welche Versprechungen oder Drohungen sie machen.

Denken Sie immer daran, dass alle geteilten Inhalte (auch über private Nachrichten) aufgezeichnet (Screenshot, Video) und dann bearbeitet und gegen Sie verwendet werden können.

Seien Sie bei Videoanrufen vorsichtig, wenn Fremde nach vertraulichen Inhalten fragen – es könnte sich um einen gefälschten Bildschirm handeln oder es handelt sich um eine Aufzeichnung.

Cybersicherheitsexperten raten Benutzern, niemals jemandem zu vertrauen, der nur online Kontakt aufnimmt, und die Identität und Absichten der anderen Person zu überprüfen, bevor sie vertrauliche Informationen preisgeben.

Wenn Sie außerdem eine SMS oder einen Anruf erhalten, in dem mit der Veröffentlichung „heißer“ Fotos gedroht wird, um Sie zu erpressen, müssen Benutzer keine Angst haben oder sich mit der Überweisung beeilen.

Eine Zahlung ist keine Garantie dafür, dass die Kriminellen das Video löschen. Experten zufolge könnten sie weiterhin höhere Preise verlangen oder den Inhalt trotzdem online stellen.

Anstatt den Aufforderungen der Kriminellen Folge zu leisten, sollten Benutzer Beweise (Nachrichten, Telefonnummern, Kontaktkonten, bedrohliche Inhalte usw.) sammeln und diese umgehend der nächstgelegenen Polizeidienststelle melden oder den Vorfall über die VNeID-Anwendung des Ministeriums für öffentliche Sicherheit melden, um rechtzeitig Unterstützung zu erhalten.

Wie erkennt man das?

Laut Herrn Nguyen Kim Tho wird es immer schwieriger, zwischen echten Bildern und Videos und Deepfakes zu unterscheiden, es gibt jedoch immer noch einige Erkennungsmerkmale und unterstützende Tools.

Benutzer können manuell beobachten, da Deepfake-Inhalte manchmal Auffälligkeiten in Bild und Ton aufweisen.

Beispielsweise kann ein zusammengesetztes Bild Rauschen oder Farbunterschiede zwischen dem zusammengesetzten Gesicht und dem Körper aufweisen. Bei einem gefälschten Video kann es zu Audio- und Video-Fehlanpassungen kommen (Lippenbewegungen, die nicht zur Sprache passen) oder Gesichtsausdrücke, die steif und unnatürlich wirken.

Zuvor kam es in einigen Deepfake-Videos vor, dass die Figuren nicht blinzelten oder die Beleuchtung und Schatten im Gesicht nicht zum Kontext passten – Anzeichen dafür, dass das Video bearbeitet wurde.

Obwohl sich die Technologie verbessert (beispielsweise wurden bei neuen Deepfakes realistische Augenblinzelbewegungen hinzugefügt), können aufmerksame Zuschauer in Videos und Fotos immer noch einige unlogische Details erkennen.

Forscher entwickeln derzeit zahlreiche Algorithmen zur automatischen Erkennung von Deepfake-Spuren.

KI-generierte Inhalte hinterlassen oft in jedem Pixel einen unverwechselbaren „digitalen Fingerabdruck“, den Maschinen erkennen können.

Intel hat beispielsweise den ersten Echtzeit-Deepfake-Detektor vorgestellt, der Videos analysieren und feststellen kann, ob es sich bei den darin dargestellten Figuren um echte Menschen oder um KI-generierte Figuren handelt.

Darüber hinaus ermöglichen einige Websites den Benutzern das Hochladen von Videos und Fotos, um die Echtheit der Bilder zu überprüfen (z. B. Deepware, Sensity AI-Tools usw.). Diese Systeme werden ständig aktualisiert, um mit neuen Deepfake-Techniken Schritt zu halten.

Insbesondere können Benutzer die Quelle des Beitrags und den Kontext überprüfen, wenn sie auf ein sensibles Video oder Bild stoßen, da viele Deepfake-Videos über gefälschte Konten oder Bots in sozialen Netzwerken verbreitet werden.

Wenn vertrauliche Inhalte über eine Person aus einer inoffiziellen Quelle oder einem anonymen Konto stammen, seien Sie hinsichtlich ihrer Authentizität skeptisch. Sie können versuchen, die im Inhalt erwähnte Person direkt zu kontaktieren, um zu überprüfen, ob sie tatsächlich der Urheber ist.

Darüber hinaus fördern Projekte wie die Einbettung von Authentifizierungsinformationen (digitale Signaturen) in Fotos und Videos bereits bei der Erstellung, um Originalinhalte von bearbeiteten Inhalten zu unterscheiden. „In Zukunft können Nutzer diese Authentifizierungszeichen verwenden, um vertrauenswürdige Inhalte zu identifizieren“, sagte Herr Tho.

5 Hinweise zum Selbstschutz

1. Beschränken Sie die Weitergabe sensibler, privater Fotos und Videos (insbesondere Nacktfotos, Familienfotos, Kinderfotos).

2. Stellen Sie Ihre Social-Media-Konten auf privat (teilen Sie sie nur mit vertrauenswürdigen Personen).

3. Geben Sie in öffentlichen sozialen Netzwerken nicht zu viele persönliche Informationen (vollständiger Name, Telefonnummer, Adresse usw.) preis.

4. Legen Sie sichere Passwörter fest und aktivieren Sie die zweistufige Verifizierung für Ihre Konten, um Hackerangriffe zu vermeiden.

5. Suchen Sie regelmäßig bei Google nach Ihrem Namen und Bild (oder verwenden Sie Tools zur umgekehrten Bildsuche wie Google Image oder TinEye), um festzustellen, ob Ihre Fotos ohne Erlaubnis veröffentlicht wurden, und fordern Sie umgehend deren Entfernung an.

Quelle: https://tuoitre.vn/dung-ai-ghep-hinh-anh-nhay-cam-de-tong-tien-20250317075948373.htm

![[Foto] Chefredakteur der Nhan Dan Zeitung Le Quoc Minh empfing die Arbeitsdelegation der Pasaxon Zeitung](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/23/da79369d8d2849318c3fe8e792f4ce16)

![[Foto] Premierminister Pham Minh Chinh leitet die 14. Sitzung des Lenkungsausschusses für IUU](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/23/a5244e94b6dd49b3b52bbb92201c6986)

![[Foto] Feierliche Eröffnung des 1. Kongresses der Parteidelegierten der zentralen Parteiagenturen](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/9/24/82a89e250d4d43cbb6fcb312f21c5dd4)

Kommentar (0)