Die explosionsartige Verbreitung des Internets und der sozialen Netzwerke hat dazu geführt, dass benutzergenerierte Inhalte immer beliebter wurden, gleichzeitig aber auch zu einer weitverbreiteten Welle von Fake News und inoffiziellen Nachrichten geführt.

Diese Falschinformationen führen nicht nur zu Verwirrung bei den Menschen in sensiblen Bereichen wie Gesundheit, Naturkatastrophen, öffentliche Ordnung usw., sondern haben auch schwerwiegende Folgen wie wirtschaftliche Verluste, einen Verlust des Rufs der Organisation und eine Gefährdung der nationalen Sicherheit.

VeGraph ist eine Methode zur Informationsüberprüfung, die von einem Team von Ingenieuren des Viettel Data Services and Artificial Intelligence Center (Viettel AI) erforscht und entwickelt wurde (Foto: Viettel AI).

Hatten diese Informationen in der Vergangenheit nur eine begrenzte Zeit und Reichweite, werden sie heute zunehmend gefährlich, wenn sie Teil der Eingabedaten für Systeme der künstlichen Intelligenz (KI) werden. Bei der Suche und Sammlung von Informationen zur Beantwortung von Benutzeranfragen sind Systeme wie Chatbots und virtuelle Assistenten durchaus in der Lage, falsche Informationen zu verwenden, zu erstellen oder zu verbreiten, wenn sie nicht über die Fähigkeit zur Selbstverifizierung verfügen.

Faktencheck ist der Prozess, bei dem überprüft wird, ob eine Information wahr oder falsch ist. Ziel des Faktenchecks der Aussage „Die NASA hat Leben auf dem Mars gefunden“ ist es beispielsweise zu prüfen, ob die Information auf veröffentlichten Fakten basiert, die auf zuverlässigen Quellen wie Zeitungen, wissenschaftlichen Daten oder Wissensdatenbanken beruhen.

Um Informationen selbst zu verifizieren, müssen KI-Systeme in der Lage sein, Sätze zu verstehen, relevante Informationen zu finden und auf der Grundlage objektiver Daten logische Schlussfolgerungen zu ziehen.

VeGraph (Verify-in-the-Graph) ist eine Methode zur Informationsüberprüfung, die von einem Team von Ingenieuren des Viettel Data Services and Artificial Intelligence Center (Viettel AI) auf der NAACL 2025 – einer der drei führenden internationalen Konferenzen zur Verarbeitung natürlicher Sprache – erforscht, entwickelt und vorgestellt wurde.

Experimentelle Ergebnisse mit zwei beliebten Validierungsdatensätzen, HoVer und FEVEROUS, zeigen, dass VeGraph die Genauigkeit im Vergleich zu bestehenden Methoden um 2–5 % verbessert.

Die meisten aktuellen Methoden zur Faktenprüfung haben immer noch Schwierigkeiten mit mehrdeutigen, metaphorischen oder vielschichtigen Aussagen, die oft dazu verwendet werden, falsche Informationen zu „tarnen“. Sie können auch nicht klar erklären, warum ein Inhalt als falsch angesehen wird, was es für die Benutzer schwierig macht, den Ergebnissen zu vertrauen.

Viele Methoden basieren zudem stark auf großen Sprachmodellen (LLMs), denen die Möglichkeit eines Abgleichs mit maßgeblichen Wissensquellen fehlt. Dadurch besteht die Gefahr, dass falsche Schlussfolgerungen gezogen werden, die auch als „Halluzination“ bezeichnet werden.

Im Gegensatz zu Tools, die nur interne Schlussfolgerungen innerhalb des Modells ziehen, zerlegt VeGraph die Informationsüberprüfungsanfrage proaktiv in kleine Sätze und vergleicht diese anschließend mit zuverlässigen Referenzen wie Rechtsdokumenten, behördlichen Datenbanken, Fachdokumenten usw. Der gesamte Überprüfungsprozess ist in klare Schritte systematisiert, was die Nachverfolgung und Überprüfung für Nutzer erleichtert und die Genauigkeit erhöht – ein zunehmend wichtiger Faktor bei KI-Anwendungen. Diese Funktion ermöglicht es Unternehmen zudem, das System bei Bedarf schnell anzupassen und zu verbessern.

VeGraph zielt auf eine transparente und sichere digitale Umgebung ab und wird für seine praktische Anwendung hoch geschätzt. Neben der Fähigkeit, sich in KI-Systeme zu integrieren, um die Genauigkeit zu erhöhen, kann diese Technologie zu einem Informationsverifizierungssystem in vielen Bereichen wie Gesundheitswesen, Journalismus, Recht oder Staatsverwaltung weiterentwickelt werden. Dadurch können Menschen wichtige Informationen, die eine hohe Authentizität erfordern, wie aktuelle Nachrichten, Informationen über Medikamente, Impfstoffe, Arzneimittel oder gesetzliche Bestimmungen, selbst verifizieren.

Systeme wie Chatbots und virtuelle Assistenten sind durchaus in der Lage, falsche Informationen zu verwenden, zu erstellen oder zu verbreiten, wenn sie nicht zur Selbstverifizierung fähig sind (Foto: Viettel AI).

In Zukunft wird VeGraph erweitert, um verschiedene Datenformate wie Bilder, Videos, Audio usw. zu verarbeiten, komplexe Sprachformen wie Metaphern und Implikationen zu erkennen und Wissensgraphen einzubinden, um die Denkfähigkeiten zu verbessern.

NAACL 2025 (Annual Conference of the Nations of the Americas Chapter of the Association for Computational Linguistics) ist das weltweit führende wissenschaftliche Forum in den Bereichen natürliche Sprachverarbeitung und Computerlinguistik.

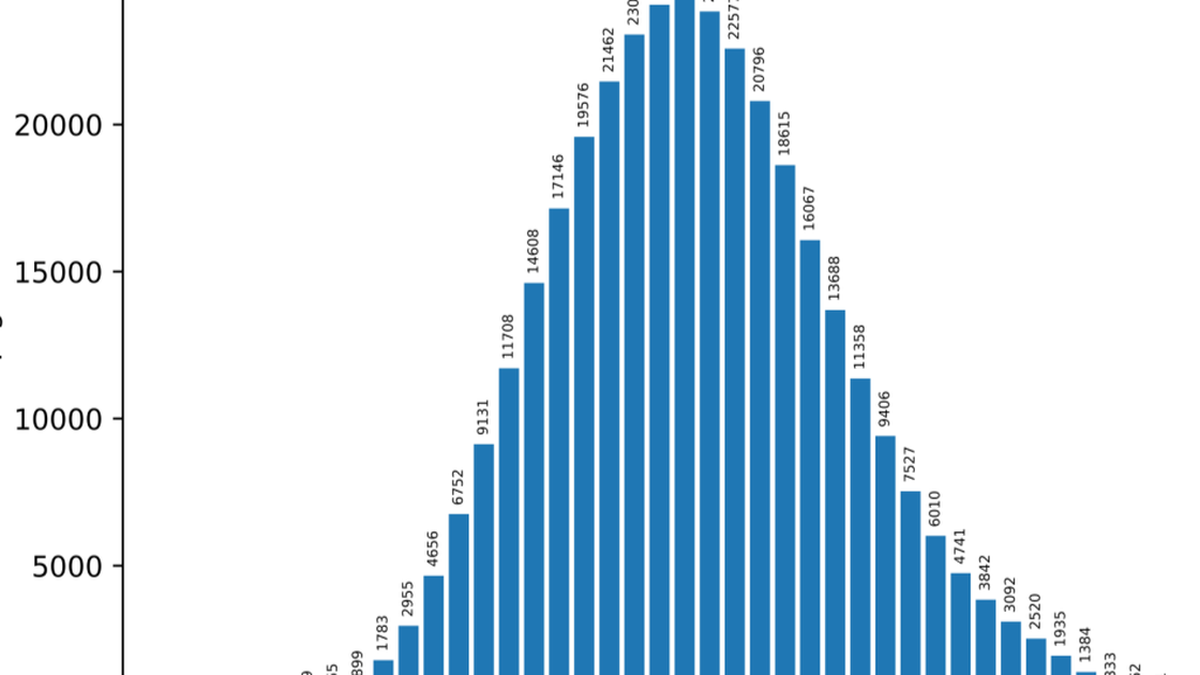

In diesem Jahr verzeichnete die Konferenz über 3.000 Beiträge, wobei die Annahmequote für Mainstream-Beiträge sehr hoch war (ca. 22 %). Sie vereinte die bahnbrechendsten Forschungsergebnisse. Der Schwerpunkt der NAACL 2025 liegt auf bahnbrechenden Fortschritten in der Entwicklung großer Sprachmodelle, der interkulturellen und mehrsprachigen Verarbeitung natürlicher Sprache, neuen Inferenzfähigkeiten und verantwortungsvoller KI.

Viettel AI ist eine Einheit der Military Industry – Telecommunications Group (Viettel) – einem Pionier in der Entwicklung und Entwicklung von Produkten und Dienstleistungen in den Bereichen KI, Big Data, Robotik und Digital Twin.

Derzeit umfasst das Viettel AI-Ökosystem viele Produktlinien mit führender Qualität in Vietnam, denen viele große nationale und internationale Organisationen und Unternehmen vertrauen und die sie nutzen.

Quelle: https://dantri.com.vn/cong-nghe/khi-ai-biet-kiem-chung-thong-tin-buoc-tien-moi-tu-viettel-ai-tai-naacl-2025-20250519084620026.htm

Kommentar (0)