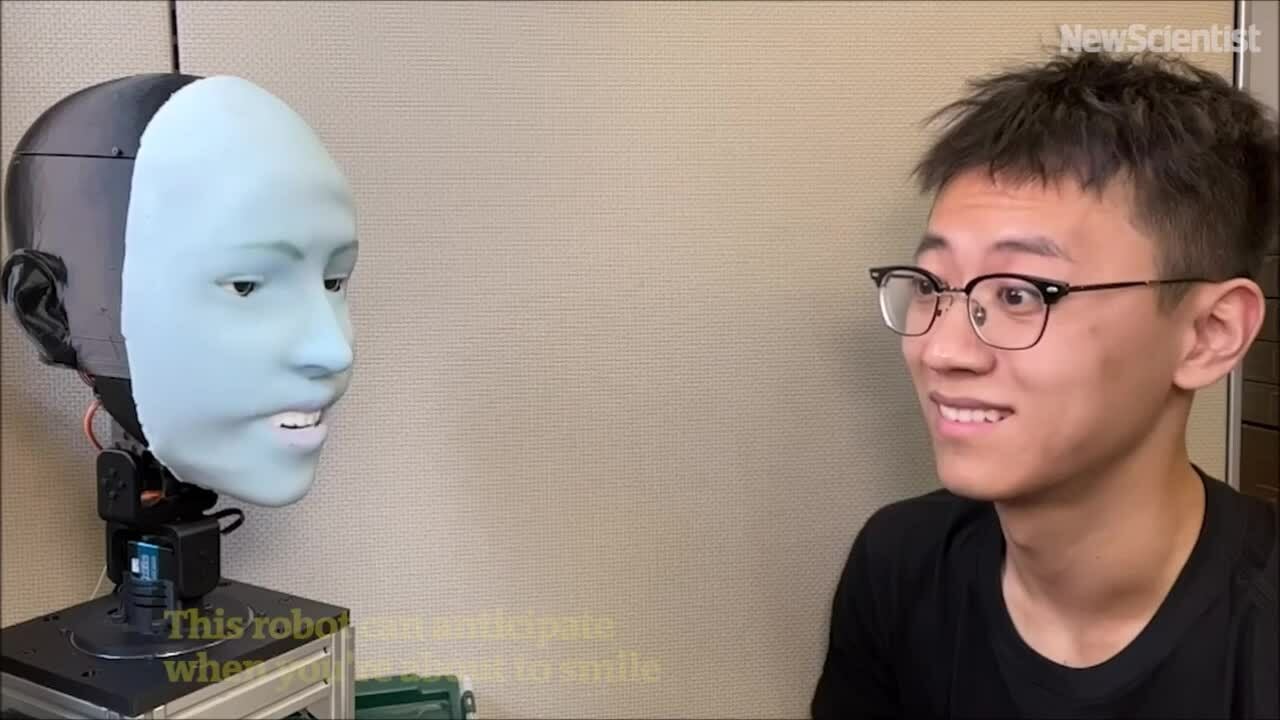

Der amerikanische Roboter Emo kann Lächeln etwa 840 Millisekunden vor dem Lächeln seines Gegenübers vorhersagen und lächelt dann gleichzeitig.

Emo Robot kann den Gesichtsausdruck seines Gegenübers voraussagen und gleichzeitig lächeln. Video : New Scientist

Menschen gewöhnen sich zunehmend an Roboter, die fließend sprachlich kommunizieren können, was unter anderem auf Fortschritte bei großen Sprachmodellen wie ChatGPT zurückzuführen ist. Ihre nonverbalen Kommunikationsfähigkeiten, insbesondere die Mimik, hinken jedoch noch weit hinterher. Die Entwicklung eines Roboters, der nicht nur eine Vielzahl von Gesichtsausdrücken beherrscht, sondern diese auch im richtigen Moment einsetzen kann, ist äußerst schwierig.

Das Creative Machines Lab der School of Engineering der Columbia University arbeitet seit mehr als fünf Jahren an diesem Problem. In einer neuen Studie, die in der Fachzeitschrift Science Robotics veröffentlicht wurde, stellte das Team Emo vor, einen KI-Roboter, der menschliche Gesichtsausdrücke vorhersagen und in Echtzeit ausführen kann, berichtete TechXplore am 27. März. Er erkennt Lächeln etwa 840 Millisekunden vor dem Lächeln der Person und lächelt dann im richtigen Moment.

Emo ist ein humanoider Roboter mit einem Gesicht, das mit 26 Aktuatoren ausgestattet ist und vielfältige Ausdrucksmöglichkeiten bietet. Der Kopf des Roboters ist mit weicher Silikonhaut überzogen und verfügt über ein magnetisches Verbindungssystem, das schnelle Anpassungen und Wartung ermöglicht. Für noch intensivere Interaktionen integrierte das Team hochauflösende Kameras in die Pupillen jedes Auges. Dadurch kann Emo mit ihren Augen interagieren, was für die nonverbale Kommunikation wichtig ist.

Das Team entwickelte zwei KI-Modelle. Das erste Modell prognostizierte menschliche Gesichtsausdrücke durch die Analyse subtiler Veränderungen im gegenüberliegenden Gesicht, und das zweite Modell generierte anhand der entsprechenden Ausdrücke motorische Befehle.

Um dem Roboter das Ausdrücken von Emotionen beizubringen, platzierte das Team Emo vor einer Kamera und ließ ihn zufällige Bewegungen ausführen. Nach einigen Stunden lernte der Roboter die Beziehung zwischen Gesichtsausdruck und motorischen Befehlen – ähnlich wie Menschen Mimik üben, indem sie in einen Spiegel schauen. Das Team nennt dies „Selbstmodellierung“ – ähnlich wie Menschen sich vorstellen, bestimmte Ausdrücke zu machen.

Anschließend spielte das Team Videos menschlicher Gesichtsausdrücke vor, die Emo Bild für Bild beobachten konnte. Nach stundenlangem Training konnte Emo Ausdrücke vorhersagen, indem er die subtilen Veränderungen im Gesicht einer Person beobachtete, wenn diese zu lächeln begann.

„Ich denke, die genaue Vorhersage menschlicher Gesichtsausdrücke ist eine Revolution auf dem Gebiet der Mensch-Roboter-Interaktion. Bisher waren Roboter nicht darauf ausgelegt, bei Interaktionen menschliche Ausdrücke zu berücksichtigen. Jetzt können Roboter Gesichtsausdrücke integrieren, um zu reagieren“, sagte Yuhang Hu, Doktorand im Creative Machines Lab und Mitglied des Forschungsteams.

„Wenn Roboter gleichzeitig mit Menschen in Echtzeit Mimik zeigen, verbessert das nicht nur die Qualität der Interaktion, sondern trägt auch dazu bei, Vertrauen zwischen Mensch und Roboter aufzubauen. Wenn Sie in Zukunft mit einem Roboter interagieren, wird dieser Ihre Mimik beobachten und interpretieren, genau wie ein echter Mensch“, fügte Hu hinzu.

Thu Thao (laut TechXplore )

[Anzeige_2]

Quellenlink

![[Maritime News] Mehr als 80 % der weltweiten Containerschifffahrtskapazität liegen in den Händen von MSC und großen Schifffahrtsallianzen](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/7/16/6b4d586c984b4cbf8c5680352b9eaeb0)

Kommentar (0)