Η σύνθετη εικόνα της χρήσης ρομπότ-δολοφόνων τεχνητής νοημοσύνης

Το να επιτραπεί στην Τεχνητή Νοημοσύνη να ελέγχει τα οπλικά συστήματα θα μπορούσε να σημαίνει ότι οι στόχοι θα εντοπίζονται, θα δέχονται επιθέσεις και θα καταστρέφονται χωρίς ανθρώπινη παρέμβαση. Αυτό εγείρει σοβαρά νομικά και ηθικά ερωτήματα.

Υπογραμμίζοντας τη σοβαρότητα της κατάστασης, ο Αυστριακός Υπουργός Εξωτερικών Αλεξάντερ Σάλενμπεργκ δήλωσε: «Αυτή είναι η Στιγμή Οπενχάιμερ της γενιάς μας».

Τα ρομπότ και τα όπλα που χρησιμοποιούν τεχνητή νοημοσύνη αρχίζουν να χρησιμοποιούνται ευρέως στους στρατούς πολλών χωρών. Φωτογραφία: Forbes

Πράγματι, το κατά πόσον το «τζίνι έχει δραπετεύσει από το μπουκάλι» έχει γίνει ένα πιεστικό ερώτημα, καθώς τα drones και η τεχνητή νοημοσύνη (AI) έχουν χρησιμοποιηθεί ευρέως από στρατούς σε όλο τον κόσμο .

«Η χρήση drones στις σύγχρονες συγκρούσεις από τη Ρωσία και την Ουκρανία, η χρήση drones από τις ΗΠΑ σε στοχευμένες επιχειρήσεις επιθέσεων στο Αφγανιστάν και το Πακιστάν και, όπως αποκαλύφθηκε πρόσφατα τον περασμένο μήνα, στο πλαίσιο του προγράμματος Lavender του Ισραήλ, δείχνει πώς οι δυνατότητες επεξεργασίας πληροφοριών της Τεχνητής Νοημοσύνης χρησιμοποιούνται ενεργά από τους στρατούς του κόσμου για την ενίσχυση της επιθετικής τους ισχύος», δήλωσε ο αναλυτής άμυνας της GlobalData, Wilson Jones.

Έρευνες του Γραφείου Διερευνητικής Δημοσιογραφίας Πολέμου με έδρα το Λονδίνο διαπίστωσαν ότι το σύστημα τεχνητής νοημοσύνης Lavender του ισραηλινού στρατού είχε ποσοστό ακρίβειας 90% στην αναγνώριση ατόμων με δεσμούς με τη Χαμάς, που σημαίνει ότι το 10% δεν είχε. Αυτό είχε ως αποτέλεσμα τον θάνατο αμάχων λόγω των δυνατοτήτων αναγνώρισης και λήψης αποφάσεων της τεχνητής νοημοσύνης.

Μια απειλή για την παγκόσμια ασφάλεια

Η χρήση της Τεχνητής Νοημοσύνης με αυτόν τον τρόπο τονίζει την ανάγκη διαχείρισης της τεχνολογίας στα οπλικά συστήματα.

«Η χρήση της Τεχνητής Νοημοσύνης (ΤΝ) σε οπλικά συστήματα, ειδικά όταν χρησιμοποιείται για στόχευση, εγείρει θεμελιώδη ερωτήματα για εμάς - τους ανθρώπους - και τη σχέση μας με τον πόλεμο , και πιο συγκεκριμένα για τις υποθέσεις μας σχετικά με το πώς θα μπορούσαμε να χρησιμοποιήσουμε βία σε ένοπλες συγκρούσεις», εξήγησε στο Army Technology ο Δρ. Alexander Blanchard, ανώτερος ερευνητής στο πρόγραμμα Διακυβέρνησης της Τεχνητής Νοημοσύνης στο Διεθνές Ινστιτούτο Έρευνας για την Ειρήνη της Στοκχόλμης (SIPRI), μια ανεξάρτητη ερευνητική ομάδα που επικεντρώνεται στην παγκόσμια ασφάλεια.

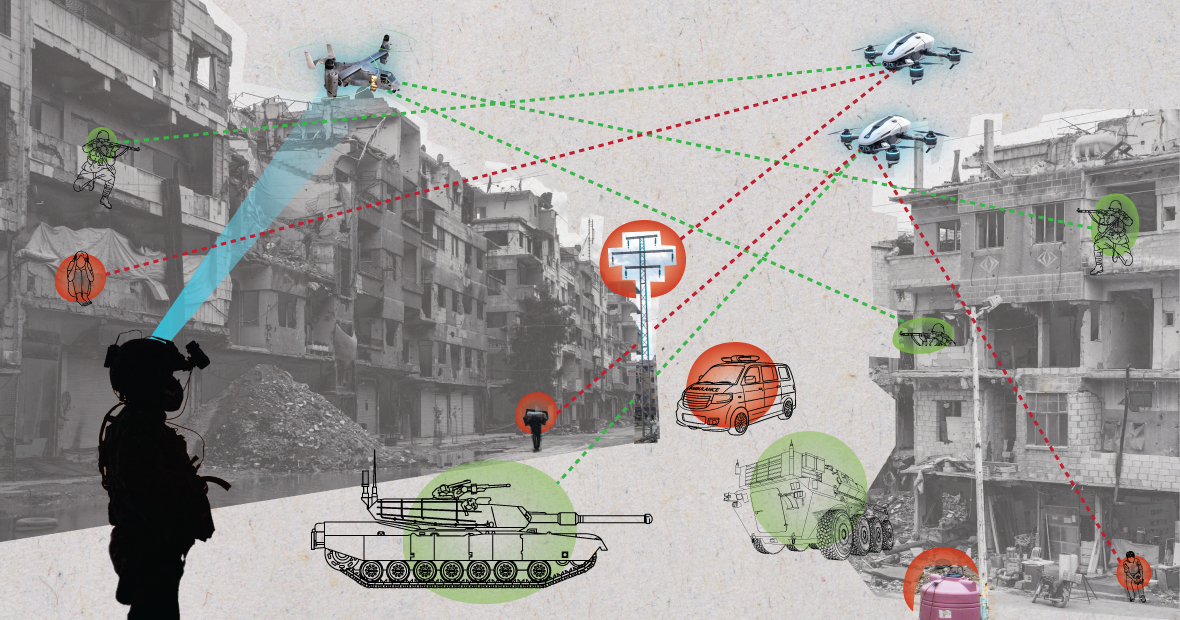

Τα συστήματα τεχνητής νοημοσύνης, όταν χρησιμοποιούνται σε χαοτικά περιβάλλοντα, μπορούν να συμπεριφέρονται απρόβλεπτα και ενδέχεται να μην καταφέρουν να εντοπίσουν με ακρίβεια τους στόχους. Φωτογραφία: MES

«Αλλάζει η Τεχνητή Νοημοσύνη τον τρόπο με τον οποίο ο στρατός επιλέγει στόχους και εφαρμόζει βία σε αυτούς; Αυτές οι αλλαγές, με τη σειρά τους, εγείρουν μια σειρά από νομικά, ηθικά και επιχειρησιακά ερωτήματα. Οι μεγαλύτερες ανησυχίες είναι ανθρωπιστικές», πρόσθεσε ο Δρ. Μπλανσάρ.

«Πολλοί ανησυχούν ότι, ανάλογα με τον τρόπο σχεδιασμού και χρήσης των αυτόνομων συστημάτων, θα μπορούσαν να θέσουν τους πολίτες και άλλους που προστατεύονται από το διεθνές δίκαιο σε μεγαλύτερο κίνδυνο», εξήγησε ο ειδικός του SIPRI. «Αυτό συμβαίνει επειδή τα συστήματα τεχνητής νοημοσύνης, ειδικά όταν χρησιμοποιούνται σε χαοτικά περιβάλλοντα, μπορούν να λειτουργούν απρόβλεπτα και ενδέχεται να μην εντοπίσουν με ακρίβεια στόχους και να επιτεθούν σε πολίτες ή να εντοπίσουν μαχητές που δεν βρίσκονται σε μάχη».

Αναλύοντας το ζήτημα, ο αναλυτής άμυνας της GlobalData, Wilson Jones, σημείωσε ότι το ζήτημα του τρόπου με τον οποίο καθορίζεται η ενοχή θα μπορούσε να είναι αμφισβητήσιμο.

«Σύμφωνα με το ισχύον δίκαιο του πολέμου, υπάρχει η έννοια της ευθύνης της διοίκησης», δήλωσε ο κ. Τζόουνς. «Αυτό σημαίνει ότι ένας αξιωματικός, στρατηγός ή άλλος ηγέτης είναι νομικά υπεύθυνος για τις ενέργειες των στρατευμάτων υπό τη διοίκησή του. Εάν τα στρατεύματα διαπράξουν εγκλήματα πολέμου, ο αξιωματικός είναι υπεύθυνος ακόμη και αν δεν έδωσε τις εντολές. Το βάρος της απόδειξης βαρύνει τον ίδιο να αποδείξει ότι έκανε ό,τι ήταν δυνατόν για να αποτρέψει τα εγκλήματα πολέμου».

«Με τα συστήματα Τεχνητής Νοημοσύνης, αυτό περιπλέκει τα πράγματα. Είναι υπεύθυνος ένας τεχνικός πληροφορικής; Ένας σχεδιαστής συστημάτων; Δεν είναι σαφές. Εάν δεν είναι σαφές, δημιουργεί ηθικό κίνδυνο εάν οι δρώντες πιστεύουν ότι οι πράξεις τους δεν προστατεύονται από τους ισχύοντες νόμους», τόνισε ο κ. Τζόουνς.

Ένας Αμερικανός στρατιώτης κάνει περιπολία με ένα ρομποτικό σκύλο. Φωτογραφία: Forbes

Συμβάσεις για τον έλεγχο των όπλων Αρκετές σημαντικές διεθνείς συμφωνίες περιορίζουν και ρυθμίζουν ορισμένες χρήσεις όπλων. Υπάρχουν απαγορεύσεις χημικών όπλων, συνθήκες μη διάδοσης πυρηνικών όπλων και η Σύμβαση για ορισμένα συμβατικά όπλα, η οποία απαγορεύει ή περιορίζει τη χρήση συγκεκριμένων όπλων που θεωρείται ότι προκαλούν περιττά ή αδικαιολόγητα βάσανα στους εμπόλεμους ή ότι επηρεάζουν αδιακρίτως τους αμάχους.

«Ο έλεγχος των πυρηνικών όπλων απαιτούσε δεκαετίες διεθνούς συνεργασίας και επακόλουθων συνθηκών για την επιβολή τους», εξηγεί ο αναλυτής άμυνας Γουίλσον Τζόουνς. «Ακόμα και τότε, συνεχίσαμε τις ατμοσφαιρικές δοκιμές μέχρι τη δεκαετία του 1990. Ένας σημαντικός λόγος για τον οποίο η μη διάδοση των πυρηνικών όπλων ήταν επιτυχής ήταν η συνεργασία μεταξύ των Ηνωμένων Πολιτειών και της Σοβιετικής Ένωσης στη διπολική παγκόσμια τάξη. Αυτή δεν υπάρχει πλέον και η τεχνολογία που δημιουργεί την Τεχνητή Νοημοσύνη είναι πιο προσβάσιμη σε πολλές χώρες από την πυρηνική ενέργεια».

«Μια δεσμευτική συνθήκη θα έπρεπε να φέρει όλους τους σχετικούς παράγοντες στο τραπέζι των διαπραγματεύσεων για να συμφωνήσουν να μην χρησιμοποιούν ένα εργαλείο που αυξάνει τη στρατιωτική τους ισχύ. Αυτό είναι απίθανο να λειτουργήσει, επειδή η Τεχνητή Νοημοσύνη μπορεί να βελτιώσει τη στρατιωτική αποτελεσματικότητα με ελάχιστο οικονομικό και υλικό κόστος».

Τρέχουσες γεωπολιτικές προοπτικές

Ενώ οι χώρες στα Ηνωμένα Έθνη έχουν αναγνωρίσει την ανάγκη για υπεύθυνη στρατιωτική χρήση της Τεχνητής Νοημοσύνης, υπάρχουν ακόμη πολλά που πρέπει να γίνουν.

«Χωρίς ένα σαφές κανονιστικό πλαίσιο, αυτοί οι ισχυρισμοί παραμένουν σε μεγάλο βαθμό φιλόδοξοι», δήλωσε η Laura Petrone, κύρια αναλύτρια της GlobalData, στο Army Technology. «Δεν αποτελεί έκπληξη το γεγονός ότι ορισμένες χώρες θέλουν να διατηρήσουν την κυριαρχία τους όταν αποφασίζουν για θέματα εσωτερικής άμυνας και εθνικής ασφάλειας, ειδικά στο τρέχον γεωπολιτικό κλίμα».

Η κα Petrone πρόσθεσε ότι ενώ ο νόμος της ΕΕ για την τεχνητή νοημοσύνη ορίζει ορισμένες απαιτήσεις για τα συστήματα τεχνητής νοημοσύνης, δεν αφορά τα συστήματα τεχνητής νοημοσύνης για στρατιωτικούς σκοπούς.

«Πιστεύω ότι παρά τον αποκλεισμό αυτό, ο νόμος περί τεχνητής νοημοσύνης αποτελεί μια σημαντική προσπάθεια για τη δημιουργία ενός πλαισίου για τις εφαρμογές τεχνητής νοημοσύνης, το οποίο θα μπορούσε να οδηγήσει σε κάποιο βαθμό ομοιομορφίας των σχετικών προτύπων στο μέλλον», σχολίασε. «Αυτή η ομοιομορφία θα είναι επίσης σημαντική για την τεχνητή νοημοσύνη στον στρατιωτικό τομέα».

Νγκουγιέν Καν

[διαφήμιση_2]

Πηγή: https://www.congluan.vn/moi-nguy-robot-sat-thu-ai-dang-de-doa-an-ninh-toan-cau-post304170.html

![Μετάβαση στο Dong Nai OCOP: [Άρθρο 3] Σύνδεση του τουρισμού με την κατανάλωση προϊόντων OCOP](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/10/1762739199309_1324-2740-7_n-162543_981.jpeg)

Σχόλιο (0)