Μια ομάδα εξέχοντων διεθνών εμπειρογνωμόνων συναντήθηκε στο Πεκίνο την περασμένη εβδομάδα, όπου εντόπισαν «κόκκινες γραμμές» στην ανάπτυξη της Τεχνητής Νοημοσύνης, συμπεριλαμβανομένης της δημιουργίας βιολογικών όπλων και της διεξαγωγής κυβερνοεπιθέσεων.

Σε δήλωσή τους λίγες ημέρες μετά τη συνάντηση, οι ακαδημαϊκοί προειδοποίησαν ότι απαιτείται μια κοινή προσέγγιση στην ασφάλεια της Τεχνητής Νοημοσύνης για την αποτροπή «καταστροφικών ή ακόμη και υπαρξιακών κινδύνων για την ανθρωπότητα στη ζωή μας».

«Στο αποκορύφωμα του Ψυχρού Πολέμου, η διεθνής κυβερνητική και επιστημονική συνεργασία βοήθησαν στην αποτροπή μιας πυρηνικής καταστροφής. Η ανθρωπότητα πρέπει για άλλη μια φορά να συνεργαστεί για να αποτρέψει την καταστροφή που θα μπορούσε να προκύψει από μια πρωτοφανή τεχνολογία», ανέφερε η δήλωση.

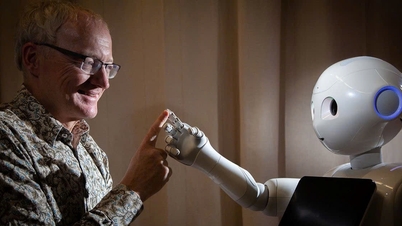

Ειδικοί στον Διεθνή Διάλογο για την Ασφάλεια της Τεχνητής Νοημοσύνης στο Πεκίνο έχουν εντοπίσει «κόκκινες γραμμές» στην ανάπτυξη της Τεχνητής Νοημοσύνης. Φωτογραφία: FT

Μεταξύ των υπογραφόντων περιλαμβάνονται οι Geoffrey Hinton και Yoshua Bengio, οι οποίοι συχνά περιγράφονται ως οι «πατέρες» της Τεχνητής Νοημοσύνης· ο Stuart Russell, καθηγητής πληροφορικής στο Πανεπιστήμιο της Καλιφόρνια· και ο Andrew Yao, ένας από τους πιο εξέχοντες επιστήμονες υπολογιστών της Κίνας.

Η δήλωση έρχεται μετά τον Διεθνή Διάλογο για την Ασφάλεια της Τεχνητής Νοημοσύνης στο Πεκίνο την περασμένη εβδομάδα, μια συνάντηση στην οποία παρευρέθηκαν αξιωματούχοι της κινεζικής κυβέρνησης για να εκφράσουν την επιδοκιμασία τους για το φόρουμ και τα αποτελέσματά του.

Ο πρόεδρος των ΗΠΑ Τζο Μπάιντεν και ο κινέζος πρόεδρος Σι Τζινπίνγκ συναντήθηκαν τον Νοέμβριο του περασμένου έτους και συζήτησαν για την ασφάλεια της τεχνητής νοημοσύνης, συμφωνώντας να ξεκινήσουν διάλογο για το θέμα. Κορυφαίες παγκόσμιες εταιρείες τεχνητής νοημοσύνης έχουν επίσης συναντηθεί κατ' ιδίαν με Κινέζους εμπειρογνώμονες τεχνητής νοημοσύνης τους τελευταίους μήνες.

Τον Νοέμβριο του 2023, 28 χώρες, συμπεριλαμβανομένης της Κίνας, και κορυφαίες εταιρείες τεχνητής νοημοσύνης συμφώνησαν σε μια ευρεία δέσμευση να συνεργαστούν για την αντιμετώπιση των υπαρξιακών κινδύνων που προκύπτουν από την προηγμένη τεχνητή νοημοσύνη κατά τη διάρκεια της συνόδου κορυφής για την ασφάλεια της τεχνητής νοημοσύνης του Βρετανού Υπουργού Οικονομικών Ρίσι Σούνακ.

Στο Πεκίνο την περασμένη εβδομάδα, ειδικοί συζήτησαν τις απειλές που σχετίζονται με την ανάπτυξη της «Τεχνητής Γενικής Νοημοσύνης – AGI», ή συστημάτων Τεχνητής Νοημοσύνης που είναι ίσα ή ανώτερα από τους ανθρώπους.

«Το βασικό επίκεντρο της συζήτησης ήταν οι κόκκινες γραμμές που κανένα ισχυρό σύστημα τεχνητής νοημοσύνης δεν πρέπει να παραβιάζει και που οι κυβερνήσεις σε όλο τον κόσμο θα πρέπει να επιβάλλουν στην ανάπτυξη και την εφαρμογή της τεχνητής νοημοσύνης», δήλωσε ο Μπέντζιο.

Αυτές οι κόκκινες γραμμές θα διασφάλιζαν ότι «κανένα σύστημα τεχνητής νοημοσύνης δεν μπορεί να αναπαραχθεί ή να βελτιωθεί χωρίς ρητή ανθρώπινη συγκατάθεση και υποστήριξη» ή «να λάβει μέτρα που αυξάνουν αδικαιολόγητα την ισχύ και την επιρροή του».

Οι επιστήμονες πρόσθεσαν ότι κανένα σύστημα δεν θα «ενίσχυε σημαντικά την ικανότητα των φορέων να σχεδιάζουν όπλα μαζικής καταστροφής, να παραβιάζουν τη σύμβαση για τα βιολογικά ή χημικά όπλα» ή να είναι σε θέση να «πραγματοποιούν αυτόματα κυβερνοεπιθέσεις που έχουν ως αποτέλεσμα σοβαρή οικονομική ζημία ή ισοδύναμη βλάβη».

Χοάνγκ Χάι (σύμφωνα με τους FT)

[διαφήμιση_2]

Πηγή

![[Φωτογραφία] Κοντινό πλάνο των σοβαρών ζημιών στο σχολείο που βρίσκεται στις όχθες του ποταμού Ban Thach](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F26%2F1764152130492_ndo_bl_img-8188-8805-jpg.webp&w=3840&q=75)

![[Φωτογραφία] Τα συναισθήματα των φοιτητών του VinUni εξυψώνονται με το "Homeland in the Heart: The Concert Film"](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F26%2F1764174931822_10-3878-jpg.webp&w=3840&q=75)

![[Φωτογραφία] Έναρξη της 28ης Συνόδου του Λαϊκού Συμβουλίου του Ανόι](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/26/1764155991133_image.jpeg)

Σχόλιο (0)