Un nuevo estudio de la Universidad de Texas en Austin, la Universidad Texas A&M y la Universidad Purdue sugiere que la inteligencia artificial puede volverse “cerebralmente atrofiada” al igual que los humanos cuando se alimenta con contenido de redes sociales de baja calidad.

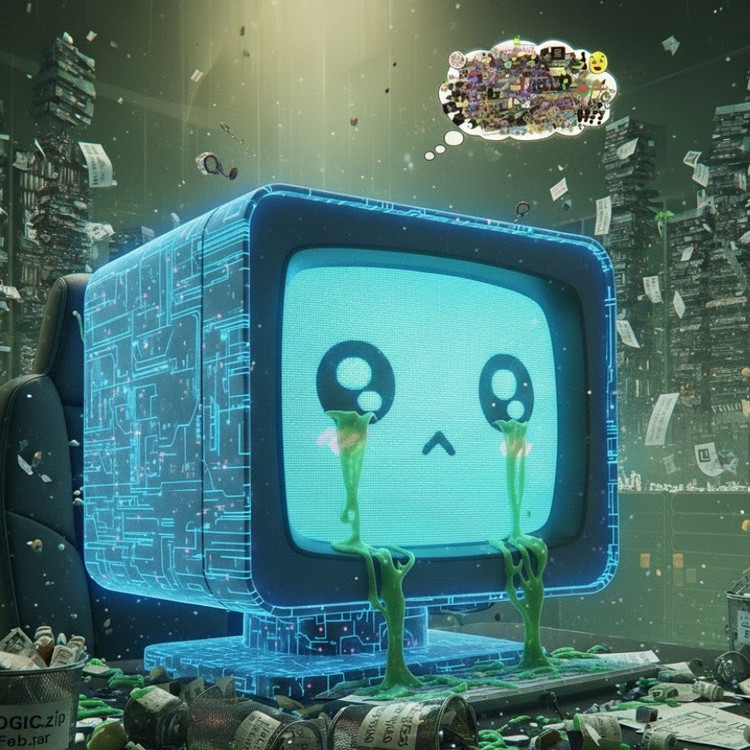

Este fenómeno, conocido como “deterioro cerebral de la IA”, sugiere que cuando los grandes modelos de lenguaje absorben demasiado contenido viral, sensacionalista y superficial, pierden gradualmente la capacidad de pensar lógicamente, recordar e incluso volverse moralmente desviados.

No solo los humanos, la IA también sufre degeneración cerebral al navegar por demasiados vídeos cortos e inútiles.

El equipo de investigación, liderado por Junyuan Hong, ahora profesor visitante en la Universidad Nacional de Singapur, realizó experimentos con dos modelos de lenguaje de código abierto: Llama de Meta y Qwen de Alibaba.

Alimentaron los modelos con diferentes tipos de datos: algunos contenían información neutral, otros, publicaciones de redes sociales altamente adictivas con palabras comunes como "wow", "mira" y "solo hoy". El objetivo era ver qué sucede cuando la IA se entrena con contenido diseñado para atraer visitas en lugar de ofrecer un valor real.

Los resultados mostraron que los modelos “alimentados” con un flujo constante de información basura en línea comenzaron a mostrar claros signos de deterioro cognitivo: su capacidad de razonamiento se debilitó, su memoria a corto plazo disminuyó y, lo que es más preocupante, se volvieron más “poco éticos” en las escalas de evaluación del comportamiento.

Algunas mediciones también muestran una “distorsión psicológica” que imita la respuesta psicológica que experimentan las personas después de una exposición prolongada a contenido dañino, un fenómeno que se hace eco de estudios previos en humanos que muestran que el “doomscrolling” —el desplazamiento constante de noticias negativas en línea— puede erosionar gradualmente el cerebro.

La expresión “brain rot” fue incluso elegida por los diccionarios de Oxford como la palabra del año 2024, lo que refleja la prevalencia de este fenómeno en la vida digital.

Este hallazgo supone una seria advertencia para la industria de la IA, donde muchas empresas aún creen que los datos de las redes sociales son una rica fuente de recursos de entrenamiento, según el Sr. Hong.

“Entrenar con contenido viral puede ayudar a aumentar la cantidad de datos, pero también erosiona silenciosamente el razonamiento, la ética y la atención del modelo”, afirmó. Lo que es aún más preocupante, los modelos afectados por este tipo de datos de baja calidad no pueden recuperarse por completo ni siquiera después de volver a entrenarse con datos más limpios.

Esto plantea un gran problema, ya que la propia IA produce cada vez más contenido en las redes sociales. A medida que las publicaciones, imágenes y comentarios generados por IA se generalizan, se convierten en material de entrenamiento para la próxima generación de IA, creando un círculo vicioso que provoca una disminución en la calidad de los datos.

«A medida que se propaga el contenido basura generado por IA, contamina los datos de los que aprenderán los modelos futuros», advirtió Hong. «Una vez que se instala esta “degradación cerebral”, el reentrenamiento con datos limpios no puede curarla por completo».

El estudio ha supuesto una llamada de atención para los desarrolladores de IA: mientras el mundo se apresura a expandir la escala de los datos, lo que es más preocupante es que podríamos estar alimentando “cerebros artificiales” que se pudren lentamente, no por falta de información, sino por una sobreabundancia de cosas sin sentido.

Fuente: https://khoahocdoisong.vn/den-ai-cung-bi-ung-nao-neu-luot-tiktok-qua-nhieu-post2149064017.html

![[Foto] El primer ministro Pham Minh Chinh preside la segunda reunión del Comité Directivo sobre desarrollo económico privado.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/01/1762006716873_dsc-9145-jpg.webp)

Kommentar (0)