اگر تا به حال در رسانههای اجتماعی گشت و گذار کرده باشید، احتمالاً با تصاویر یا ویدیوهایی که توسط هوش مصنوعی ساخته شدهاند، برخورد کردهاید. بسیاری از مردم فریب خوردهاند، مانند ویدیوی وایرال شدهی خرگوشهایی که روی ترامپولین میپرند. اما Sora - اپلیکیشن خواهر ChatGPT که توسط OpenAI توسعه داده شده است - ویدیوهای هوش مصنوعی را به سطح جدیدی میبرد و تشخیص محتوای جعلی را به طور فزایندهای ضروری میکند.

ابزارهای ویدیویی هوش مصنوعی، تشخیص ویدیوهای واقعی را از همیشه دشوارتر میکنند. (منبع: CNET)

این اپلیکیشن که در سال ۲۰۲۴ عرضه شد و اخیراً با Sora 2 ارتقا یافته است، رابط کاربری مشابه TikTok دارد که در آن همه ویدیوها با هوش مصنوعی تولید میشوند. ویژگی «حضور افتخاری» به افراد واقعی اجازه میدهد تا در فیلمهای شبیهسازی شده قرار گیرند و ویدیوهایی ایجاد کنند که به طرز ترسناکی واقعی هستند.

بنابراین، بسیاری از کارشناسان نگرانند که سورا باعث گسترش دیپفیک، تحریف اطلاعات و محو شدن مرز بین واقعیت و جعل شود. افراد مشهور به ویژه آسیبپذیر هستند و همین امر باعث شده سازمانهایی مانند SAG-AFTRA از OpenAI بخواهند تا محافظت از آنها را تقویت کند.

شناسایی محتوای تولید شده توسط هوش مصنوعی یک چالش بزرگ برای شرکتهای فناوری، پلتفرمهای رسانههای اجتماعی و کاربران است. اما روشهایی برای تشخیص ویدیوهای ایجاد شده با استفاده از Sora وجود دارد.

واترمارک سورا را پیدا کنید

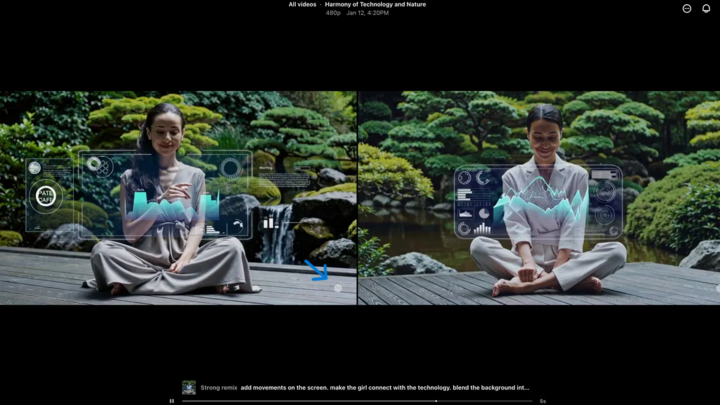

واترمارک Sora (که با فلش آبی مشخص شده است) نشانگری است که ابزار مورد استفاده برای ساخت ویدیو را مشخص میکند. (منبع: CNET)

هر ویدیویی که در برنامه Sora iOS ایجاد میشود، هنگام دانلود دارای یک واترمارک است - لوگوی سفید Sora (آیکون ابر) در لبههای ویدیو حرکت میکند، شبیه به واترمارک TikTok.

این یک روش بصری برای شناسایی محتوای تولید شده توسط هوش مصنوعی است. به عنوان مثال، مدل "نانو-موز" گوگل در Gemini نیز به طور خودکار یک واترمارک به تصاویر اضافه میکند. با این حال، واترمارکها همیشه قابل اعتماد نیستند. اگر واترمارک ثابت باشد، میتوان آن را به راحتی برش داد. حتی واترمارکهای پویا مانند واترمارک Sora را میتوان با استفاده از برنامههای تخصصی حذف کرد.

وقتی در این مورد از سم آلتمن، مدیرعامل OpenAI، سوال شد، او استدلال کرد که جامعه باید با این واقعیت که هر کسی میتواند ویدیوهای جعلی بسازد، سازگار شود. قبل از Sora، هرگز ابزاری وجود نداشت که تا این حد محبوب، در دسترس و بدون نیاز به مهارت برای ساخت چنین ویدیوهایی باشد. دیدگاه او بر لزوم تکیه بر روشهای تأیید جایگزین تأکید میکند.

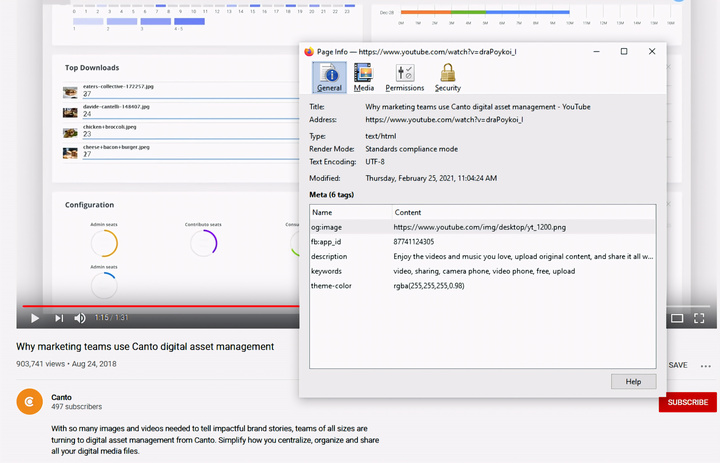

بررسی متادیتا

بررسی فرادادهها - گامی حیاتی در تعیین اینکه آیا یک ویدیو توسط هوش مصنوعی، مانند Sora، ساخته شده است یا خیر. (منبع: Canto)

ممکن است فکر کنید بررسی متادیتا خیلی پیچیده است، اما در واقع بسیار ساده و بسیار مؤثر است.

فراداده مجموعهای از اطلاعات است که به طور خودکار هنگام ایجاد محتوا به آن متصل میشود، مانند نوع دوربین، مکان، زمان ضبط و نام فایل. چه محتوا توسط انسان تولید شده باشد و چه توسط هوش مصنوعی، دارای فراداده است. در محتوای تولید شده توسط هوش مصنوعی، فراداده اغلب شامل اطلاعات انتساب منبع است.

OpenAI عضوی از ائتلاف منشأ و اصالت محتوا (C2PA) است، بنابراین ویدیوهای Sora حاوی فرادادههای C2PA خواهند بود. میتوانید این موضوع را با استفاده از ابزار تأیید اصالت محتوا تأیید کنید:

نحوه بررسی متادیتا:

- به verify.contentauthenticity.org مراجعه کنید

- فایل را آپلود کنید تا بررسی شود.

- «باز کردن» را فشار دهید

- اطلاعات را در جدول سمت راست مشاهده کنید.

اگر ویدیو توسط هوش مصنوعی ساخته شده باشد، خلاصه به وضوح این موضوع را بیان میکند. هنگام بررسی ویدیوهای Sora، عبارت «منتشر شده توسط OpenAI» و اطلاعاتی را مشاهده خواهید کرد که تأیید میکند ویدیو با استفاده از هوش مصنوعی ساخته شده است. همه ویدیوهای Sora باید این اطلاعات را داشته باشند تا منشأ آنها تأیید شود.

منبع: https://vtcnews.vn/cach-nhan-biet-video-that-hay-do-ai-tao-ar972891.html

![[تصویر] روحیه سرسخت مبارزه در فوتبال زنان ویتنامی](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F17%2F1765990260956_ndo_br_4224760955870434771-copy-jpg.webp&w=3840&q=75)

![[عکس] نخست وزیر فام مین چین از استاندار استان توچیگی (ژاپن) استقبال کرد](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765892133176_dsc-8082-6425-jpg.webp&w=3840&q=75)

![[زنده] مراسم اهدای جوایز اقدامات اجتماعی ۲۰۲۵](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765899631650_ndo_tr_z7334013144784-9f9fe10a6d63584c85aff40f2957c250-jpg.webp&w=3840&q=75)

![[عکس] نخست وزیر فام مین چین از وزیر آموزش و ورزش لائوس، تونگسالیت مانگنورمک، استقبال کرد.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765876834721_dsc-7519-jpg.webp&w=3840&q=75)

![[تصویر] تصاویر لو رفته پیش از مراسم اهدای جوایز اقدامات اجتماعی ۲۰۲۵.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765882828720_ndo_br_thiet-ke-chua-co-ten-45-png.webp&w=3840&q=75)

![[زنده] مراسم اختتامیه و اهدای جوایز مسابقه ساخت ویدیو/کلیپ «گردشگری چشمگیر ویتنام» ۲۰۲۵](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/17/1765974650260_z7273498850699-00d2fd6b0972cb39494cfa2559bf85ac-1765959338756946072104-627-0-1338-1138-crop-1765959347256801551121.jpeg)

نظر (0)