تصویر پیچیده استفاده از رباتهای قاتل هوش مصنوعی

اجازه دادن به هوش مصنوعی برای کنترل سیستمهای تسلیحاتی میتواند به این معنی باشد که اهداف بدون دخالت انسان شناسایی، مورد حمله قرار گرفته و نابود میشوند. این امر سوالات جدی قانونی و اخلاقی را مطرح میکند.

الکساندر شالنبرگ، وزیر امور خارجه اتریش، با تأکید بر وخامت اوضاع گفت: «این لحظه اوپنهایمر نسل ماست.»

رباتها و سلاحهای مجهز به هوش مصنوعی به طور گسترده در ارتش بسیاری از کشورها مورد استفاده قرار میگیرند. عکس: فوربس

در واقع، اینکه «غول تا چه حد از بطری خارج شده است» به یک سوال فوری تبدیل شده است، زیرا پهپادها و هوش مصنوعی (AI) به طور گسترده توسط ارتشهای سراسر جهان مورد استفاده قرار گرفتهاند.

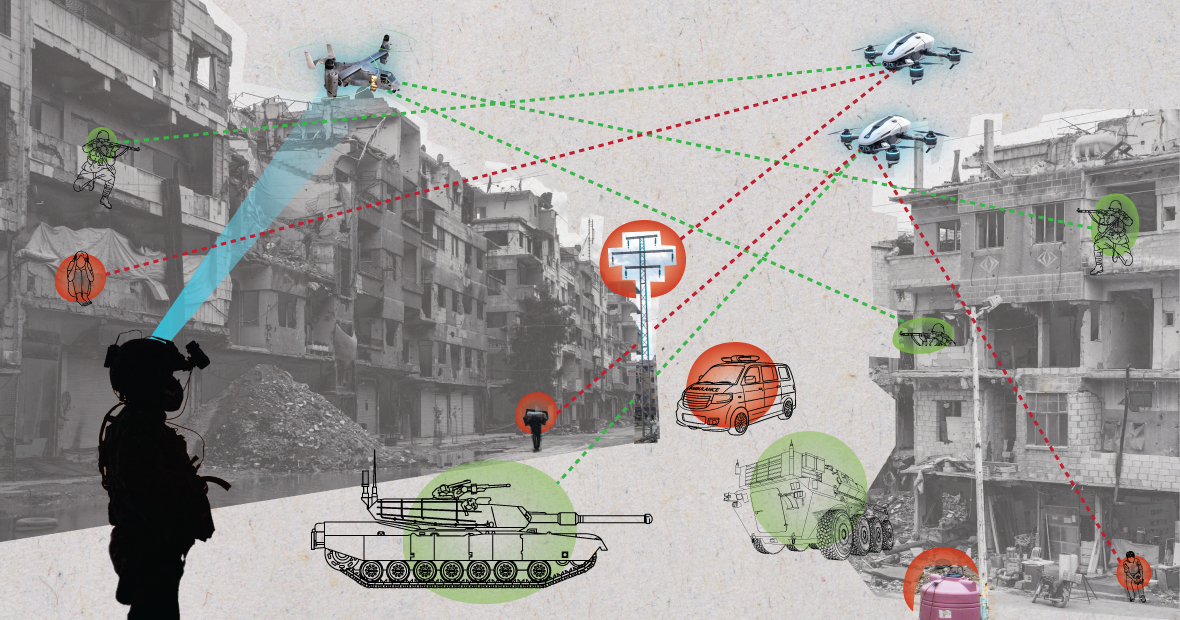

ویلسون جونز، تحلیلگر دفاعی گلوبال دیتا، گفت: «استفاده از پهپادها در درگیریهای مدرن توسط روسیه و اوکراین، استفاده از پهپادها توسط ایالات متحده در عملیاتهای تهاجمی هدفمند در افغانستان و پاکستان و همانطور که اخیراً ماه گذشته فاش شد، به عنوان بخشی از برنامه اسطوخودوس اسرائیل، نشان میدهد که چگونه قابلیتهای پردازش اطلاعات هوش مصنوعی به طور فعال توسط ارتشهای جهان برای افزایش قدرت تهاجمی آنها مورد استفاده قرار میگیرد.»

تحقیقات دفتر روزنامهنگاری تحقیقاتی جنگ مستقر در لندن نشان داد که سیستم هوش مصنوعی Lavender ارتش اسرائیل در شناسایی افراد مرتبط با حماس، ۹۰ درصد دقت دارد، به این معنی که ۱۰ درصد افراد با حماس مرتبط نیستند. این امر منجر به مرگ غیرنظامیان به دلیل قابلیتهای شناسایی و تصمیمگیری هوش مصنوعی شد.

تهدیدی برای امنیت جهانی

استفاده از هوش مصنوعی به این روش، بر لزوم مدیریت فناوری در سیستمهای تسلیحاتی تأکید دارد.

دکتر الکساندر بلانچارد، پژوهشگر ارشد برنامهی مدیریت هوش مصنوعی در مؤسسهی تحقیقات صلح بینالمللی استکهلم (SIPRI)، یک گروه تحقیقاتی مستقل با تمرکز بر امنیت جهانی، به نشریهی فناوری ارتش توضیح داد: «استفاده از هوش مصنوعی در سیستمهای تسلیحاتی، بهویژه هنگامی که برای هدفگیری استفاده میشود، پرسشهای اساسی را در مورد ما - انسانها - و رابطهی ما با جنگ ، و بهطور خاصتر، فرضیات ما در مورد چگونگی استفاده از خشونت در درگیریهای مسلحانه مطرح میکند.»

سیستمهای هوش مصنوعی، هنگامی که در محیطهای آشفته استفاده میشوند، میتوانند رفتاری غیرقابل پیشبینی داشته باشند و ممکن است در شناسایی دقیق اهداف شکست بخورند. عکس: MES

دکتر بلانچارد افزود: «آیا هوش مصنوعی نحوه انتخاب اهداف نظامی و اعمال زور بر آنها را تغییر میدهد؟ این تغییرات، به نوبه خود، انبوهی از سوالات حقوقی، اخلاقی و عملیاتی را مطرح میکنند. بزرگترین نگرانیها، بشردوستانه هستند.»

این کارشناس SIPRI توضیح داد: «بسیاری نگرانند که بسته به نحوه طراحی و استفاده از سیستمهای خودران، این سیستمها میتوانند غیرنظامیان و سایر افراد تحت حمایت قوانین بینالمللی را در معرض خطر بیشتری قرار دهند. دلیل این امر آن است که سیستمهای هوش مصنوعی، به ویژه هنگامی که در محیطهای پر هرج و مرج استفاده میشوند، میتوانند غیرقابل پیشبینی عمل کنند و ممکن است در شناسایی دقیق اهداف و حمله به غیرنظامیان یا شناسایی جنگجویانی که در حال جنگ نیستند، شکست بخورند.»

ویلسون جونز، تحلیلگر دفاعی گلوبال دیتا، در توضیح بیشتر این موضوع خاطرنشان کرد که موضوع چگونگی تعیین مجرمیت میتواند جای سوال داشته باشد.

آقای جونز گفت: «طبق قانون فعلی جنگ، مفهومی به نام مسئولیت فرماندهی وجود دارد. این بدان معناست که یک افسر، ژنرال یا رهبر دیگر از نظر قانونی مسئول اقدامات نیروهای تحت فرماندهی خود است. اگر نیروها مرتکب جنایات جنگی شوند، آن افسر مسئول است، حتی اگر دستور نداده باشد. بار اثبات این که آنها تمام تلاش خود را برای جلوگیری از جنایات جنگی انجام دادهاند، بر دوش آنهاست.»

آقای جونز تأکید کرد: «در سیستمهای هوش مصنوعی، این موضوع اوضاع را پیچیده میکند. آیا یک تکنسین فناوری اطلاعات مسئول است؟ یک طراح سیستم؟ مشخص نیست. اگر مشخص نباشد، اگر عاملان فکر کنند که اقداماتشان تحت حمایت قوانین موجود نیست، یک خطر اخلاقی ایجاد میشود.»

یک سرباز آمریکایی با یک سگ رباتیک گشتزنی میکند. عکس: فوربس

کنوانسیونهای کنترل تسلیحات چندین توافقنامهی بینالمللی مهم، موارد استفادهی خاصی از سلاحها را محدود و تنظیم میکنند. ممنوعیت سلاحهای شیمیایی، معاهدات منع گسترش سلاحهای هستهای و کنوانسیون برخی سلاحهای متعارف وجود دارد که استفاده از سلاحهای خاصی را که باعث ایجاد رنج غیرضروری یا غیرقابل توجیه برای متخاصمان یا تأثیر بیقید و شرط بر غیرنظامیان میشوند، ممنوع یا محدود میکند.

ویلسون جونز، تحلیلگر دفاعی، توضیح میدهد: «کنترل تسلیحات هستهای نیازمند دههها همکاری بینالمللی و معاهدات بعدی برای اجرا بود. حتی در آن زمان، ما آزمایشهای جوی را تا دهه ۱۹۹۰ ادامه دادیم. دلیل اصلی موفقیتآمیز بودن منع گسترش سلاحهای هستهای، همکاری بین ایالات متحده و اتحاد جماهیر شوروی در نظم جهانی دوقطبی بود. این همکاری دیگر وجود ندارد و فناوری که هوش مصنوعی را ایجاد میکند، برای بسیاری از کشورها نسبت به انرژی هستهای در دسترستر است.»

«یک معاهده الزامآور باید همه بازیگران مربوطه را پای میز مذاکره بیاورد تا توافق کنند از ابزاری که قدرت نظامی آنها را افزایش میدهد، استفاده نکنند. بعید است که این کار عملی شود زیرا هوش مصنوعی میتواند اثربخشی نظامی را با حداقل هزینه مالی و مادی بهبود بخشد.»

چشمانداز ژئوپلیتیکی فعلی

در حالی که کشورهای عضو سازمان ملل متحد لزوم استفاده نظامی مسئولانه از هوش مصنوعی را تصدیق کردهاند، هنوز کارهای زیادی برای انجام دادن وجود دارد.

لورا پترون، تحلیلگر ارشد گلوبال دیتا، به Army Technology گفت: «بدون یک چارچوب نظارتی مشخص، این ادعاها عمدتاً در حد آرزو باقی میمانند. جای تعجب نیست که برخی کشورها میخواهند هنگام تصمیمگیری در مورد مسائل دفاع داخلی و امنیت ملی، به ویژه در شرایط ژئوپلیتیکی فعلی، حاکمیت خود را حفظ کنند.»

خانم پترون افزود که اگرچه قانون هوش مصنوعی اتحادیه اروپا برخی الزامات را برای سیستمهای هوش مصنوعی تعیین میکند، اما به سیستمهای هوش مصنوعی برای اهداف نظامی نمیپردازد.

او اظهار داشت: «من فکر میکنم که علیرغم این استثنا، قانون هوش مصنوعی تلاشی مهم برای ایجاد چارچوبی است که مدتها به تعویق افتاده بود تا کاربردهای هوش مصنوعی را پوشش دهد، که میتواند در آینده به درجهای از یکنواختی استانداردهای مربوطه منجر شود.» «این یکنواختی برای هوش مصنوعی در حوزه نظامی نیز مهم خواهد بود.»

نگوین خان

منبع: https://www.congluan.vn/moi-nguy-robot-sat-thu-ai-dang-de-doa-an-ninh-toan-cau-post304170.html

نظر (0)