Le GPU est le cerveau de l'ordinateur IA

En termes simples, l'unité de traitement graphique (GPU) agit comme le cerveau de l'ordinateur IA.

Comme vous le savez peut-être, le processeur (CPU) est le cerveau de l'ordinateur. L'avantage d'un GPU réside dans sa spécialisation : il s'agit d'un processeur capable d'effectuer des calculs complexes. La méthode la plus rapide consiste à faire résoudre le même problème par des groupes de GPU. Cependant, l'entraînement d'un modèle d'IA peut prendre des semaines, voire des mois. Une fois construit, le modèle est placé sur un système informatique frontal et les utilisateurs peuvent lui poser des questions ; ce processus est appelé inférence.

Un ordinateur doté d'une intelligence artificielle et contenant plusieurs GPU

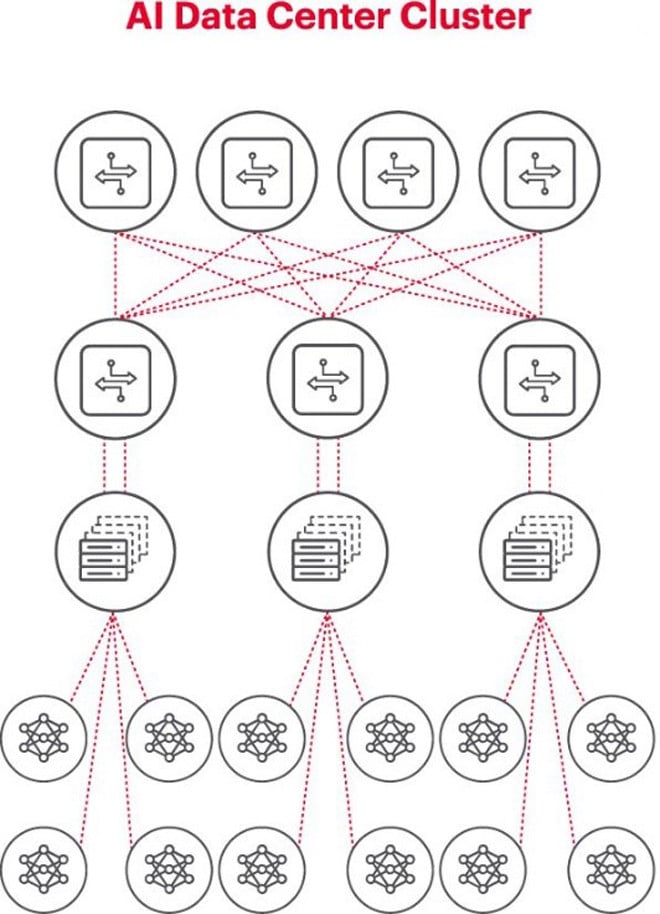

L'architecture optimale pour les problèmes d'IA consiste à utiliser un cluster de GPU dans une baie, relié à un commutateur situé en haut de cette baie. Plusieurs baies de GPU peuvent être connectées en réseau hiérarchisé. À mesure que le problème se complexifie, les besoins en GPU augmentent, et certains projets peuvent nécessiter le déploiement de clusters de plusieurs milliers de GPU.

Chaque cluster d'IA est un petit réseau

Lors de la construction d'un cluster d'IA, il est nécessaire de mettre en place un petit réseau informatique pour connecter les GPU et leur permettre de travailler ensemble et de partager efficacement les données.

La figure ci-dessus illustre un cluster d'IA où les cercles en bas représentent les flux de travail exécutés sur les GPU. Ces GPU sont connectés aux commutateurs ToR (Top-of-Rack). Ces commutateurs ToR sont eux-mêmes connectés aux commutateurs du réseau principal, visibles au-dessus du schéma, ce qui met en évidence la hiérarchie réseau nécessaire lorsqu'il y a plusieurs GPU.

Les réseaux constituent un goulot d'étranglement dans le déploiement de l'IA

L’automne dernier, lors du sommet mondial de l’Open Computer Project (OCP), où les délégués travaillaient à la construction de la prochaine génération d’infrastructures d’IA, le délégué Loi Nguyen de Marvell Technology a soulevé un point clé : « la mise en réseau est le nouveau goulot d’étranglement ».

Techniquement, une latence élevée ou une perte de paquets due à la congestion du réseau peuvent entraîner la réémission de paquets, augmentant considérablement le temps d'exécution des tâches. Par conséquent, des millions, voire des dizaines de millions de dollars, de GPU sont gaspillés par les entreprises à cause de systèmes d'IA inefficaces, ce qui leur coûte du chiffre d'affaires et allonge les délais de commercialisation.

La mesure est une condition essentielle au bon fonctionnement des réseaux d'IA

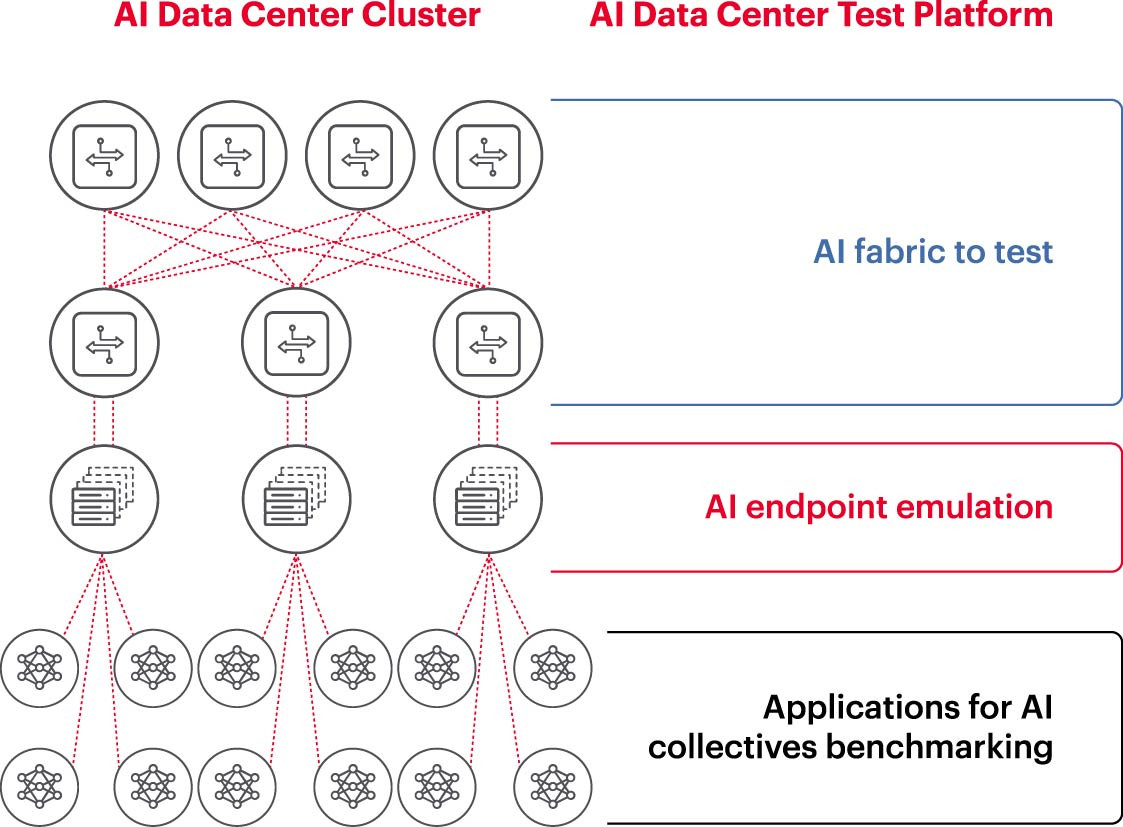

Pour qu'un cluster d'IA fonctionne efficacement, il est essentiel d'exploiter pleinement les GPU afin de réduire le temps d'entraînement et de mettre rapidement en œuvre le modèle d'apprentissage, optimisant ainsi le retour sur investissement. Il est donc nécessaire de tester et d'évaluer les performances du cluster d'IA (Figure 2). Cependant, cette tâche est complexe, car l'architecture système implique de nombreux paramètres et interactions entre les GPU et les structures de réseau, qui doivent se compléter pour résoudre le problème.

Cela engendre de nombreux défis dans la mesure des réseaux d'IA :

- Difficulté à reproduire des réseaux de production entiers en laboratoire en raison de limitations liées au coût, à l'équipement, à la pénurie d'ingénieurs en IA réseau qualifiés, à l'espace, à l'énergie et à la température.

- La mesure sur le système de production réduit la capacité de traitement disponible du système de production lui-même.

- Difficulté à reproduire fidèlement les problèmes en raison des différences d'échelle et de portée de ces derniers.

- La complexité de la manière dont les GPU sont connectés collectivement.

Pour relever ces défis, les entreprises peuvent tester un sous-ensemble des configurations recommandées en laboratoire afin d'évaluer des indicateurs clés tels que le temps d'exécution des tâches (JCT), la bande passante accessible à l'équipe IA et de la comparer à l'utilisation de la plateforme de commutation et du cache. Cette évaluation comparative permet de trouver le juste équilibre entre la charge de travail du GPU/traitement et la conception/configuration du réseau. Une fois satisfaits des résultats, les architectes informatiques et les ingénieurs réseau peuvent déployer ces configurations en production et mesurer de nouveaux résultats.

Les laboratoires de recherche d'entreprises, les établissements d'enseignement supérieur et les universités s'efforcent d'analyser chaque aspect de la conception et de l'exploitation de réseaux d'IA performants afin de relever les défis liés à la gestion de grands réseaux, d'autant plus que les bonnes pratiques continuent d'évoluer. Cette approche collaborative et reproductible est la seule façon pour les entreprises d'effectuer des mesures fiables et de tester rapidement des scénarios hypothétiques, éléments essentiels à l'optimisation des réseaux pour l'IA.

(Source : Keysight Technologies)

Source : https://vietnamnet.vn/ket-noi-mang-ai-5-dieu-can-biet-2321288.html

![[Photo] 60e anniversaire de la fondation de l'Association vietnamienne des artistes photographes](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F05%2F1764935864512_a1-bnd-0841-9740-jpg.webp&w=3840&q=75)

![[Photo] Le président de l'Assemblée nationale, Tran Thanh Man, assiste à la cérémonie de remise des prix VinFuture 2025](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F05%2F1764951162416_2628509768338816493-6995-jpg.webp&w=3840&q=75)

Comment (0)