Le tableau complexe de l'utilisation de robots tueurs dotés d'intelligence artificielle.

Confier le contrôle des systèmes d'armes à l'IA pourrait permettre d'identifier, d'attaquer et de détruire des cibles sans intervention humaine. Cela soulève de sérieuses questions juridiques et éthiques.

Soulignant la gravité de la situation, le ministre autrichien des Affaires étrangères, Alexander Schallenberg, a déclaré : « C'est le moment Oppenheimer de notre génération. »

Les robots et les armes dotés d'intelligence artificielle sont de plus en plus utilisés dans les forces armées de nombreux pays. Photo : Forbes

En effet, la question de savoir dans quelle mesure « le génie s’est échappé de son bocal » est devenue une question pressante, compte tenu de l’utilisation généralisée des drones et de l’intelligence artificielle (IA) par les forces armées du monde entier.

Wilson Jones, analyste de défense chez GlobalData, a déclaré : « L’utilisation de drones par la Russie et l’Ukraine dans les conflits modernes, l’utilisation de drones par les États-Unis dans des opérations de frappe ciblées en Afghanistan et au Pakistan, et, comme cela a été révélé le mois dernier, dans le cadre du programme israélien Lavender, démontrent comment les capacités de traitement de l’information de l’IA ont été activement utilisées par les forces armées du monde entier pour renforcer leur puissance offensive. »

Une enquête menée par l'Office of War Investigations (OFI), basé à Londres, a révélé que le système d'intelligence artificielle Lavender de l'armée israélienne affichait un taux de réussite de 90 % pour l'identification des individus liés au Hamas, ce qui signifie que 10 % d'entre eux ne l'étaient pas. Ce dysfonctionnement a entraîné des victimes civiles en raison des capacités d'identification et de prise de décision de l'IA.

Une menace pour la sécurité mondiale.

L'utilisation de l'IA de cette manière souligne la nécessité d'une gestion technologique des systèmes d'armes.

Le Dr Alexander Blanchard, chercheur principal au sein du programme de gouvernance de l'intelligence artificielle de l'Institut international de recherche sur la paix de Stockholm (SIPRI), un groupe de recherche indépendant axé sur la sécurité mondiale, a expliqué à Army Technology : « L'utilisation de l'IA dans les systèmes d'armes, en particulier lorsqu'elle est utilisée pour le ciblage, soulève des questions fondamentales sur qui nous sommes – des êtres humains – et sur notre relation à la guerre, et plus précisément, sur nos hypothèses quant à la manière dont nous pourrions utiliser la violence dans les conflits armés. »

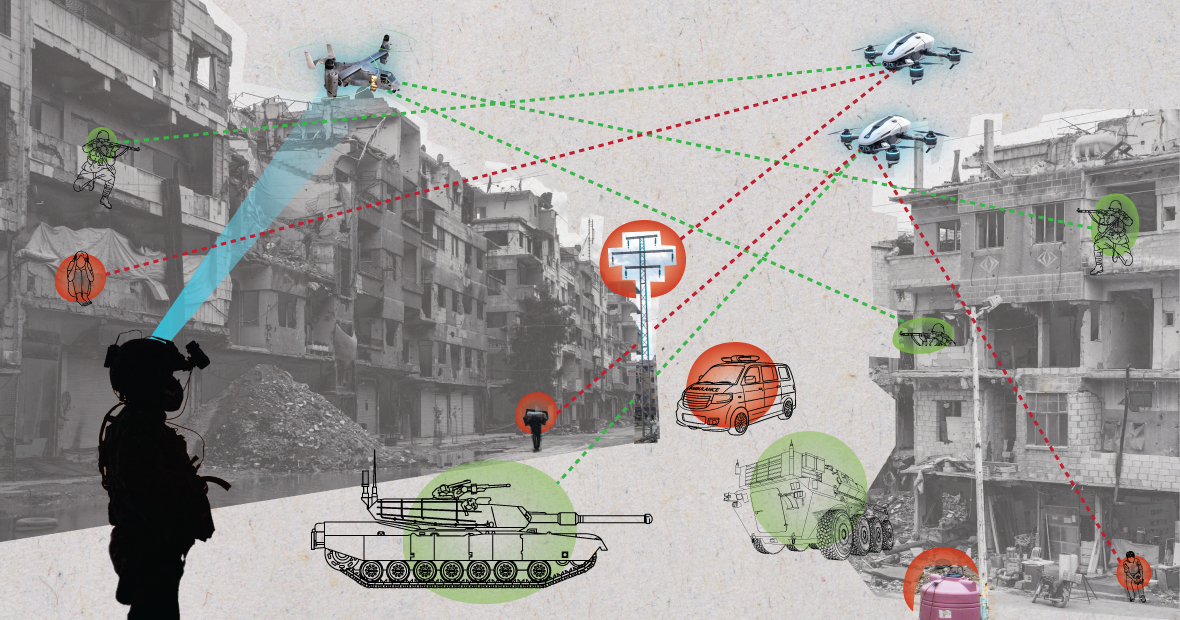

Utilisés dans des environnements chaotiques, les systèmes d'IA peuvent fonctionner de manière imprévisible et ne pas identifier précisément les cibles. (Image : MES)

« L’IA va-t-elle modifier la façon dont les forces armées choisissent leurs cibles et emploient la force ? Ces changements soulèvent, à leur tour, toute une série de questions juridiques, éthiques et opérationnelles. La principale préoccupation est d’ordre humanitaire », a ajouté le Dr Blanchard.

L’expert du SIPRI a expliqué : « Nombreux sont ceux qui craignent que, selon la conception et l’utilisation des systèmes automatisés, ces derniers puissent exposer les civils et autres personnes protégées par le droit international à un risque accru. En effet, les systèmes d’IA, surtout lorsqu’ils sont utilisés dans des environnements chaotiques, peuvent fonctionner de manière imprévisible et ne pas identifier avec précision les cibles, attaquant ainsi des civils ou ne pas repérer les combattants hors de portée des tirs. »

Pour développer ce point, Wilson Jones, analyste de la défense chez GlobalData, souligne que la définition même de la culpabilité pourrait être remise en question.

« Selon le droit de la guerre en vigueur, il existe le principe de la responsabilité du commandement », a déclaré Jones. « Cela signifie qu’un officier, un général ou tout autre chef est juridiquement responsable des actes des troupes placées sous son commandement. Si ces troupes commettent des crimes de guerre, l’officier est tenu pour responsable même s’il n’a pas donné l’ordre ; la charge de la preuve lui incombe, et il doit démontrer qu’il a tout mis en œuvre pour empêcher ces crimes. »

« Avec les systèmes d’IA, cela complique les choses. Qui est responsable ? Un technicien informatique ? Un concepteur de système ? Ce n’est pas clair. Et si ce n’est pas clair, cela crée un risque moral si les acteurs pensent que leurs actions ne sont pas protégées par les lois existantes », a souligné Jones.

Un soldat américain patrouille avec un chien robot. Photo : Forbes

Conventions sur le contrôle des armements : Plusieurs accords internationaux majeurs restreignent et réglementent certains usages des armes. Il s’agit notamment de l’interdiction des armes chimiques, des traités de non-prolifération nucléaire et de la Convention sur certaines armes classiques, qui interdisent ou limitent l’utilisation d’armes spécifiques considérées comme causant des souffrances inutiles ou injustifiables aux combattants ou affectant indistinctement les civils.

« Le contrôle des armements nucléaires exige des décennies de coopération internationale et de traités successifs pour être applicable », explique Wilson Jones, analyste de la défense. « Malgré cela, nous avons poursuivi les essais atmosphériques jusque dans les années 1990. La coopération entre les États-Unis et l’Union soviétique dans le contexte de l’ordre mondial bipolaire a largement contribué au succès de la non-prolifération nucléaire. Cette coopération n’existe plus, et l’intelligence artificielle est devenue plus accessible à un plus grand nombre de pays que l’énergie atomique. »

« Un traité contraignant devrait réunir toutes les parties concernées autour d'une table afin qu'elles s'engagent à ne pas utiliser un outil renforçant leur puissance militaire. Il est peu probable qu'une telle démarche soit efficace, car l'IA peut améliorer l'efficacité militaire à un coût financier et matériel minimal. »

Perspective géopolitique actuelle

Bien que les pays membres des Nations Unies aient reconnu la nécessité d'une utilisation responsable de l'IA par les forces armées, il reste encore beaucoup à faire.

Laura Petrone, analyste principale chez GlobalData, a déclaré à Army Technology : « Faute de cadre de gouvernance clair, ces déclarations restent largement ambitieuses. Il n’est pas surprenant que certains pays souhaitent conserver leur souveraineté en matière de défense intérieure et de sécurité nationale, surtout dans le contexte des tensions géopolitiques actuelles. »

Mme Petrone a ajouté que, si la loi européenne sur l'IA fixe certaines exigences pour les systèmes d'IA, elle ne traite pas des systèmes d'IA à des fins militaires.

« Je pense que malgré cette exclusion, la loi sur l'IA représente un effort important pour établir un cadre attendu depuis longtemps pour les applications de l'IA, ce qui pourrait conduire à une certaine harmonisation des normes pertinentes à l'avenir », a-t-elle commenté. « Cette harmonisation sera également cruciale pour l'IA dans le domaine militaire. »

Nguyen Khanh

Source : https://www.congluan.vn/moi-nguy-robot-sat-thu-ai-dang-de-doa-an-ninh-toan-cau-post304170.html

Comment (0)