En mai 2024, les géants technologiques de renommée mondiale ont lancé tour à tour de nouvelles versions d'intelligence artificielle (IA), comme OpenAI avec GPT-4o, Google avec Gemini 1.5 Pro… avec de nombreuses fonctionnalités « super intelligentes » ajoutées pour optimiser l'expérience utilisateur. Cependant, il est indéniable que cette technologie est utilisée par les cybercriminels dans de nombreux scénarios de fraude en ligne.

Risque croissant

Lors d'un récent atelier, le vice-ministre de l'Information et des Communications, Pham Duc Long, a souligné l'augmentation constante des cyberattaques, leur sophistication et leur complexité croissantes. Avec l'aide de l'IA, les risques pour les utilisateurs vont notamment s'accroître de manière exponentielle. « L'IA est utilisée par les cybercriminels pour créer facilement de nouveaux logiciels malveillants et de nouvelles attaques d'hameçonnage sophistiquées… », a averti le vice-ministre Pham Duc Long.

Selon un rapport du Département de la sécurité de l'information du ministère de l'Information et des Communications, les risques de cybersécurité liés à l'IA ont causé plus d'un quadrillion de dollars de dommages dans le monde, dont 8 000 à 10 000 milliards de dongs au Vietnam seulement. L'utilisation la plus courante aujourd'hui de l'IA est l'imitation de voix et de visages à des fins frauduleuses. On prévoit qu'en 2025, on comptera environ 3 000 attaques par seconde, 12 malwares par seconde et 70 nouvelles vulnérabilités et faiblesses par jour.

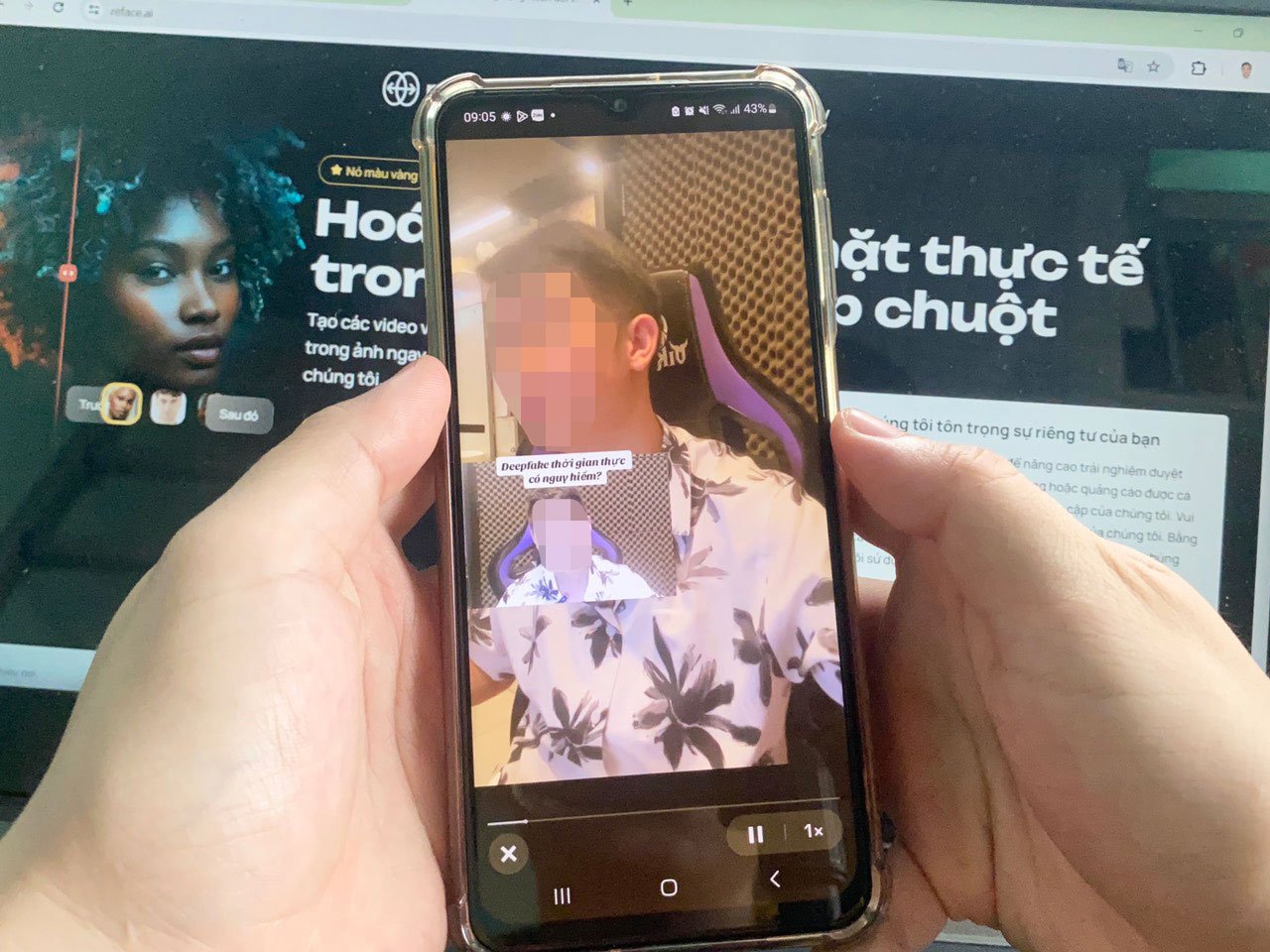

Selon M. Nguyen Huu Giap, directeur de BShield, spécialisé dans le support de sécurité des applications, créer de fausses images et voix est un jeu d'enfant grâce aux progrès de l'IA. Les fraudeurs peuvent facilement collecter les données des utilisateurs à partir d'informations publiques publiées sur les réseaux sociaux ou par des moyens frauduleux tels que des entretiens de recrutement en ligne ou des appels téléphoniques sous couvert d'« autorités ». Dans une simulation réalisée par BShield, à partir d'un visage visible par appel vidéo , les fraudeurs peuvent les insérer sur le CCCD, les greffer sur le corps d'une personne en mouvement pour tromper l'outil eKYC et être reconnus par le système comme une personne réelle.

Les méthodes frauduleuses utilisant la technologie deepfake se multiplient et deviennent de plus en plus sophistiquées. Photo : LE TINH

Du point de vue de l'utilisateur, M. Nguyen Thanh Trung, spécialiste informatique à Hô-Chi-Minh-Ville, craint que des individus malintentionnés puissent exploiter ChatGPT pour créer des e-mails frauduleux dont le contenu et le style d'écriture sont similaires à ceux de véritables e-mails de banques ou d'organisations réputées. Ces e-mails sont susceptibles d'être accompagnés de logiciels malveillants ; si l'utilisateur clique dessus, ses données seront certainement volées et ses biens confisqués. « Les logiciels d'IA sont de plus en plus perfectionnés. Ils peuvent créer de fausses vidéos avec des visages et des voix similaires à 95 % à ceux de personnes réelles. Les gestes changent en temps réel, ce qui les rend très difficiles à détecter pour les utilisateurs », a déclaré M. Trung.

Bientôt un corridor juridique complet

Pour limiter le risque de fraude high-tech, l'expert en sécurité Pham Dinh Thang a souligné que les utilisateurs doivent régulièrement mettre à jour leurs connaissances en matière d'IA et éviter de cliquer sur des liens d'origine inconnue. Les entreprises devraient allouer un budget pour garantir la sécurité des données et le bon fonctionnement des systèmes. Le personnel doit également être formé en profondeur pour identifier les vulnérabilités réelles du système, ce qui renforcera sa capacité à identifier les types de cyberattaques.

M. Ta Cong Son, responsable du département de développement de l'IA au sein du projet antifraude, a déclaré que l'IA est profondément ancrée dans la vie des utilisateurs et dans le fonctionnement des entreprises, des agences et des unités grâce à ses fonctionnalités d'assistance extrêmement intelligentes. L'IA est désormais très accessible et facile à utiliser, ce qui permettra aux acteurs malveillants de l'exploiter facilement à des fins frauduleuses. « Les fraudeurs modifient constamment leurs méthodes d'attaque ; les utilisateurs doivent mettre à jour régulièrement leurs informations pour savoir comment les prévenir », a recommandé M. Son.

Selon les experts, les modèles GPT-4o et Gemini 1.5 Pro récemment mis à niveau ont prouvé que l'intelligence de l'IA est sans limites. Par conséquent, outre l'encouragement des entreprises à développer des outils et des solutions antifraude basés sur l'IA, les agences de gestion doivent rapidement finaliser le cadre juridique de l'IA pour rester à la pointe de la tendance.

Le lieutenant-colonel Nguyen Anh Tuan, directeur adjoint du Centre national des données démographiques, a déclaré qu'il était nécessaire de publier prochainement des documents réglementant l'éthique et les responsabilités des prestataires de services nationaux et étrangers dans le processus de développement, de production, d'application et d'utilisation de l'IA. Parallèlement, des réglementations spécifiques sur les normes techniques des systèmes qui utilisent, appliquent, connectent et fournissent des services d'IA devraient être établies. « Il est nécessaire de rechercher et d'appliquer des projets d'IA pour lutter contre les risques liés à l'IA. L'IA étant créée par l'homme et issue du savoir, il existera des variantes de « bonne » et de « mauvaise » IA. Il est donc possible d'empêcher le développement de l'intelligence artificielle par l'intelligence artificielle elle-même », a souligné le lieutenant-colonel Tuan.

Les défis de la cybersécurité

Le lieutenant-colonel Nguyen Anh Tuan a reconnu que l'IA posait des défis à la sécurité des réseaux. Par conséquent, des logiciels malveillants pris en charge par l'IA peuvent s'installer dans des documents ; lorsque les utilisateurs les téléchargent, ces codes malveillants pénètrent dans le système. De plus, grâce à des technologies d'IA spécifiques, les pirates peuvent simuler le système et exploiter des failles de sécurité. L'IA peut créer de nombreuses applications utilisant des images, de faux noms d'applications et de sites web du ministère de la Sécurité publique, que les utilisateurs peuvent télécharger, installer et fournir des informations telles que leur numéro de carte d'identité et leur mot de passe. « L'IA développera également ses propres logiciels, des logiciels malveillants hybrides entre plusieurs lignes de logiciels malveillants, des mécanismes de contournement de sécurité plus sophistiqués et des codes sources flexibles modifiés automatiquement », a averti le lieutenant-colonel Nguyen Anh Tuan.

Source : https://nld.com.vn/toi-pham-mang-co-them-bi-kip-tu-ai-196240601195415035.htm

Comment (0)