ऑस्टिन स्थित टेक्सास विश्वविद्यालय, टेक्सास ए एंड एम विश्वविद्यालय और पर्ड्यू विश्वविद्यालय के एक नए अध्ययन से पता चलता है कि खराब गुणवत्ता वाली सोशल मीडिया सामग्री मिलने पर कृत्रिम बुद्धिमत्ता भी मनुष्यों की तरह "दिमाग से सड़ी हुई" हो सकती है।

यह घटना, जिसे "एआई ब्रेन रोट" के रूप में जाना जाता है, बताती है कि जब बड़े भाषा मॉडल बहुत अधिक वायरल, सनसनीखेज और उथली सामग्री को अवशोषित करते हैं, तो वे धीरे-धीरे तार्किक रूप से सोचने, याद रखने की क्षमता खो देते हैं और यहां तक कि नैतिक रूप से विचलित हो जाते हैं।

न केवल मनुष्य, बल्कि एआई भी बहुत सारे बेकार लघु वीडियो सर्फिंग करते समय मस्तिष्क के क्षरण से ग्रस्त है।

सिंगापुर के राष्ट्रीय विश्वविद्यालय में वर्तमान व्याख्याता जुनयुआन हांग के नेतृत्व में अनुसंधान दल ने दो ओपन-सोर्स भाषा मॉडलों पर प्रयोग किए: मेटा का लामा और अलीबाबा का क्वेन।

उन्होंने मॉडलों को अलग-अलग तरह के डेटा दिए—कुछ तटस्थ सूचनात्मक सामग्री, तो कुछ "वाह," "देखो," और "सिर्फ़ आज ही" जैसे आम शब्दों वाले बेहद लत लगाने वाले सोशल मीडिया पोस्ट। लक्ष्य यह देखना था कि क्या होता है जब एआई को वास्तविक मूल्य प्रदान करने के बजाय व्यूज़ आकर्षित करने के लिए डिज़ाइन की गई सामग्री पर प्रशिक्षित किया जाता है।

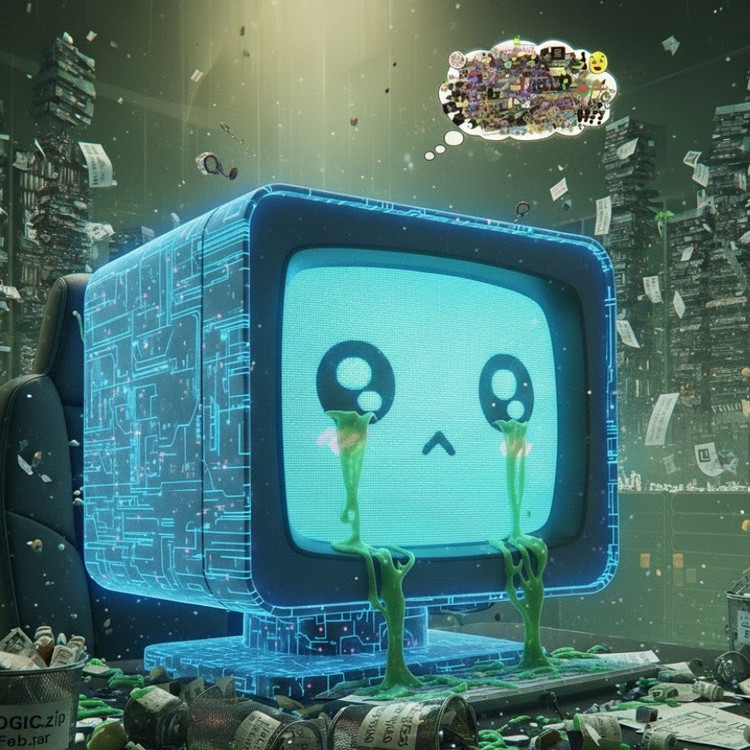

परिणामों से पता चला कि ऑनलाइन जंक सूचना की धारा से “पोषित” मॉडलों में संज्ञानात्मक गिरावट के स्पष्ट संकेत दिखने लगे: उनकी तर्क क्षमता कमजोर हो गई, उनकी अल्पकालिक स्मृति कम हो गई, और, अधिक चिंताजनक बात यह है कि वे व्यवहार मूल्यांकन पैमानों पर अधिक “अनैतिक” हो गए।

कुछ मापों से एक "मनोवैज्ञानिक विकृति" भी दिखाई देती है जो हानिकारक सामग्री के लंबे समय तक संपर्क में रहने के बाद लोगों द्वारा अनुभव की जाने वाली मनोवैज्ञानिक प्रतिक्रिया की नकल करती है, एक ऐसी घटना जो मनुष्यों पर किए गए पिछले अध्ययनों की याद दिलाती है जिसमें दिखाया गया है कि "डूमस्क्रॉलिंग" - ऑनलाइन नकारात्मक समाचारों को लगातार स्क्रॉल करना - धीरे-धीरे मस्तिष्क को नष्ट कर सकता है।

यहां तक कि ऑक्सफोर्ड डिक्शनरी ने "ब्रेन रोट" वाक्यांश को वर्ष 2024 का शब्द भी चुना है, जो डिजिटल जीवन में इस घटना की व्यापकता को दर्शाता है।

श्री हांग के अनुसार, यह खोज एआई उद्योग के लिए एक गंभीर चेतावनी है, जहां कई कंपनियां अभी भी मानती हैं कि सोशल मीडिया डेटा प्रशिक्षण संसाधनों का एक समृद्ध स्रोत है।

उन्होंने कहा, "वायरल सामग्री के साथ प्रशिक्षण डेटा को बेहतर बनाने में मदद कर सकता है, लेकिन यह चुपचाप मॉडल के तर्क, नैतिकता और ध्यान को भी नष्ट कर देता है।" इससे भी ज़्यादा चिंताजनक बात यह है कि इस तरह के घटिया डेटा से प्रभावित मॉडल "क्लीन" डेटा के साथ पुनः प्रशिक्षण के बाद भी पूरी तरह से ठीक नहीं हो पाते।

यह एक बड़ी समस्या है क्योंकि एआई अब सोशल नेटवर्क पर ज़्यादा से ज़्यादा सामग्री तैयार कर रहा है। जैसे-जैसे एआई-जनित पोस्ट, चित्र और टिप्पणियाँ व्यापक होती जा रही हैं, वे अगली पीढ़ी के एआई के लिए प्रशिक्षण सामग्री बनती जा रही हैं, जिससे एक दुष्चक्र बन रहा है जिससे डेटा की गुणवत्ता में गिरावट आ रही है।

"जैसे-जैसे एआई-जनित जंक कंटेंट फैलता है, यह उसी डेटा को प्रदूषित करता है जिससे भविष्य के मॉडल सीखेंगे," होंग ने चेतावनी दी। "एक बार जब यह 'ब्रेन रोट' शुरू हो जाता है, तो साफ़ डेटा के साथ पुनः प्रशिक्षण इसे पूरी तरह से ठीक नहीं कर सकता।"

अध्ययन ने एआई डेवलपर्स के लिए एक चेतावनी दी है: जबकि दुनिया डेटा के पैमाने का विस्तार करने के लिए दौड़ रही है, इससे भी अधिक चिंताजनक बात यह है कि हम "कृत्रिम मस्तिष्क" का पोषण कर रहे हैं जो धीरे-धीरे सड़ रहा है - जानकारी की कमी के कारण नहीं, बल्कि अर्थहीन चीजों की अधिकता के कारण।

स्रोत: https://khoahocdoisong.vn/den-ai-cung-bi-ung-nao-neu-luot-tiktok-qua-nhieu-post2149064017.html

![[फोटो] राष्ट्रपति लुओंग कुओंग ने अमेरिकी युद्ध सचिव पीट हेगसेथ का स्वागत किया](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/02/1762089839868_ndo_br_1-jpg.webp)

![[फोटो] लाम डोंग: तुय फोंग में एक संदिग्ध झील के फटने के बाद हुए नुकसान की तस्वीरें](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/02/1762078736805_8e7f5424f473782d2162-5118-jpg.webp)

टिप्पणी (0)