A DeepSeek kutatói bejelentettek egy új kísérleti modellt, a V3.2-exp-et, amelynek célja, hogy jelentősen csökkentse a következtetés költségeit hosszú kontextusú műveletek során.

A DeepSeek a Hugging Face-en közzétett bejegyzésében jelentette be a modellt, és egy kapcsolódó tudományos cikket is közzétett a GitHubon.

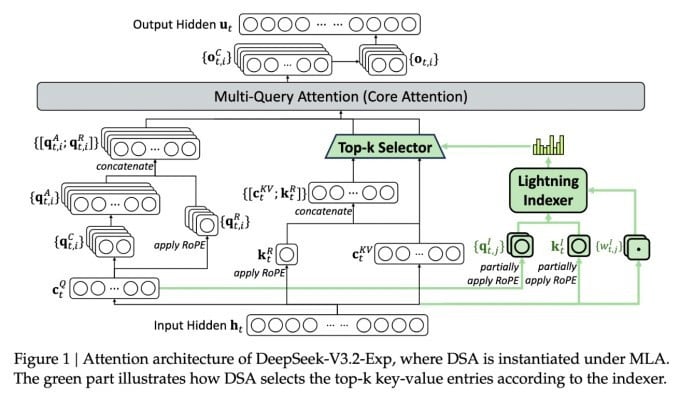

Az új, összetett modell legfontosabb funkciója a DeepSeek Sparse Attention. Lényegében a rendszer egy „villámindexelő” nevű modult használ a kontextusablakból származó adott részletek rangsorolására.

A DeepSeek költséghatékony következtetési modellt jelentett be.

Egy különálló rendszer, az úgynevezett „finomszemcsés tokenkiválasztó rendszer” ezután kiválasztja a kódrészletekből a tokeneket, hogy betöltsék azokat a modul korlátozott figyelmi ablakába. Együttesen lehetővé teszik a Sparse Attention modellek számára, hogy hosszú kontextusdarabokon működjenek viszonylag kis szerverterhelés mellett.

Hosszú kontextusú műveletek esetén a rendszer előnyei jelentősek. A DeepSeek előzetes tesztelése azt mutatja, hogy egy egyszerű következtetési függvény (API) hívás költsége akár a felére is csökkenthető hosszú kontextusú forgatókönyvekben.

További tesztelésre van szükség egy robusztusabb értékeléshez, de mivel a modell nyílt és ingyenesen elérhető a Hugging Face-en, nem kell sokáig várni, hogy harmadik féltől származó tesztek is értékelhessék a cikkben szereplő állításokat.

Más, sok energiát fogyasztó mesterséges intelligencia alapú chatbot modellekkel ellentétben a DeepSeek a költségek megtakarítását célozza meg a képzéstől az üzemeltetésig.

A DeepSeek új modellje egyike azon áttöréseknek, amelyek a következtetési költségek problémáját kezelik – lényegében egy előre betanított MI-modell futtatásának szerverköltségét, szemben a betanítás költségével.

A DeepSeek esetében a kutatók a transzformátor alapvető architektúrájának hatékonyabbá tételére keresték a módját – és azt találták, hogy jelentős fejlesztésekre van szükség.

A kínai székhelyű DeepSeek szokatlan figura a mesterséges intelligencia őrületében, különösen azok számára, akik a mesterséges intelligencia kutatását az Egyesült Államok és Kína közötti versenynek tekintik. A cég idén korábban nagy port kavart az R1 modelljével, amelyet elsősorban megerősítéses tanulással képeztek ki, sokkal alacsonyabb költségek mellett, mint amerikai versenytársai.

A modell azonban nem indította el azt a teljes körű forradalmat az AI-képzésben, amit egyesek jósoltak, és a vállalat a következő hónapokban lassan visszahúzódott a reflektorfényből.

Az új „ritka figyelem” megközelítés valószínűleg nem fog akkora felháborodást kiváltani, mint az R1 – de mégis megtaníthatja az amerikai szolgáltatókat néhány nagyon szükséges trükkre, amelyek segítenek alacsonyan tartani a következtetési költségeket.

https://techcrunch.com/2025/09/29/deepseek-releases-sparse-attention-model-that-cuts-api-costs-in-half/

Forrás: https://khoahocdoisong.vn/deepseek-dao-tao-da-re-nay-con-co-ban-suy-luan-re-hon-post2149057353.html

![[Fotó] A Binh Minh Általános Iskola diákjai élvezik a telihold fesztivált, átélve a gyermekkor örömeit.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/8cf8abef22fe4471be400a818912cb85)

![[Fotó] Pham Minh Chinh miniszterelnök elnököl a 10-es vihar következményeinek elhárítására irányuló megbeszélésen](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/544f420dcc844463898fcbef46247d16)

Hozzászólás (0)