Az Austini Texasi Egyetem, a Texasi A&M Egyetem és a Purdue Egyetem új tanulmánya szerint a mesterséges intelligencia az emberekhez hasonlóan „agyrohadni” kezdhet, ha gyenge minőségű közösségi médiatartalommal látják el.

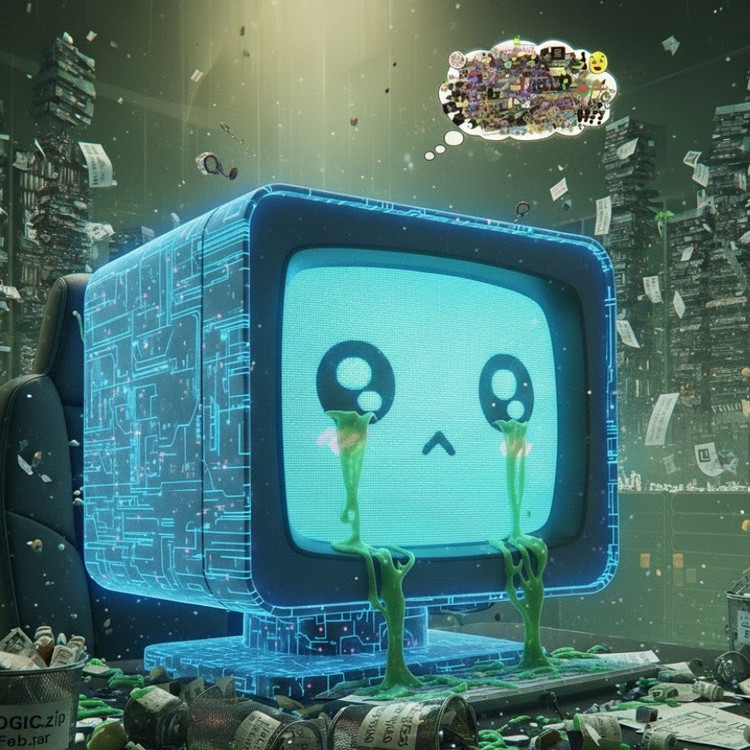

Ez a jelenség, amelyet „mesterséges intelligencia által okozott agyrothadásnak” neveznek, arra utal, hogy amikor a nagy nyelvi modellek túl sok virális, szenzációs és sekélyes tartalmat szívnak fel, fokozatosan elveszítik a logikus gondolkodás, az emlékezés képességét, sőt erkölcsileg deviánssá válnak.

Nemcsak az emberek, a mesterséges intelligencia is szenved agydegenerációtól, amikor túl sok haszontalan rövid videót nézegetnek.

A Junyuan Hong, a Szingapúri Nemzeti Egyetem jelenlegi előadója által vezetett kutatócsoport két nyílt forráskódú nyelvi modellen végzett kísérleteket: a Meta Llama és az Alibaba Qwen nyelvén.

Különböző típusú adatokat adtak a modelleknek – némelyik semleges információs tartalmú, mások pedig rendkívül addiktív közösségi média bejegyzéseket olyan gyakori szavakkal, mint a „wow”, a „look” és a „csak ma”. A cél az volt, hogy lássák, mi történik, ha a mesterséges intelligenciát olyan tartalmakra képezik ki, amelyek a megtekintések vonzására szolgálnak, nem pedig valódi értéket teremtenek.

Az eredmények azt mutatták, hogy az online szemétinformációk özönével „etetett” modellek a kognitív hanyatlás egyértelmű jeleit kezdték mutatni: érvelési képességük gyengült, rövid távú memóriájuk romlott, és ami még aggasztóbb, a viselkedési értékelési skálákon „etikusabbak” lettek.

Egyes mérések egy „pszichológiai torzulást” is mutatnak, amely utánozza azt a pszichológiai reakciót, amelyet az emberek a káros tartalmaknak való hosszan tartó kitettség után tapasztalnak. Ez a jelenség a korábbi, embereken végzett tanulmányokra emlékeztet, amelyek azt mutatták, hogy a „doomscrolling” – a negatív hírek folyamatos online görgetése – fokozatosan erodálhatja az agyat.

Az „agyrothadás” kifejezést az Oxford Dictionaries a 2024-es év szavának választotta, tükrözve a jelenség elterjedtségét a digitális életben.

Ez a megállapítás komoly figyelmeztetés a mesterséges intelligencia iparág számára, ahol sok vállalat még mindig úgy véli, hogy a közösségi média adatai gazdag képzési erőforrásokat jelentenek Hong úr szerint.

„A vírusos tartalommal való betanítás segíthet az adatok skálázásában, de csendben aláássa a modell érvelését, etikáját és figyelmét” – mondta. Ami még aggasztóbb, hogy az ilyen típusú rossz minőségű adatok által érintett modellek még a „tisztább” adatokkal való újratanítás után sem tudnak teljesen felépülni.

Ez nagy problémát jelent, tekintve, hogy maga a mesterséges intelligencia egyre több tartalmat állít elő a közösségi hálózatokon. Ahogy a mesterséges intelligencia által generált bejegyzések, képek és hozzászólások egyre elterjedtebbek, ezek továbbra is a következő generációs mesterséges intelligencia képzési anyagává válnak, ami egy ördögi kört hoz létre, ami az adatok minőségének romlásához vezet.

„Ahogy a mesterséges intelligencia által generált szeméttartalom terjed, az szennyezi azokat az adatokat, amelyekből a jövő modelljei tanulni fognak” – figyelmeztetett Hong. „Ha ez az „agyrothadás” egyszer bekövetkezik, a tiszta adatokkal való újraképzés nem tudja teljesen meggyógyítani.”

A tanulmány intő jelként szolgált a mesterséges intelligencia fejlesztői számára: miközben a világ siet az adatok mennyiségének növelésével, aggasztóbb, hogy olyan „mesterséges agyakat” nevelhetünk, amelyek lassan rothadnak – nem az információhiány, hanem a jelentéktelen dolgok túlkínálata miatt.

Forrás: https://khoahocdoisong.vn/den-ai-cung-bi-ung-nao-neu-luot-tiktok-qua-nhieu-post2149064017.html

![[Fotó] Pham Minh Chinh miniszterelnök elnököl a magángazdaság-fejlesztési irányítóbizottság második ülésén.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/01/1762006716873_dsc-9145-jpg.webp)

Hozzászólás (0)