Googleは3月12日、スマートフォンと高性能ワークステーションの両方で実行できる第3世代のオープンソースAIモデル、Gemma 3を発表した。

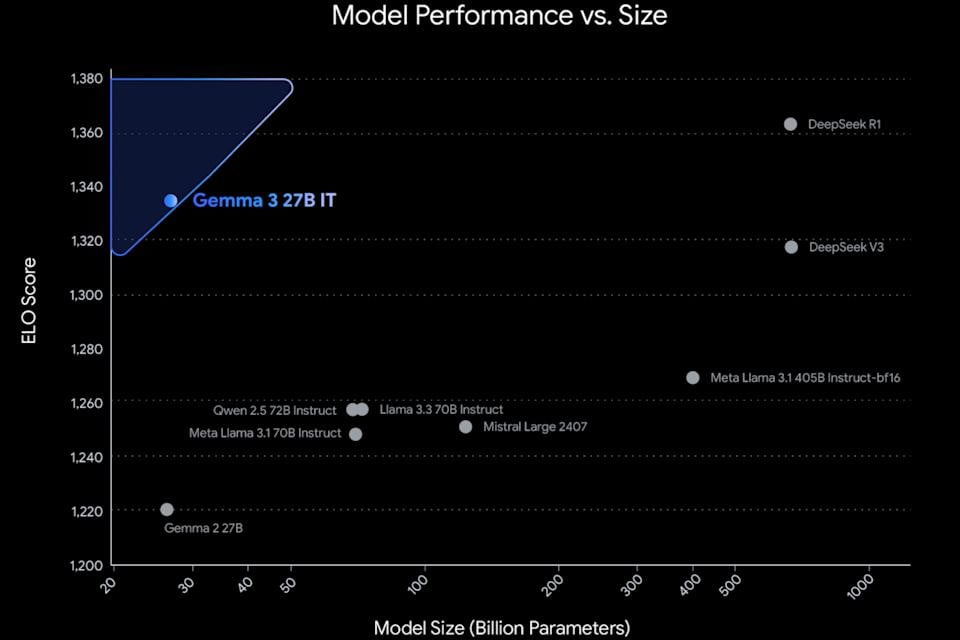

Gemma 3は、10億、40億、120億、270億のパラメータを持つ4つのバージョンで提供されています。Googleによると、これは世界最高のシングルスピードモデルであり、大規模なコンピュータクラスターを必要とせず、単一のGPUまたはTPUで実行できます。

理論的には、これにより、Gemini Nano モデルがモバイル デバイス上でローカルに実行されるのと同様に、Gemma 3 を Pixel スマートフォンの Tensor Processing Unit (TPU) 上で直接実行できるようになります。

Gemini AIモデルファミリーと比較したGemma 3の最大の利点はオープンソースであることで、開発者はモバイルアプリやデスクトップソフトウェアにオンデマンドで簡単にカスタマイズ、パッケージ化、デプロイできます。さらに、Gemmaは140以上の言語をサポートしており、そのうち35言語は既にトレーニングパッケージとして利用可能です。

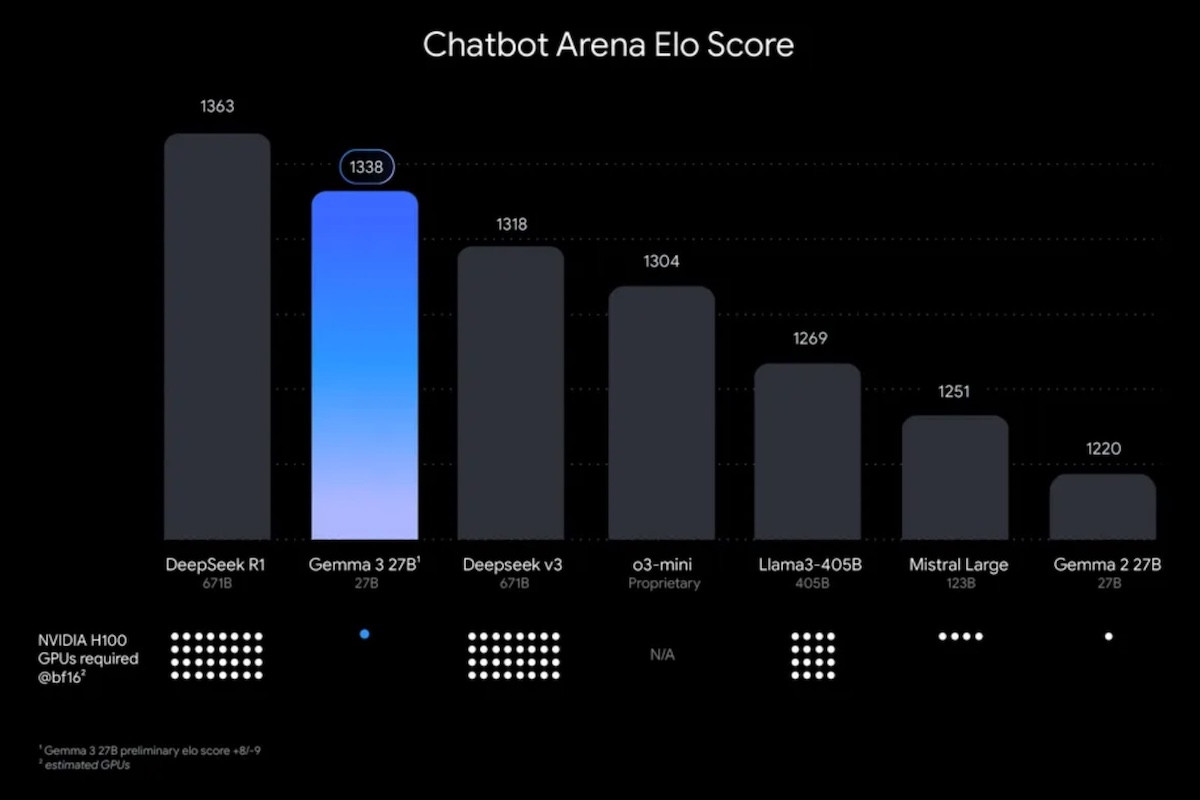

最新のGemini 2.0モデルと同様に、Gemma 3はテキスト、画像、動画を処理できます。パフォーマンスの面では、Gemma 3はDeepSeek V3、OpenAI o3-mini、MetaのLlama-405Bバリアントなど、他の多くの一般的なオープンソースAIモデルよりも高い評価を得ています。

200ページの本に相当する内容

Gemma 3は最大128,000トークンのコンテキストウィンドウをサポートしており、これは200ページの書籍のデータ量に相当します。比較すると、Gemini 2.0 Flash Liteモデルのコンテキストウィンドウは最大100万トークンです。

Gemma 3 は、Gemini が Gmail や Docs などのプラットフォーム間での作業をシームレスにサポートするのと同様に、外部データセットと対話して自動エージェントとして機能します。

Googleの最新のオープンソースAIモデルは、ローカルまたはVertex AIなどのGoogleのクラウドサービスを通じてデプロイできます。Gemma 3は現在、Google AI Studioに加え、Hugging Face、Ollama、Kaggleなどのサードパーティプラットフォームでも利用可能です。

Googleの第3世代オープンソースモデルは、企業が大規模言語モデル(LLM)と小規模言語モデル(SLM)を並行して開発するという業界のトレンドの一環をなしています。GoogleのライバルであるMicrosoftも、オープンソースの小規模言語モデルであるPhiシリーズで同様の戦略を追求しています。

GemmaやPhiのような小規模な言語モデルは、リソース効率の高さで高く評価されており、スマートフォンなどのデバイスでの実行に最適です。さらに、レイテンシが低いため、特にモバイルアプリケーションに適しています。

[広告2]

出典: https://vietnamnet.vn/google-ra-mat-gemma-3-mo-hinh-ai-ma-nguon-mo-voi-hieu-suat-vuot-troi-2380097.html

コメント (0)