エヌビディアは3月18日の開発者向けイベントで、人工知能(AI)市場における地位を確固たるものにするため、多数の新製品を発表しました。2022年後半にChatGPTが世界的なAI競争の火蓋を切って落として以来、同社の株価は54倍、売上高は3倍以上に上昇しました。エヌビディアのハイエンドサーバーGPUは、大規模言語モデルの学習と展開に不可欠であり、マイクロソフトやMetaなどの企業がこのチップに数十億ドルを費やしています。

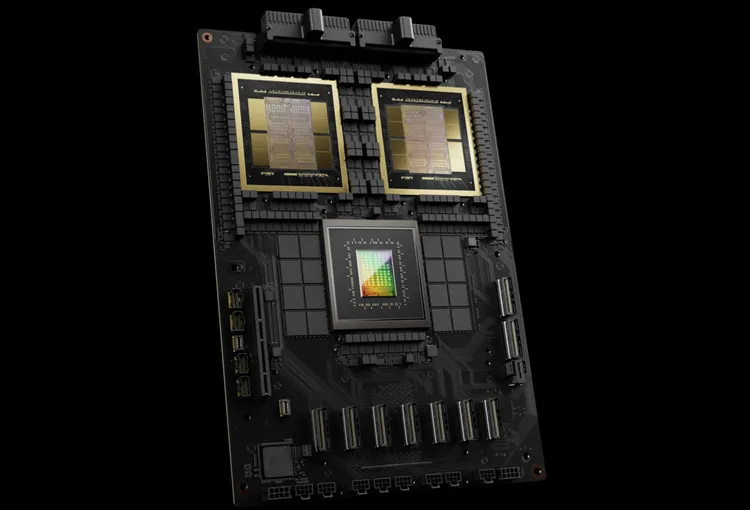

Nvidiaは次世代AIチップをBlackwellと名付けました。最初のBlackwellチップであるGB200は今年後半に発売予定です。Nvidiaは新規受注を促進するため、より高性能なチップを顧客に提供しています。顧客はH100 Hopperチップの入手に依然として奔走しています。

「Hopper は素晴らしいが、もっと大きな GPU が必要だ」とNvidia の CEO である Jensen Huang 氏はイベントで語った。

NvidiaはBlackwellチップに加え、AIの導入を容易にするNIMソフトウェアも発表しました。Nvidiaの関係者は、同社はチップサプライヤーというより、AppleやMicrosoftのようなプラットフォームプロバイダーへと成長しつつあると述べています。

「Blackwellはチップではなく、プラットフォームの名前です」とフアン氏は述べた。NVIDIAの副社長マヌビル・ダス氏は、NIMソフトウェアによって開発者が新旧を問わずあらゆるNVIDIA GPUでプログラムを実行できるようになり、より多くの人々にリーチできるようになると約束した。

ホッパーの後継者、ブラックウェル

Nvidiaは2年ごとにGPUアーキテクチャをアップデートし、新たなパフォーマンス向上を実現しています。昨年リリースされた多くのAIモデルは、2022年から利用可能になるHopperアーキテクチャでトレーニングされています。

Nvidiaによると、GB200のようなBlackwellベースのチップは、AIビジネスに大幅なパフォーマンス向上をもたらし、H100の4ペタフロップスに対して20ペタフロップスを実現しています。この処理能力により、AIビジネスはより大規模で複雑なモデルのトレーニングが可能になります。

Blackwell GPUは大型で、別々に製造された2つのダイを1つのチップに統合しています。また、72個のBlackwell GPUとAIモデルのトレーニング用に設計されたその他のNvidiaパーツを組み合わせたGB200 NVLink 2と呼ばれる完全なサーバーとしても提供されています。

Amazon、Google、Microsoft、Oracleは、クラウドサービスを通じてGB200へのアクセスを販売します。GB200は、2つのB200 Blackwell GPUとGrace CPUを組み合わせています。NVIDIAは、Amazon Web Services(AWS)が2万個のGB200チップでサーバークラスターを構築すると発表しました。

このシステムは27兆パラメータのモデルを実行できます。これは、GPT-4(1兆7000億パラメータ)などの現在利用可能な最大モデルをはるかに上回ります。多くのAI研究者は、より多くのパラメータとデータを持つ大規模モデルによって、新たな能力が発揮されると考えています。

Nvidiaは、新しいGB200やGB200を搭載したシステムの価格をまだ発表していません。アナリストの推計によると、NvidiaのHopperベースのH100は1台あたり2万5000ドルから4万ドル、システム全体では最大20万ドルかかるとされています。

(CNBCによると)

[広告2]

ソース

![[ビデオ] ペトロベトナム – 50年間、伝統の灯火を守り、国家エネルギーを構築](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/9/3/3f5df73a4d394f2484f016fda7725e10)

![[写真] ルオン・クオン国家主席がロシアのプーチン大統領と会談](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/9/3/87982dff3a724aa880eeca77d17eff7f)

コメント (0)