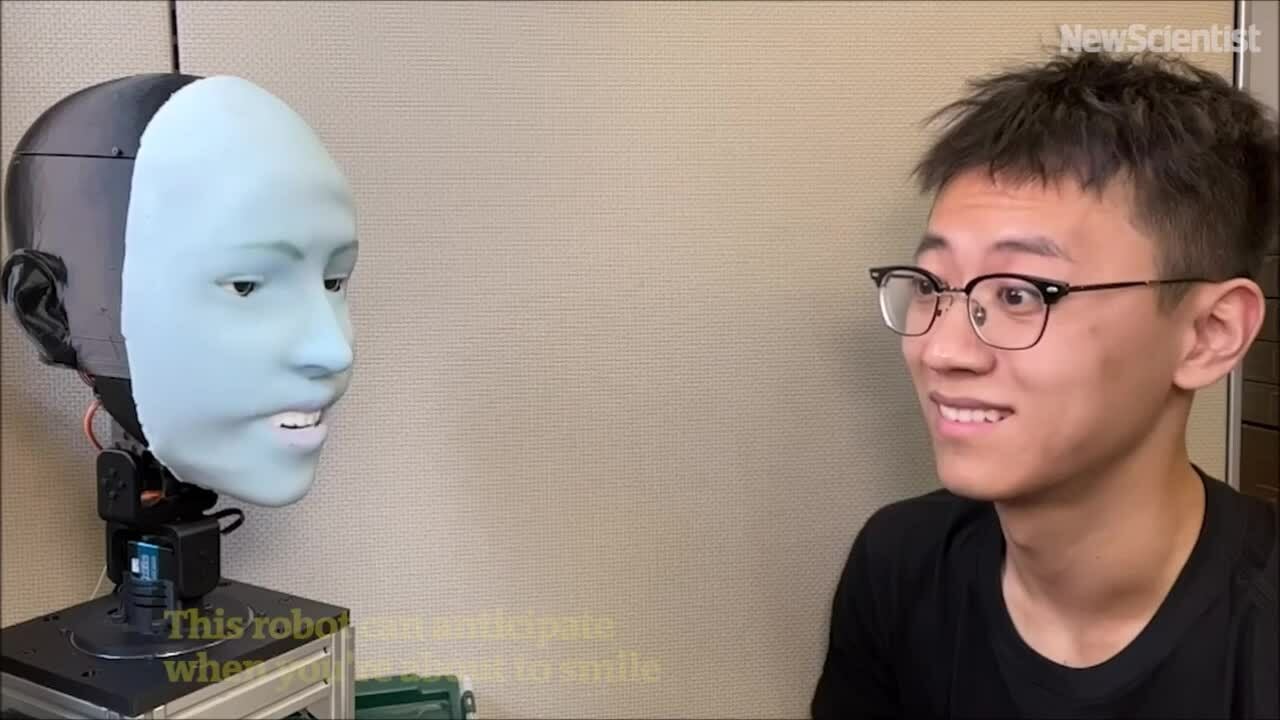

アメリカのロボット「エモ」は、向かい側の人が笑う約 840 ミリ秒前に笑顔を予測し、同時に笑顔を見せる。

エモロボットは、相手の表情を予測し、同時に笑顔を見せる。動画:ニューサイエンティスト

ChatGPTのような大規模言語モデルの進歩もあって、人間は音声で流暢にコミュニケーションできるロボットに慣れつつありますが、非言語コミュニケーション能力、特に表情認識能力は依然として大きく遅れています。多様な表情を表現できるだけでなく、適切なタイミングでそれらをどのように表現するかを知るロボットを設計することは非常に困難です。

コロンビア大学工学部のクリエイティブマシンズ・ラボは、5年以上にわたりこの問題に取り組んできました。TechXploreが3月27日に報じたところによると、同チームはサイエンス・ロボティクス誌に掲載された新たな研究で、人間の表情を予測し、リアルタイムでその表情を再現できるAIロボット「Emo」を発表しました。Emoは、人が笑う約840ミリ秒前に笑顔を予測し、実際に笑顔を浮かべます。

Emoは、26個のアクチュエータを搭載した顔を持つヒューマノイドロボットです。ロボットの頭部は磁気接続システムを備えた柔らかいシリコンスキンで覆われており、素早い調整とメンテナンスが可能です。より没入感のあるインタラクションを実現するために、チームは両目の瞳孔に高解像度カメラを組み込み、Emoが非言語コミュニケーションにおいて重要な、目を使ったインタラクションを実現しました。

研究チームは2つのAIモデルを開発しました。1つ目のモデルは、反対側の顔の微妙な変化を分析することで人間の表情を予測し、2つ目のモデルは対応する表情を用いて運動指令を生成しました。

ロボットに感情表現を訓練するため、研究チームはエモをカメラの前に置き、ランダムな動きをさせた。数時間後、ロボットは表情と運動指令の関係を学習した。これは人間が鏡を見て表情を練習するのと似ている。研究チームはこれを「自己モデリング」と呼んでおり、人間が特定の表情をしている自分を想像するのと似ている。

次に、研究チームは人間の表情を捉えたビデオをエモに再生し、フレームごとに観察させました。数時間のトレーニングを経て、エモは人が笑い始めたときの微妙な表情の変化を観察し、表情を予測できるようになりました。

「人間の表情を正確に予測することは、人間とロボットのインタラクション分野における革命だと思います。これまで、ロボットはインタラクション中に人間の表情を考慮するように設計されていませんでした。しかし、今ではロボットは表情を統合して反応することができます」と、クリエイティブマシンラボの博士課程学生で研究チームのメンバーであるユーハン・フー氏は述べた。

「ロボットが人間と同時にリアルタイムで表情を変えることは、インタラクションの質を向上させるだけでなく、人間とロボットの間の信頼関係の構築にも役立ちます。将来的には、ロボットとインタラクションする際に、まるで本物の人間のように表情を観察し、解釈してくれるようになるでしょう」と胡氏は付け加えた。

トゥ・タオ( TechXploreによる)

[広告2]

ソースリンク

コメント (0)