특히 구글의 모회사인 알파벳은 직원들에게 AI 챗봇에 기밀 문서를 입력하지 말라고 권고했습니다. 로이터가 입수한 알파벳 내부 소식통에 따르면, 알파벳은 엔지니어들에게 챗봇이 생성하는 컴퓨터 코드를 직접 사용하지 말라고 경고했습니다.

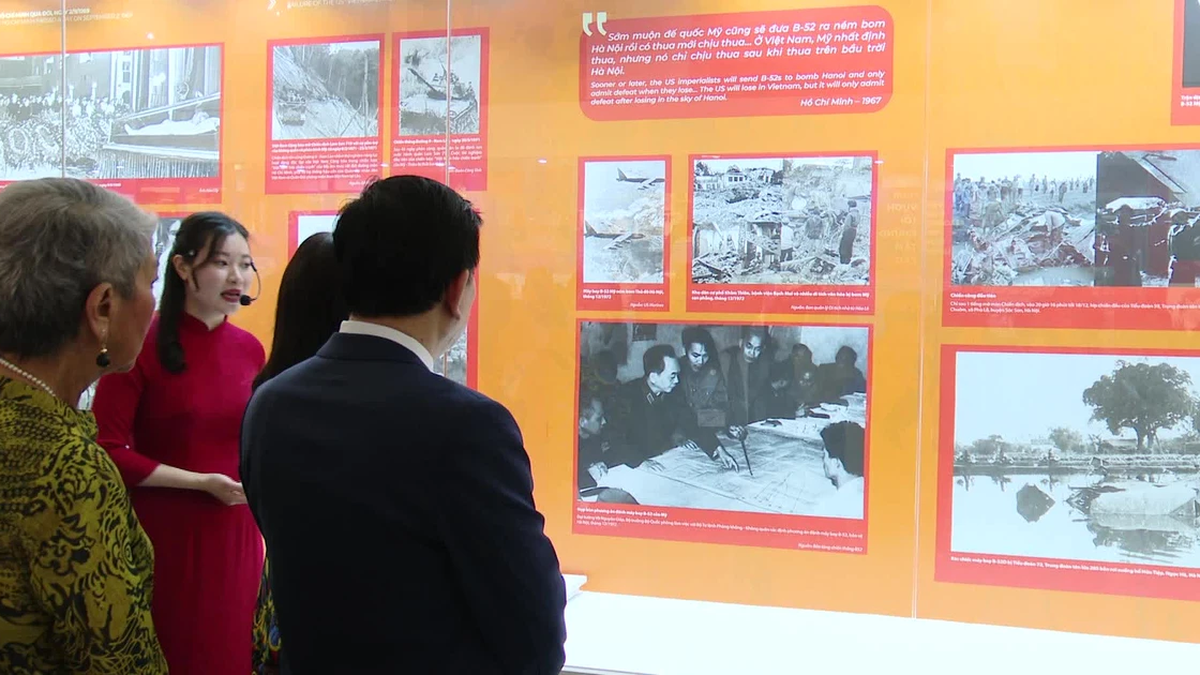

거대 기술 기업 구글 역시 자사 AI 챗봇을 통한 정보 유출을 우려하고 있다. 사진: 로이터

Bard와 ChatGPT를 포함한 챗봇은 소위 일반 인공지능을 사용하여 사용자와 인간처럼 대화하는 프로그램입니다. 전문가들은 챗봇이 응답하면서 수집한 데이터를 복제할 수 있기 때문에 사용자 정보 유출 위험이 있다고 지적합니다.

이러한 우려는 구글이 ChatGPT와의 경쟁을 위해 출시하는 소프트웨어로 인한 사업적 피해를 피하려는 의도를 보여줍니다. 구글의 이러한 신중한 태도는 기업들이 챗봇 관련 정보 공개에 대해 경고하는 등 전 세계적으로 확산되고 있는 우려의 흐름을 반영하고 있습니다.

삼성, 아마존, 도이체은행 등 전 세계적으로 점점 더 많은 기업이 AI 챗봇에 대한 안전장치를 마련하고 있습니다.

미국 웹사이트 Fishbowl이 약 12,000명을 대상으로 실시한 설문 조사에 따르면, 1월 현재 기술 전문가의 약 43%가 상사에게 알리지 않고도 ChatGPT나 다른 AI 도구를 사용하고 있는 것으로 나타났습니다.

인사이더(Insider) 보도에 따르면, 2월까지 구글은 바드(Bard) 챗봇 직원들에게 내부 정보를 공유하지 말라고 지시했습니다. 구글은 현재 바드를 180개국 이상에 40개 언어로 출시하고 있습니다.

구글의 AI 기술은 이메일, 문서, 심지어 소프트웨어까지 자동으로 작성하는 도구에 적용되고 있습니다. 그러나 이러한 작업에는 허위 정보가 포함될 수 있으며 정보 유출 위험도 있습니다.

부이 후이 (Reuters, Insider에 따르면)

[광고_2]

원천

댓글 (0)