|

DeepSeek의 AI 학습 기술을 개선하여 Huawei Ascend 칩은 탁월한 성능을 구현했습니다. 사진: Reuters |

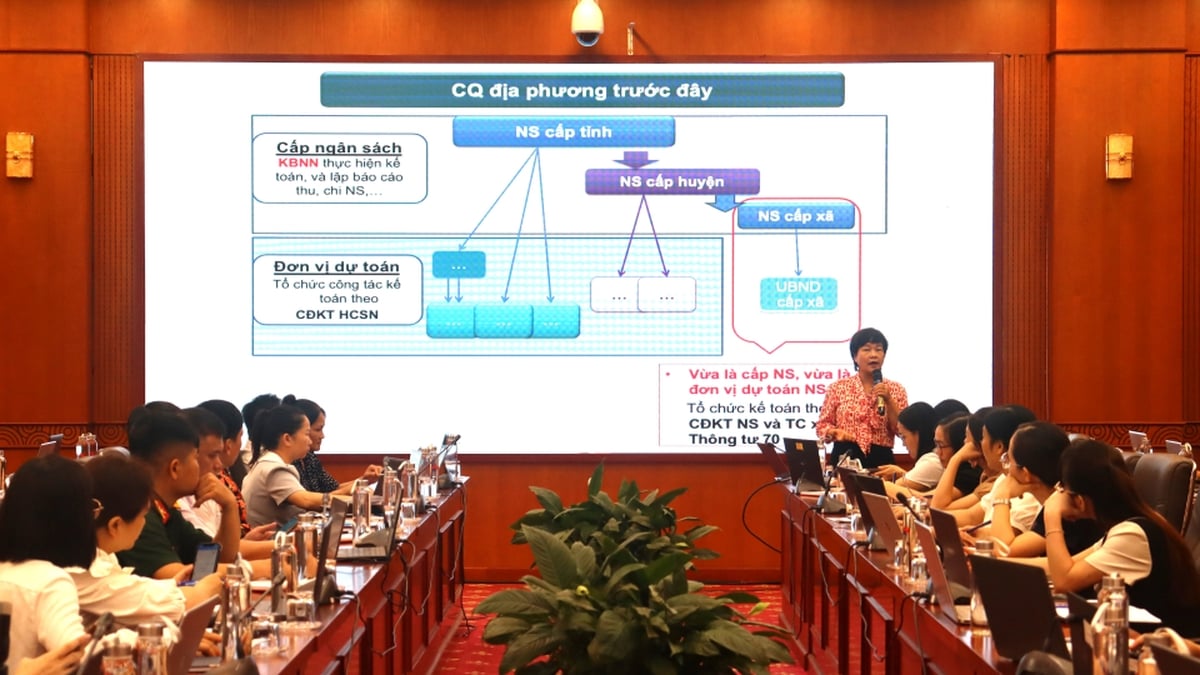

SCMP 에 따르면, 화웨이의 Pangu 대규모 언어 모델(LLM)을 연구하는 연구원들은 6월 4일, 이 회사의 독점 하드웨어를 활용해 DeepSeek의 원래 인공지능(AI) 훈련 방식을 개선했다고 발표했습니다.

구체적으로, 핵심 협력자 22명과 추가 연구자 56명으로 구성된 Huawei의 Pangu 팀이 발표한 논문에서는 DeepSeek의 비용 효율적인 AI 모델에서 핵심적인 역할을 하는 Mixture of Experts(MoE) 기술의 업그레이드 버전인 Mixture of Grouped Experts(MoGE) 개념을 소개했습니다.

논문에 따르면 MoE는 대규모 모델 매개변수와 고급 학습 기능에 대해 낮은 실행 비용을 제공하지만, 종종 비효율성을 초래합니다. 이는 불균등한 활성화로 인해 여러 기기에서 병렬로 실행할 때 성능이 저하되기 때문입니다.

연구자들에 따르면, MoGE는 선발 과정에서 전문가 팀을 통해 개선되었으며 "전문가"의 업무량을 더 잘 분산시켰습니다.

AI 학습에서 "전문가"라는 용어는 더 큰 모델 내의 특수한 하위 모델 또는 구성 요소를 지칭합니다. 이러한 각 모델은 특정 작업이나 고유한 유형의 데이터를 처리하도록 설계됩니다. 이를 통해 전체 시스템은 다양한 전문 지식을 활용하여 성능을 향상시킬 수 있습니다.

화웨이에 따르면, 학습 과정은 사전 학습, 롱 컨텍스트 확장, 사후 학습의 세 가지 주요 단계로 구성됩니다. 전체 과정에는 13조 2천억 개의 토큰을 활용한 사전 학습과 8,192개의 어센드(Ascend) 칩을 활용한 롱 컨텍스트 확장이 포함됩니다. 어센드는 화웨이의 가장 강력한 AI 프로세서로, AI 모델 학습에 사용되며 엔비디아의 하이엔드 칩 설계 지배력에 도전하는 것을 목표로 합니다.

연구진은 AI 작업을 가속화하도록 특별히 설계된 Ascend 신경 처리 장치(NPU)에서 새로운 아키텍처를 테스트한 결과, MoGE가 "모델 학습과 추론 모두에서 전문가 부하 분산과 성능 효율성을 향상시킨다"는 것을 발견했습니다.

그 결과, DeepSeek-V3, Alibaba의 Qwen2.5-72B, Meta Platforms의 Llama-405B와 같은 모델과 비교했을 때 Pangu는 대부분의 일반 영어 벤치마크와 모든 중국어 벤치마크보다 우수한 성능을 보이며, 장기 컨텍스트 학습에서 탁월한 성능을 보였습니다.

출처: https://znews.vn/huawei-tuyen-bo-huan-luyen-ai-tot-hon-deepseek-post1558359.html

![[사진] 팜 민 찐 총리가 '하노이 - 1945년 역사적인 가을'이라는 주제로 특별 예술 프로그램에 참석했다.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/15/c1c42655275c40d1be461fee0fd132f3)

![[사진] 쩐 탄 만 국회의장이 톤 득 탕 대통령 기념관 개관식에 참석](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/16/23555950872d428a8708a1e2f94cbf59)

![[사진] 전국 각지에서 '나는 조국을 사랑한다'는 성스러운 국기게양식이 동시에 진행됐다.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/16/bc88d86d5270494c98dc9a6e722206e9)

![[사진] 팜민친 총리, 훈 마넷 캄보디아 총리와 전화 통화](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/15/72d3838db8154bafabdadc0a5165677f)

![[사진] 베트남에서 가장 로맨틱한 길, "베트남과 함께 나아가다"](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/16/0ee500bc59fd4468863261ee26f47fe7)

![[사진] 공안부 본부 출범식 참석한 사무총장](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/16/3ceec3a24ef945c18ae2b523563b749d)

![[사진] "베트남과 함께 나아가다" 프로그램 출범식에 참석한 붉은색과 노란색 별들](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/16/076df6ed0eb345cfa3d1cd1d7591a66f)

댓글 (0)