이 기술 대기업은 자사 앱이 중독성이 있고 청소년에게 정신 건강 문제를 일으킨다는 주장으로 인해 미국과 유럽에서 점점 더 많은 압박을 받고 있습니다.

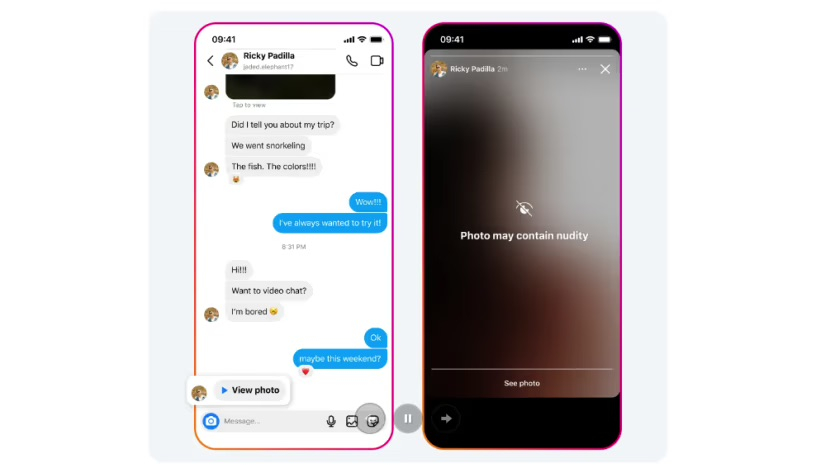

누군가 누드 사진이 포함된 인스타그램 메시지를 받으면 경고 화면 아래 이미지가 자동으로 흐릿해집니다. 사진: 메타

메타에 따르면, 인스타그램의 다이렉트 메시지 보호 기능은 기기 내 머신 러닝을 활용해 서비스를 통해 전송된 이미지에 누드 장면이 포함되어 있는지 분석할 예정입니다.

이 기능은 18세 미만 사용자에게 기본적으로 활성화되어 있으며, Meta는 성인에게 알림을 보내 이 기능을 활성화하도록 권장합니다.

회사 측은 "이미지가 기기 자체에서 분석되기 때문에 누드 사진 보호 기능은 종단 간 암호화된 채팅에서도 작동하며, 누군가가 우리에게 보고하지 않는 한 Meta는 이러한 이미지에 접근할 수 없습니다."라고 밝혔습니다.

Meta의 Messenger 및 WhatsApp 앱과 달리 Instagram 직접 메시지는 암호화되지 않지만, 회사는 사진 공유 서비스에 암호화를 도입할 계획이라고 밝혔습니다.

메타는 또한 성범죄 사기에 연루되었을 가능성이 있는 계정을 식별하는 데 도움이 되는 기술을 개발 중이며, 해당 계정과 상호 작용했을 수 있는 사용자에게 새로운 알림을 제공하는 기능을 테스트하고 있다고 밝혔습니다.

1월에 Meta는 Facebook과 Instagram에서 청소년의 콘텐츠를 더 많이 숨기겠다고 밝혔으며, 이로 인해 청소년이 자살, 자해, 섭식 장애와 같은 민감한 콘텐츠에 접근하기가 더 어려워질 것이라고 덧붙였습니다.

캘리포니아와 뉴욕을 포함한 미국 33개 주는 2023년 10월 메타(Meta)를 상대로 소송을 제기했습니다. 메타는 자사 플랫폼의 위험성에 대해 대중에게 반복적으로 거짓말을 했다고 주장했습니다. 유럽 위원회 또한 메타에 불법적이고 유해한 콘텐츠로부터 어린이를 보호하라고 명령했습니다.

마이안 (CNA에 따르면)

[광고_2]

원천

![[사진] 중앙검열위원회 제5차 애국모범대회](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/27/1761566862838_ndo_br_1-1858-jpg.webp)

![[사진] 중앙당 기관 당위원회들이 결의안 제18호-NQ/TW 이행 및 당대회 방향 등을 정리하고 있다.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/27/1761545645968_ndo_br_1-jpg.webp)

![[사진] 쩐탄만 국회의장, 우즈베키스탄 하원의장 누리딘 이스모일로프 접견](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/27/1761542647910_bnd-2610-jpg.webp)

댓글 (0)