AI가 제공하는 정보는 항상 정확한가?

정보가 뒤섞인 세상 에서 진실을 알려줄 것을 AI에만 의존하는 것은 도박이다.

AI는 옳고 그름을 알지 못하고, 단지 데이터를 반영할 뿐입니다.

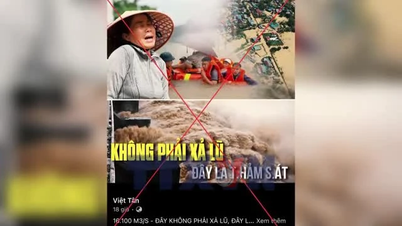

Tuoi Tre Online 에 따르면, 인공지능은 정통 지식과 음모론이 공존하는 인터넷에서 수집된 방대한 양의 데이터를 기반으로 훈련됩니다. AI는 진실과 거짓을 구분하지 않고, 오직 언어 패턴만을 기록하고 학습한 내용을 기반으로 반응합니다. 훈련 정보에 오류나 편향이 포함되어 있을 경우, AI는 해당 정보도 답변에 반영합니다.

원본 데이터 외에도 사용자가 질문에 제공하는 내용 또한 정확도에 직접적인 영향을 미칩니다. 잘못되었지만 잘 제시된 질문은 더 쉽게 AI가 "그것이 사실이라고 믿게" 만들고 그에 따라 거짓 답변을 생성합니다.

특히, 사용자가 사실이 아닌 것을 확증하는 피드백을 요청하는 경우, AI는 진실을 확인하는 것이 아니라 의미적 응답을 생성하는 것이 목표이므로 이를 "따를" 수 있습니다.

이것이 바로 AI가 "유창하게 말하지만 명백히 틀릴 수 있는" 이유이기도 합니다. AI는 인간처럼 옳고 그름을 판단하지 않고, 가장 가능성이 높은 다음 단어만 예측합니다. 이로 인해 연구자들은 환각이라고 부르는 현상이 발생하는데, AI가 그럴듯하게 들리는 가짜 정보를 만들어내는 것입니다. AI가 정확한 데이터를 찾지 못하면 이름, 사건, 심지어 과학적 연구조차도 "꾸며낼" 수 있습니다.

잘못된 정보가 넘쳐나는 세상에서 AI가 "옳다"고 말할 수 있는 때는 언제일까?

AI는 자기 인식이 불가능하지만 특정 조건 하에서는 정확한 응답을 생성할 수 있습니다 .

질문이 거짓 정보를 반박하거나 검증하는 것을 요구할 때, 모델은 부조리함을 찾아내고 반박하려는 경향이 있습니다.

예를 들어, 사용자가 "지구는 평평하기 때문에 위성이 지구를 공전할 수 없다"는 주장을 하며 분석을 요청하면, AI는 중력과 궤도의 과학을 바탕으로 반박합니다.

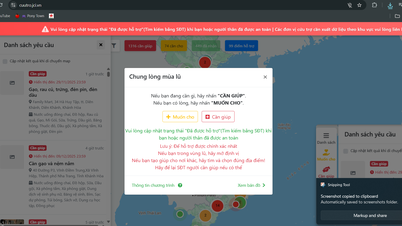

AI가 새로운 데이터에 대한 실시간 접근, 신뢰할 수 있는 출처 검색, 권위 있는 지식 저장소의 API 사용과 같은 검증 도구와 통합될 경우 "정확한 판단" 능력이 향상됩니다. 이렇게 되면 AI는 사전 훈련된 지식을 활용할 수 있을 뿐만 아니라, 이를 현실과 비교하고 업데이트할 수도 있습니다.

하지만 여전히 전제 조건은 사용자가 문제를 제기하는 방식입니다 . 처음부터 주제가 잘못되었고 AI에게 긍정적인 방식으로 글을 쓰라고 요구하면, 특히 반박하라는 요구가 없다면 AI는 그 주장을 따르는 경향이 있습니다. 이 경우, AI는 완전히 잘못된 내용을 제시하더라도 언어는 여전히 유창하고 독자에게 믿게 만들기 쉽습니다.

AI가 더욱 똑똑해질수록 사용자는 더욱 경계해야 합니다.

인공지능은 진실 검증에 있어 인간을 대체하지 않습니다. 설득력 있고 합리적인 콘텐츠를 생성할 수는 있지만, 옳고 그름을 판단할 양심과 윤리는 없습니다.사용자는 AI를 절대적인 진실의 원천이 아닌 조건부 지원 도구로 여겨야 합니다. 입력 지식이 정확할수록 AI의 응답은 더욱 신뢰할 수 있습니다.

출처: https://tuoitre.vn/ngay-cang-nhieu-thong-tin-sai-co-nen-tim-kiem-hoi-ai-20250626101350386.htm

![[사진] 팜민친 총리, 은행권 애국대회 참석](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F24%2F1763981997729_tt-nhnn-jpg.webp&w=3840&q=75)

![[사진] 홍수 후 '쓰레기 산' 옆에서 투이호아 주민들이 삶을 재건하기 위해 노력하고 있다](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F24%2F1763951389752_image-1-jpg.webp&w=3840&q=75)

댓글 (0)