Gergasi teknologi OpenAI menggembar-gemburkan alat pertuturan ke teksnya, Whisper, sebagai AI dengan 'ketepatan dan keteguhan seperti manusia.' Tetapi Whisper mempunyai satu kelemahan utama: Ia menghasilkan teks dan ayat yang benar-benar palsu.

Beberapa teks yang dijana AI - dipanggil "halusinasi" - boleh termasuk komen perkauman, bahasa ganas dan juga rawatan perubatan khayalan - Foto: AP

Beberapa teks yang dijana AI dipanggil "halusinasi," kata pakar, menurut AP, termasuk komen perkauman, bahasa ganas dan juga rawatan perubatan khayalan.

Kadar "ilusi" yang tinggi dalam teks yang dijana AI

Pakar amat bimbang kerana Whisper digunakan secara meluas dalam banyak industri di seluruh dunia untuk menterjemah dan menyalin temu bual, menjana teks dalam teknologi pengguna popular dan mencipta sari kata untuk video.

Lebih membimbangkan, banyak pusat perubatan menggunakan Whisper untuk memindahkan perundingan antara doktor dan pesakit, walaupun OpenAI telah memberi amaran bahawa alat itu tidak boleh digunakan di kawasan "berisiko tinggi".

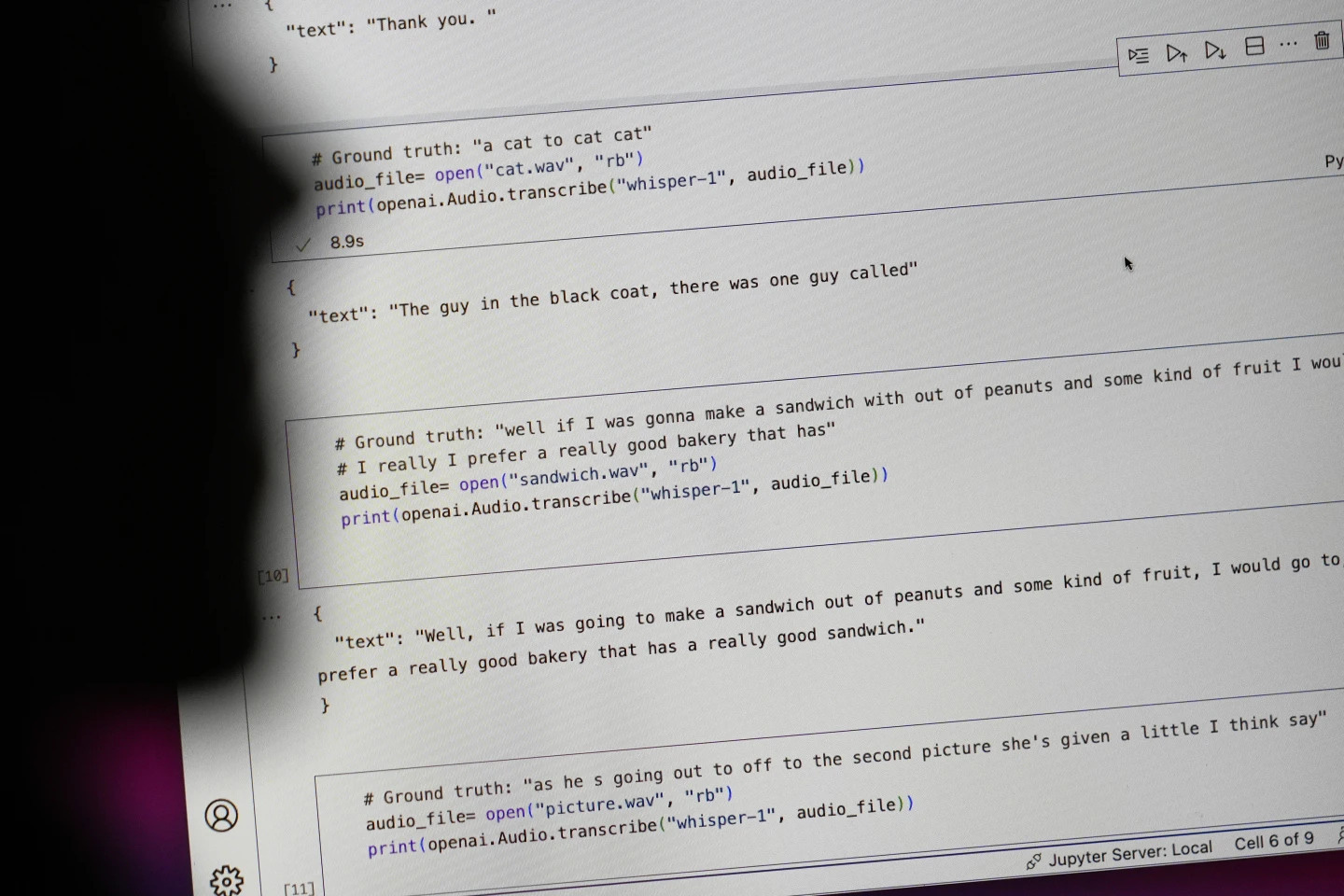

Tahap penuh masalah adalah sukar untuk ditentukan, tetapi penyelidik dan jurutera mengatakan mereka kerap menghadapi "halusinasi" Whisper dalam kerja mereka.

Seorang penyelidik di Universiti Michigan berkata dia menemui "halusinasi" dalam lapan daripada sepuluh transkripsi audio yang dia periksa. Seorang jurutera komputer menemui "halusinasi" dalam kira-kira separuh daripada transkripsi lebih daripada 100 jam audio yang dianalisisnya. Pemaju lain berkata dia menemui "halusinasi" dalam hampir semua 26,000 rakaman yang dia cipta menggunakan Whisper.

Masalahnya berterusan walaupun dengan sampel audio pendek yang dirakam dengan jelas. Satu kajian baru-baru ini oleh saintis komputer menemui 187 "ilusi" dalam lebih daripada 13,000 klip audio jelas yang mereka periksa. Kecenderungan ini akan membawa kepada puluhan ribu transkripsi palsu dalam berjuta-juta rakaman, kata para penyelidik.

Kesilapan sedemikian boleh membawa "akibat yang sangat serius," terutamanya dalam tetapan hospital, menurut Alondra Nelson, yang mengetuai Pejabat Sains dan Teknologi Rumah Putih dalam pentadbiran Biden sehingga tahun lalu.

"Tiada siapa yang mahu diagnosis salah," kata Nelson, kini seorang profesor di Institut Kajian Lanjutan di Princeton, New Jersey. "Perlu ada standard yang lebih tinggi."

Whisper juga digunakan untuk mencipta kapsyen untuk orang pekak dan kurang pendengaran—populasi yang berisiko terutamanya untuk salah terjemahan. Ini kerana orang pekak dan sukar mendengar tidak mempunyai cara untuk mengenal pasti petikan rekaan "tersembunyi dalam semua teks lain," kata Christian Vogler, yang pekak dan pengarah Program Kebolehcapaian Teknologi di Universiti Gallaudet.

OpenAI dipanggil untuk menyelesaikan masalah tersebut

Kelaziman "halusinasi" sedemikian telah menyebabkan pakar, peguam bela, dan bekas pekerja OpenAI meminta kerajaan persekutuan untuk mempertimbangkan peraturan AI. Sekurang-kurangnya, OpenAI perlu menangani kelemahan ini.

"Masalah ini boleh diselesaikan jika syarikat bersedia untuk mengutamakannya," kata William Saunders, seorang jurutera penyelidik di San Francisco yang meninggalkan OpenAI pada Februari atas kebimbangan mengenai hala tuju syarikat.

"Ia akan menjadi masalah jika anda meletakkannya di sana dan orang ramai menjadi begitu yakin tentang apa yang boleh dilakukannya sehingga mereka mengintegrasikannya ke dalam semua sistem lain ini." Jurucakap OpenAI berkata syarikat itu sentiasa mengusahakan cara untuk mengurangkan "ilusi" dan menghargai penemuan penyelidik, sambil menambah bahawa OpenAI menggabungkan maklum balas ke dalam kemas kini model.

Walaupun kebanyakan pembangun menganggap bahawa alat teks ke pertuturan boleh membuat kesilapan taip atau kesilapan lain, jurutera dan penyelidik berkata mereka tidak pernah melihat alat teks ke pertuturan berkuasa AI yang "menghaluskan" sama seperti Whisper.

Hadiah Nobel dalam Fizik 2024: Orang yang meletakkan asas untuk AI

Hadiah Nobel dalam Fizik 2024: Orang yang meletakkan asas untuk AISumber: https://tuoitre.vn/cong-cu-ai-chuyen-loi-noi-thanh-van-ban-cua-openai-bi-phat-hien-bia-chuyen-20241031144507089.htm

![[Foto] Memotong bukit untuk memberi laluan kepada orang ramai melalui laluan 14E yang mengalami tanah runtuh](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/08/1762599969318_ndo_br_thiet-ke-chua-co-ten-2025-11-08t154639923-png.webp)

![[Video] Monumen Hue dibuka semula untuk mengalu-alukan pelawat](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/05/1762301089171_dung01-05-43-09still013-jpg.webp)

Komen (0)