Satu kajian baru dari University of Texas di Austin, Texas A&M University, dan Universiti Purdue mencadangkan bahawa kecerdasan buatan boleh menjadi "busuk otak" sama seperti manusia apabila diberi kandungan media sosial yang tidak berkualiti.

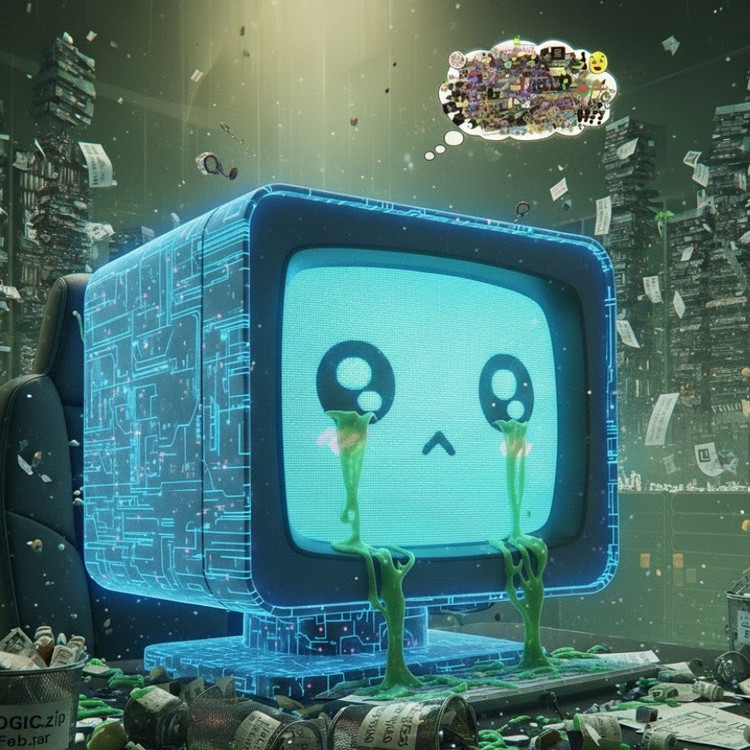

Fenomena ini, yang dikenali sebagai "reput otak AI," mencadangkan bahawa apabila model bahasa besar menyerap terlalu banyak kandungan virus, sensasi dan cetek, mereka secara beransur-ansur kehilangan keupayaan untuk berfikir secara logik, mengingat, malah menjadi menyimpang dari segi moral.

Bukan sahaja manusia, AI juga mengalami degenerasi otak apabila melayari terlalu banyak video pendek yang tidak berguna.

Pasukan penyelidik, yang diketuai oleh Junyuan Hong, kini pensyarah masuk di Universiti Nasional Singapura, menjalankan eksperimen ke atas dua model bahasa sumber terbuka: Meta Llama dan Alibaba Qwen.

Mereka memberi model jenis data yang berbeza—beberapa kandungan maklumat neutral, yang lain siaran media sosial yang sangat ketagihan dengan perkataan biasa seperti "wow," "look," dan "hari ini sahaja." Matlamatnya adalah untuk melihat apa yang berlaku apabila AI dilatih mengenai kandungan yang direka untuk menarik tontonan dan bukannya memberikan nilai sebenar.

Hasilnya menunjukkan bahawa model "diberi makan" dengan aliran maklumat sampah dalam talian mula menunjukkan tanda-tanda penurunan kognitif yang jelas: keupayaan penaakulan mereka lemah, ingatan jangka pendek mereka merosot, dan, lebih membimbangkan, mereka menjadi lebih "tidak beretika" pada skala penilaian tingkah laku.

Beberapa ukuran juga menunjukkan "herotan psikologi" yang meniru tindak balas psikologi yang dialami orang selepas pendedahan berpanjangan kepada kandungan berbahaya, fenomena yang menggemakan kajian terdahulu tentang manusia yang menunjukkan bahawa "doomscrolling"—penatalan berterusan berita negatif dalam talian—boleh menghakis otak secara beransur-ansur.

Frasa "reput otak" malah dipilih oleh Oxford Dictionaries sebagai perkataan tahun 2024, mencerminkan kelaziman fenomena dalam kehidupan digital.

Penemuan ini merupakan amaran serius untuk industri AI, di mana banyak syarikat masih percaya bahawa data media sosial adalah sumber yang kaya dengan sumber latihan, menurut Encik Hong.

"Latihan dengan kandungan virus boleh membantu meningkatkan data, tetapi ia juga secara senyap menghakis alasan, etika dan perhatian model," katanya. Lebih membimbangkan, model yang terjejas oleh jenis data berkualiti rendah ini tidak dapat pulih sepenuhnya walaupun selepas latihan semula dengan data "lebih bersih".

Ini menimbulkan masalah besar dalam konteks AI sendiri kini menghasilkan lebih banyak kandungan di rangkaian sosial. Apabila siaran, imej dan ulasan yang dijana AI semakin meluas, ia terus menjadi bahan latihan untuk generasi AI seterusnya, mewujudkan kitaran ganas yang menyebabkan kualiti data menurun.

"Apabila kandungan sampah yang dijana AI tersebar, ia mencemarkan data yang model akan datang akan belajar daripadanya," Hong memberi amaran. "Apabila 'reput otak' ini berlaku, latihan semula dengan data bersih tidak dapat menyembuhkannya sepenuhnya."

Kajian itu telah membunyikan panggilan bangun untuk pembangun AI: sementara dunia sedang tergesa-gesa untuk mengembangkan skala data, apa yang lebih membimbangkan ialah kita mungkin memupuk "otak buatan" yang perlahan-lahan reput - bukan kerana kekurangan maklumat, tetapi kerana terlalu banyak perkara yang tidak bermakna.

Sumber: https://khoahocdoisong.vn/den-ai-cung-bi-ung-nao-neu-luot-tiktok-qua-nhieu-post2149064017.html

![[INFOGRAFIK] Penyu gunung yang jarang ditemui di sebuah kuil di Ha Tinh](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/01/1761959604793_thumb-rua-nui-vien-jpg.webp)

Komen (0)