Als je wel eens op sociale media hebt rondgekeken, ben je waarschijnlijk wel eens afbeeldingen of video's tegengekomen die door AI zijn gemaakt. Veel mensen zijn erin getrapt, zoals in de virale video van konijnen die op een trampoline springen. Maar Sora – een zuster-app van ChatGPT, ontwikkeld door OpenAI – tilt AI-video naar een hoger niveau, waardoor het opsporen van nepcontent steeds urgenter wordt.

Door AI-videotools is het moeilijker dan ooit om authentieke video's te herkennen. (Bron: CNET)

Deze app, gelanceerd in 2024 en recent geüpgraded met Sora 2, heeft een interface die lijkt op die van TikTok, waarbij alle video's door AI worden gegenereerd. De "cameo"-functie maakt het mogelijk om echte mensen in gesimuleerde beelden te plaatsen, waardoor video's ontstaan die angstaanjagend realistisch zijn.

Daarom vrezen veel experts dat Sora zal leiden tot de verspreiding van deepfakes, waardoor informatie wordt vervormd en de grens tussen realiteit en fictie vervaagt. Beroemdheden zijn hier bijzonder kwetsbaar voor, wat organisaties zoals SAG-AFTRA ertoe heeft aangezet OpenAI op te roepen de bescherming te versterken.

Het identificeren van door AI gegenereerde content is een grote uitdaging voor technologiebedrijven, socialemediaplatforms en gebruikers. Maar er zijn manieren om video's te herkennen die met Sora zijn gemaakt.

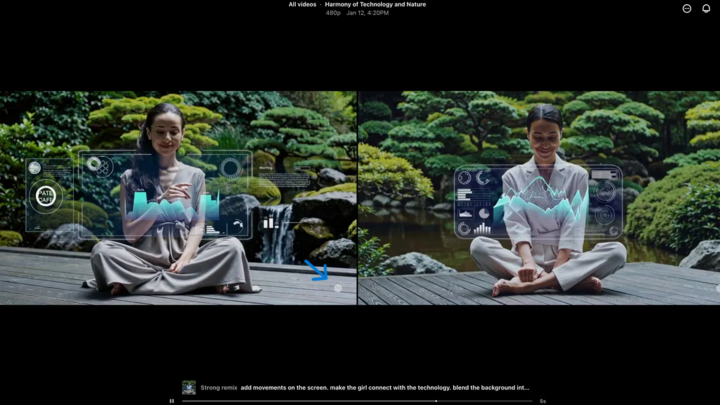

Zoek het Sora-watermerk

Het Sora-watermerk (aangegeven met de blauwe pijl) is een markering die aangeeft met welk programma de video is gemaakt. (Bron: CNET)

Elke video die met de Sora iOS-app is gemaakt, heeft een watermerk wanneer deze wordt gedownload: het witte Sora-logo (wolkpictogram) beweegt langs de randen van de video, vergelijkbaar met het watermerk van TikTok.

Dit is een visuele manier om door AI gegenereerde content te herkennen. Google's Gemini "nano-banaan"-model voegt bijvoorbeeld ook automatisch een watermerk toe aan afbeeldingen. Watermerken zijn echter niet altijd betrouwbaar. Als het watermerk statisch is, kan het gemakkelijk worden weggeknipt. Zelfs dynamische watermerken zoals die van Sora kunnen met behulp van gespecialiseerde programma's worden verwijderd.

Toen hem hiernaar gevraagd werd, betoogde Sam Altman, CEO van OpenAI, dat de maatschappij zich moet aanpassen aan de realiteit dat iedereen nepvideo's kan maken. Vóór Sora bestond er geen tool die zo populair, toegankelijk en vaardigheidsvrij was om dergelijke video's te creëren. Zijn visie benadrukt de noodzaak om te vertrouwen op alternatieve verificatiemethoden.

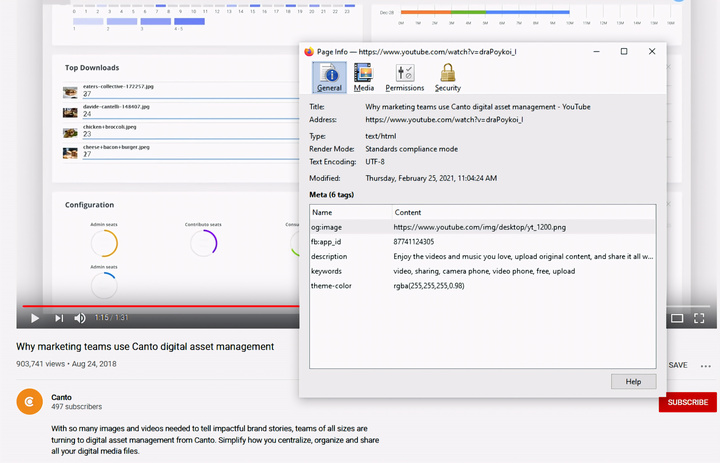

Controleer de metadata.

Het controleren van metadata – een cruciale stap om te bepalen of een video door AI, zoals Sora, is gemaakt. (Bron: Canto)

Je denkt misschien dat het controleren van metadata te ingewikkeld is, maar het is eigenlijk vrij eenvoudig en zeer effectief.

Metadata is een verzameling informatie die automatisch aan content wordt toegevoegd wanneer deze wordt aangemaakt, zoals cameratype, locatie, opnametijd en bestandsnaam. Of de content nu door mensen of door AI is gegenereerd, er is altijd metadata aanwezig. Bij door AI gegenereerde content bevat metadata vaak ook informatie over de bronvermelding.

OpenAI is lid van de Coalition for Content Origin and Authenticity (C2PA), dus Sora-video's bevatten C2PA-metadata. Je kunt dit controleren met de verificatietool van het initiatief voor contentauthenticiteit:

Hoe controleer je metadata?

- Bezoek verify.contentauthenticity.org

- Upload het bestand dat gecontroleerd moet worden.

- Druk op “Openen”

- Zie de informatie in de tabel aan de rechterkant.

Als de video door AI is gemaakt, staat dat duidelijk vermeld in de samenvatting. Bij het controleren van Sora-video's zie je de regel "gepubliceerd door OpenAI" en informatie die bevestigt dat de video met behulp van AI is gemaakt. Alle Sora-video's moeten deze informatie bevatten om hun herkomst te verifiëren.

Bron: https://vtcnews.vn/cach-nhan-biet-video-that-hay-do-ai-tao-ar972891.html

![[Foto] Premier Pham Minh Chinh ontvangt de Laotiaanse minister van Onderwijs en Sport Thongsalith Mangnormek](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765876834721_dsc-7519-jpg.webp&w=3840&q=75)

![[Foto] Premier Pham Minh Chinh ontvangt de gouverneur van de provincie Tochigi (Japan)](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765892133176_dsc-8082-6425-jpg.webp&w=3840&q=75)

![[Live] Gala van de Community Action Awards 2025](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765899631650_ndo_tr_z7334013144784-9f9fe10a6d63584c85aff40f2957c250-jpg.webp&w=3840&q=75)

![[Afbeelding] Gelekte afbeeldingen voorafgaand aan het Community Action Awards-gala van 2025.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765882828720_ndo_br_thiet-ke-chua-co-ten-45-png.webp&w=3840&q=75)

![[Afbeelding] De vasthoudende vechtlust van het Vietnamese vrouwenvoetbal](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F17%2F1765990260956_ndo_br_4224760955870434771-copy-jpg.webp&w=3840&q=75)

![[Live] Afsluitingsceremonie en prijsuitreiking voor de video-/clipwedstrijd "Indrukwekkend Vietnamees Toerisme" 2025](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/17/1765974650260_z7273498850699-00d2fd6b0972cb39494cfa2559bf85ac-1765959338756946072104-627-0-1338-1138-crop-1765959347256801551121.jpeg)

Reactie (0)