Een groep vooraanstaande internationale experts kwam vorige week in Beijing bijeen om ‘rode lijnen’ in de ontwikkeling van AI te identificeren, waaronder de ontwikkeling van biologische wapens en het uitvoeren van cyberaanvallen.

In een verklaring, enkele dagen na de bijeenkomst, waarschuwden de academici dat een gemeenschappelijke aanpak van AI-veiligheid nodig is om “catastrofale of zelfs existentiële risico’s voor de mensheid tijdens ons leven” te voorkomen.

"Op het hoogtepunt van de Koude Oorlog hielpen internationale overheids- en wetenschappelijke samenwerking een nucleaire ramp te voorkomen. De mensheid moet opnieuw samenwerken om de catastrofe te voorkomen die zou kunnen ontstaan door ongekende technologie", aldus de verklaring.

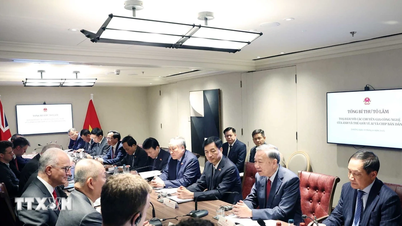

Deskundigen op de Internationale Dialoog over AI-veiligheid in Peking hebben 'rode lijnen' in de ontwikkeling van AI geïdentificeerd. Foto: FT

Onder de ondertekenaars bevinden zich Geoffrey Hinton en Yoshua Bengio, die vaak worden omschreven als de 'vaders' van AI; Stuart Russell, hoogleraar computerwetenschappen aan de Universiteit van Californië; en Andrew Yao, een van China's meest vooraanstaande computerwetenschappers.

De verklaring volgt op de International AI Safety Dialogue in Beijing vorige week, een bijeenkomst waarbij Chinese overheidsfunctionarissen hun goedkeuring gaven aan het forum en de uitkomsten ervan.

De Amerikaanse president Joe Biden en de Chinese president Xi Jinping ontmoetten elkaar in november vorig jaar en bespraken de veiligheid van AI. Ze kwamen overeen een dialoog over dit onderwerp op te starten. Toonaangevende internationale AI-bedrijven hebben de afgelopen maanden ook privégesprekken gevoerd met Chinese AI-experts.

In november 2023 kwamen 28 landen, waaronder China, en toonaangevende AI-bedrijven overeen om samen te werken om existentiële risico's als gevolg van geavanceerde AI aan te pakken. Dit gebeurde tijdens de AI-veiligheidstop van de Britse minister van Financiën Rishi Sunak.

In Beijing bespraken experts vorige week de bedreigingen die samenhangen met de ontwikkeling van ‘Artificial General Intelligence – AGI’, oftewel AI-systemen die gelijkwaardig zijn aan of beter zijn dan mensen.

"De kern van de discussie lag op de rode lijnen die geen enkel krachtig AI-systeem mag overschrijden en die regeringen over de hele wereld moeten opleggen bij de ontwikkeling en inzet van AI", aldus Bengio.

Deze rode lijnen zouden ervoor zorgen dat ‘geen enkel AI-systeem zichzelf kan repliceren of verbeteren zonder expliciete menselijke toestemming en steun’ of ‘acties kan ondernemen die zijn macht en invloed onnodig vergroten’.

De wetenschappers voegden eraan toe dat geen enkel systeem ‘de mogelijkheid van actoren om massavernietigingswapens te ontwerpen, de conventie over biologische of chemische wapens te schenden, aanzienlijk zou vergroten’ of in staat zou zijn om ‘automatisch cyberaanvallen uit te voeren die leiden tot ernstig financieel verlies of gelijkwaardige schade’.

Hoang Hai (volgens FT)

Bron

![[Video] Hue Monumenten heropenen om bezoekers te verwelkomen](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/05/1762301089171_dung01-05-43-09still013-jpg.webp)

![Dong Nai OCOP-transitie: [Deel 2] Het openen van een nieuw distributiekanaal](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/09/1762655780766_4613-anh-1_20240803100041-nongnghiep-154608.jpeg)

Reactie (0)