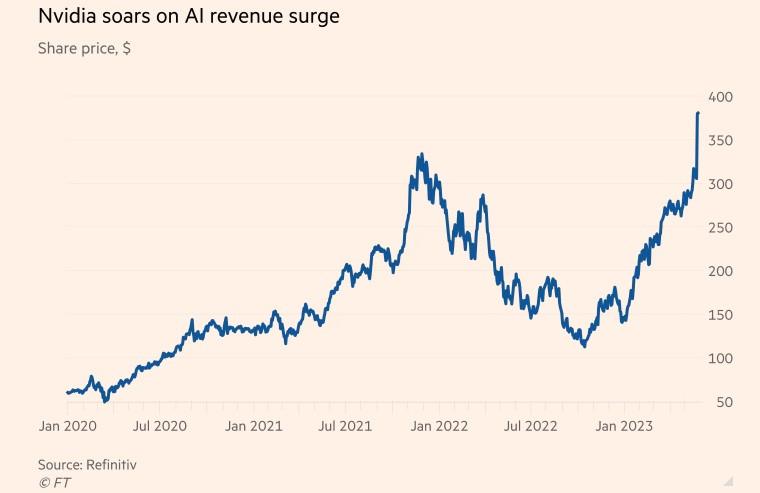

Nvidia var en gang kjent som en produsent av brikker brukt i videospill, men har de siste årene flyttet fokuset til datasentermarkedet.

Det amerikanske chipselskapet har blomstret under pandemien, ettersom etterspørselen etter spill og skyapplikasjoner har økt kraftig og en kryptovalutautvinningsmani har spredt seg over hele verden . Ved utgangen av regnskapsåret som sluttet 29. januar, sto datasenterbrikkevirksomheten for mer enn 50 % av selskapets inntekter.

I mellomtiden tok den populære chatboten ChatGPT generativ kunstig intelligens (KI) til neste nivå i år, ved å bruke store mengder eksisterende data til å lage nytt innhold om emner som spenner fra poesi til dataprogrammering.

Microsoft og Alphabet, to teknologigiganter, er også store aktører innen AI, og tror at generativ teknologi kan endre måten folk jobber på. Begge har lansert et kappløp om å integrere AI i søkemotorer så vel som kontorprogramvare med ambisjon om å dominere denne bransjen.

Goldman Sachs anslår at amerikanske investeringer i AI kan utgjøre omtrent 1 % av landets økonomiske produksjon innen 2030.

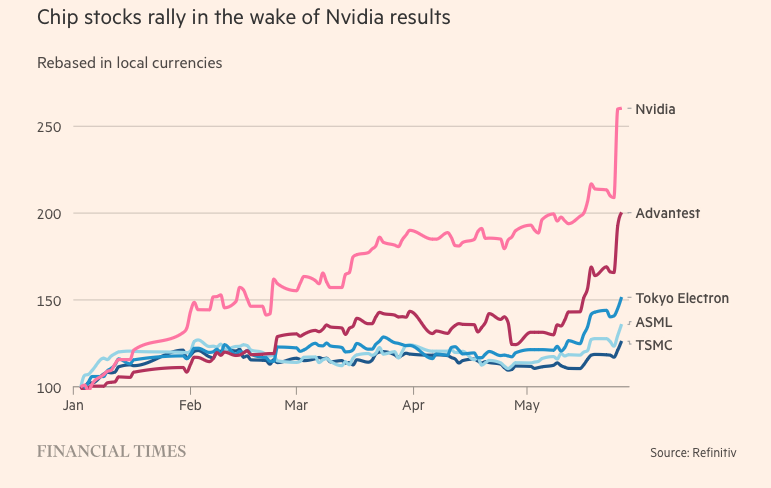

Superdatamaskiner som brukes til å behandle data og kjøre generativ AI er avhengige av grafikkprosessorer (GPU-er). GPU-er er designet for å håndtere spesifikke beregninger relatert til AI-databehandling, mye mer effektivt enn sentrale prosessorer fra andre brikkeprodusenter som Intel. For eksempel drives OpenAIs ChatGPT av tusenvis av Nvidia GPU-er.

I mellomtiden har Nvidia omtrent 80 % av GPU-markedet. Nvidias hovedkonkurrenter inkluderer Advanced Micro Devices og interne AI-brikker fra teknologiselskaper som Amazon, Google og Meta Platforms.

Hemmeligheten bak sublimering

Selskapets sprang fremover ble muliggjort av H100, en brikke basert på Nvidias nye arkitektur kalt «Hopper» – oppkalt etter den amerikanske programmeringspioneren Grace Hopper. Eksplosjonen av kunstig intelligens har gjort H100 til den heteste varen i Silicon Valley.

De superstore brikkene som brukes i datasentre har 80 milliarder transistorer, fem ganger så mye silisium som driver de nyeste iPhonene. Selv om de koster dobbelt så mye som forgjengeren A100 (utgitt i 2020), sier H100-brukere at de tilbyr tre ganger så god ytelse.

H100 har vist seg spesielt populær blant «Big Tech»-selskaper som Microsoft og Amazon, som bygger hele datasentre fokusert på AI-arbeidsbelastninger, og nye generasjons AI-oppstartsbedrifter som OpenAI, Anthropic, Stability AI og Inflection AI, ettersom den lover høyere ytelse som kan fremskynde produktlanseringer eller redusere opplæringskostnader over tid.

«Dette er en av de mest knappe ingeniørressursene der ute», sa Brannin McBee, strategidirektør og grunnlegger av CoreWeave, en AI-basert skybasert oppstartsbedrift som var et av de første selskapene som mottok H100-leveranser tidligere i år.

Andre kunder er ikke like heldige som CoreWeave, og må vente opptil seks måneder på å få produktet til å trene sine massive datamodeller. Mange AI-oppstartsbedrifter er bekymret for at Nvidia ikke vil være i stand til å møte markedets etterspørsel.

Elon Musk bestilte også tusenvis av Nvidia-brikker til sin AI-oppstartsbedrift, og sa at «GPU-er er vanskeligere å få tak i enn medisiner akkurat nå».

«Datakostnadene har skutt i været. Minimumsbeløpet som brukes på servermaskinvare som brukes til å bygge kreativ AI har nådd 250 millioner dollar», delte Tesla-sjefen.

Selv om H100 er tidsriktig, stammer Nvidias AI-gjennombrudd to tiår tilbake i tid, til programvareinnovasjon snarere enn maskinvare. I 2006 introduserte selskapet Cuda-programvare, som lar GPU-er brukes som akseleratorer for andre oppgaver enn grafikk.

«Nvidia så fremtiden før alle andre og gikk over til programmerbare GPU-er. De så muligheten, satset stort og overgikk konsekvent konkurrentene sine», sa Nathan Benaich, partner i Air Street Capital og investor i AI-oppstartsbedrifter.

(Ifølge Reuters og Financial Times)

[annonse_2]

Kilde

![[Foto] Lam Dong: Nærbilde av ulovlig innsjø med ødelagt vegg](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/03/1762166057849_a5018a8dcbd5478b1ec4-jpg.webp)

![[Foto] Statsminister Pham Minh Chinh mottar formannen for Japan-Vietnam vennskapsforening i Kansai-regionen.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/03/1762176259003_ndo_br_dsc-9224-jpg.webp)

![[Foto] Høstmessen 2025 og imponerende rekorder](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/03/1762180761230_ndo_br_tk-hcmt-15-jpg.webp)

![[Foto] Generalsekretær To Lam mottar Singapores ambassadør Jaya Ratnam](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/03/1762171461424_a1-bnd-5309-9100-jpg.webp)

Kommentar (0)