Złożony obraz wykorzystania robotów zabójców opartych na sztucznej inteligencji.

Umożliwienie sztucznej inteligencji kontrolowania systemów uzbrojenia mogłoby oznaczać identyfikację, atak i zniszczenie celów bez ingerencji człowieka. Rodzi to poważne wątpliwości prawne i etyczne.

Podkreślając powagę sytuacji, austriacki minister spraw zagranicznych Alexander Schallenberg stwierdził: „To moment Oppenheimera naszego pokolenia”.

Roboty i broń oparta na sztucznej inteligencji zaczynają być szeroko stosowane w armiach wielu krajów. Zdjęcie: Forbes

Rzeczywiście, w jakim stopniu „dżin wydostał się ze słoika” stało się palącym pytaniem, biorąc pod uwagę powszechne wykorzystanie dronów i sztucznej inteligencji (AI) przez armie na całym świecie .

Analityk ds. obronności w firmie GlobalData, Wilson Jones, stwierdził: „Wykorzystanie dronów przez Rosję i Ukrainę we współczesnych konfliktach, wykorzystanie dronów przez Stany Zjednoczone w ukierunkowanych operacjach uderzeniowych w Afganistanie i Pakistanie, a także, jak ujawniono niedawno w zeszłym miesiącu, w ramach izraelskiego programu Lavender, pokazują, w jaki sposób możliwości przetwarzania informacji przez sztuczną inteligencję są aktywnie wykorzystywane przez armie całego świata w celu zwiększenia ich siły ofensywnej”.

Dochodzenia przeprowadzone przez londyński Urząd Śledczy Wojennych wykazały, że system sztucznej inteligencji Lavender izraelskiej armii osiągnął 90% skuteczność w identyfikowaniu osób powiązanych z Hamasem, co oznacza, że 10% nie było. Doprowadziło to do ofiar wśród ludności cywilnej z powodu możliwości identyfikacji i podejmowania decyzji przez sztuczną inteligencję.

Zagrożenie dla bezpieczeństwa globalnego.

Zastosowanie sztucznej inteligencji w ten sposób podkreśla potrzebę zarządzania technologią w systemach uzbrojenia.

Dr Alexander Blanchard, starszy pracownik naukowy programu zarządzania sztuczną inteligencją w Sztokholmskim Międzynarodowym Instytucie Badań nad Pokojem (SIPRI), niezależnej grupie badawczej zajmującej się bezpieczeństwem globalnym, wyjaśnił w rozmowie z Army Technology: „Wykorzystanie sztucznej inteligencji w systemach uzbrojenia, zwłaszcza w celu namierzania, rodzi fundamentalne pytania o to, kim jesteśmy – ludźmi – i o nasz związek z wojną, a dokładniej o nasze założenia dotyczące tego, jak możemy używać przemocy w konfliktach zbrojnych”.

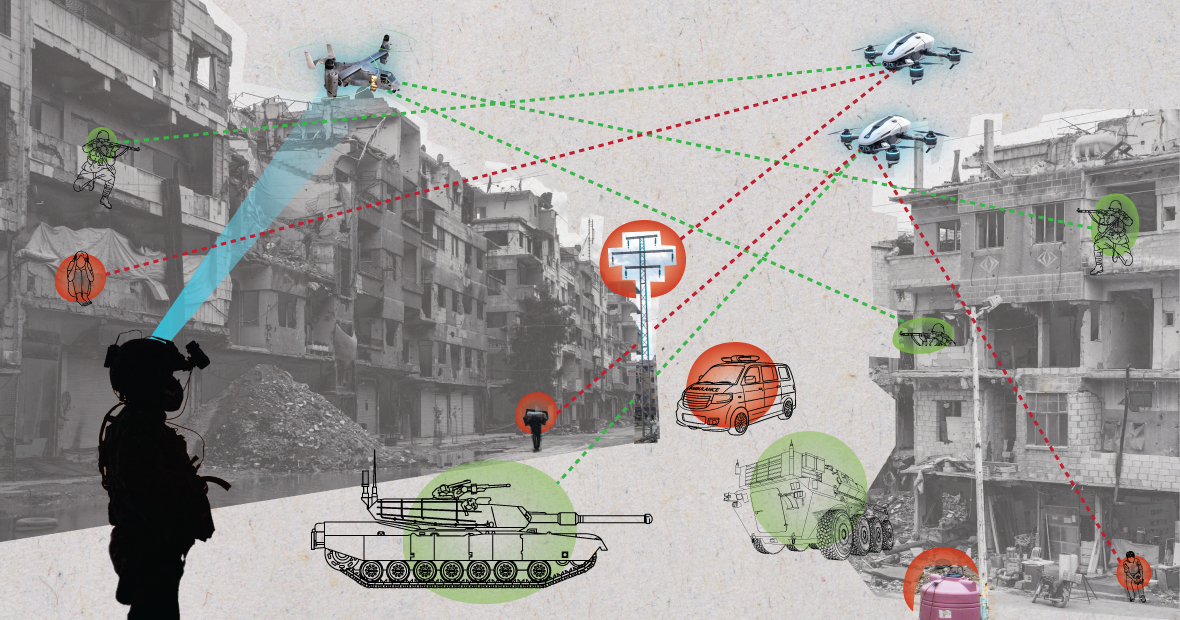

W środowiskach chaotycznych systemy sztucznej inteligencji mogą działać nieprzewidywalnie i nie identyfikować celów precyzyjnie. (Grafika: MES)

„Czy sztuczna inteligencja zmieni sposób, w jaki armie wybierają cele i stosują wobec nich siłę? Te zmiany z kolei rodzą szereg pytań prawnych, etycznych i operacyjnych. Największym zmartwieniem są kwestie humanitarne” – dodał dr Blanchard.

Ekspert SIPRI wyjaśnił: „Wiele osób obawia się, że w zależności od sposobu projektowania i użytkowania systemów zautomatyzowanych, mogą one narażać ludność cywilną i inne osoby chronione prawem międzynarodowym na większe ryzyko. Dzieje się tak, ponieważ systemy sztucznej inteligencji, zwłaszcza używane w chaotycznych środowiskach, mogą działać nieprzewidywalnie i mogą nie być w stanie precyzyjnie identyfikować celów i atakować ludność cywilną lub nie być w stanie zidentyfikować bojowników znajdujących się poza linią ognia”.

Rozwijając tę kwestię, analityk ds. obronności w GlobalData, Wilson Jones, zauważa, że definicja winy może budzić wątpliwości.

„W obecnym prawie wojennym istnieje koncepcja odpowiedzialności dowództwa” – powiedział Jones. „Oznacza to, że oficer, generał lub inny dowódca ponosi prawną odpowiedzialność za działania podległych mu żołnierzy. Jeśli żołnierze dopuszczą się zbrodni wojennych, oficer ponosi odpowiedzialność, nawet jeśli nie wydał rozkazu; ciężar dowodu spoczywa na nim, który musi wykazać, że zrobił wszystko, co możliwe, aby zapobiec zbrodniom wojennym”.

„W przypadku systemów AI to komplikuje sprawę. Czy odpowiedzialny jest technik IT? Projektant systemów? Nie jest to jasne. Jeśli nie jest to jasne, stwarza to ryzyko moralne, jeśli podmioty uważają, że ich działania nie są chronione przez obowiązujące prawo” – podkreślił Jones.

Żołnierz USA patroluje teren z robotem-psem. Zdjęcie: Forbes

Konwencje dotyczące kontroli zbrojeń: Kilka ważnych porozumień międzynarodowych ogranicza i reguluje niektóre zastosowania broni. Należą do nich zakaz broni chemicznej, traktaty o nierozprzestrzenianiu broni jądrowej oraz Konwencja o niektórych rodzajach broni konwencjonalnej, które zakazują lub ograniczają użycie określonej broni uznawanej za powodującą niepotrzebne lub nieuzasadnione cierpienie kombatantów lub mającą bezwzględny wpływ na ludność cywilną.

„Kontrola zbrojeń nuklearnych wymaga dziesięcioleci współpracy międzynarodowej i późniejszych traktatów, aby była egzekwowalna” – wyjaśnia analityk ds. obronności Wilson Jones. „Nawet wtedy kontynuowaliśmy testy w atmosferze aż do lat 90. XX wieku. Głównym powodem sukcesu nierozprzestrzeniania broni jądrowej była współpraca między Stanami Zjednoczonymi a Związkiem Radzieckim w ramach dwubiegunowego porządku świata. To już nie istnieje, a technologia sztucznej inteligencji stała się bardziej dostępna dla większej liczby krajów niż energia atomowa”.

Wiążący traktat musiałby doprowadzić do tego, by wszystkie zaangażowane strony zgodziły się nie używać narzędzia wzmacniającego ich siłę militarną. Jest mało prawdopodobne, aby to było skuteczne, ponieważ sztuczna inteligencja może poprawić skuteczność militarną przy minimalnych kosztach finansowych i materiałowych.

Obecna perspektywa geopolityczna

Chociaż państwa będące członkami Organizacji Narodów Zjednoczonych uznały potrzebę odpowiedzialnego wykorzystania sztucznej inteligencji przez wojsko, wciąż pozostaje wiele do zrobienia.

Laura Petrone, główna analityczka w GlobalData, powiedziała w rozmowie z Army Technology: „Z powodu braku jasnych ram zarządzania, te deklaracje pozostają w dużej mierze ambitne. Nic dziwnego, że niektóre kraje chcą zachować swoją suwerenność, podejmując decyzje w sprawach obrony wewnętrznej i bezpieczeństwa narodowego, zwłaszcza w kontekście obecnych napięć geopolitycznych”.

Pani Petrone dodała, że ustawa UE o sztucznej inteligencji ustanawia pewne wymogi dla systemów sztucznej inteligencji, ale nie odnosi się do systemów sztucznej inteligencji wykorzystywanych w celach wojskowych.

„Uważam, że pomimo tego wykluczenia, ustawa o sztucznej inteligencji (AI) stanowi ważny krok w kierunku ustanowienia długo oczekiwanych ram dla zastosowań AI, co może doprowadzić do pewnego stopnia harmonizacji odpowiednich norm w przyszłości” – skomentowała. „Ta harmonizacja będzie miała również kluczowe znaczenie dla AI w wojsku”.

Nguyen Khanh

Source: https://www.congluan.vn/moi-nguy-robot-sat-thu-ai-dang-de-doa-an-ninh-toan-cau-post304170.html

![[Zdjęcie] Premier Pham Minh Chinh przewodniczy konferencji ogłaszającej utworzenie Międzynarodowego Centrum Finansowego w Wietnamie.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F21%2F1766309817714_ndo_br_dsc-3400-jpg.webp&w=3840&q=75)

![[Zdjęcie] Premier Pham Minh Chinh przewodniczy spotkaniu na temat rozwoju gospodarczego sektora prywatnego.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F20%2F1766237501876_thiet-ke-chua-co-ten-40-png.webp&w=3840&q=75)

Komentarz (0)