Pesquisadores da DeepSeek anunciaram um novo modelo experimental chamado V3.2-exp, projetado para reduzir significativamente o custo de inferência quando usado em operações de longo contexto.

A DeepSeek anunciou o modelo em uma publicação no Hugging Face e também publicou um artigo acadêmico vinculado no GitHub.

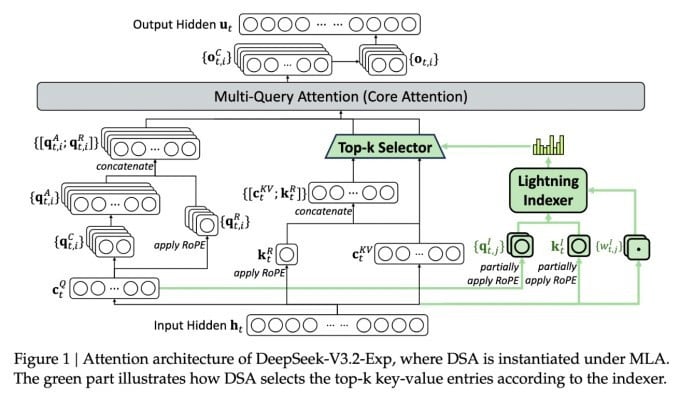

O recurso mais importante do novo modelo complexo é chamado DeepSeek Sparse Attention. Essencialmente, o sistema utiliza um módulo chamado "indexador relâmpago" para priorizar trechos específicos da janela de contexto.

DeepSeek anuncia modelo de inferência econômico.

Um sistema separado, denominado "sistema de seleção de tokens de granularidade fina", seleciona tokens específicos desses trechos para carregar na janela de atenção limitada do módulo. Combinados, eles permitem que modelos de Atenção Esparsa operem em grandes trechos de contexto com carga de servidor relativamente baixa.

Para operações de longo contexto, os benefícios do sistema são significativos. Os testes preliminares do DeepSeek mostram que o custo de uma simples chamada de função de inferência (API) pode ser reduzido em até metade em cenários de longo contexto.

Mais testes são necessários para construir uma avaliação mais robusta, mas como o modelo é aberto e está disponível gratuitamente no Hugging Face, não deve demorar muito para que testes de terceiros possam avaliar as alegações do artigo.

Ao contrário de outros modelos de chatbot de IA que consomem muita energia, o DeepSeek vai na direção da economia de custos, do treinamento à operação.

O novo modelo da DeepSeek é um de uma série de avanços recentes que abordam o problema do custo de inferência — essencialmente, o custo do servidor para executar um modelo de IA pré-treinado, em oposição ao custo de treiná-lo.

No caso do DeepSeek, os pesquisadores estavam procurando maneiras de tornar a arquitetura básica do transformador mais eficiente e descobriram que melhorias significativas precisavam ser feitas.

Com sede na China, a DeepSeek é uma figura incomum na onda da IA, especialmente para aqueles que veem a pesquisa em IA como uma competição entre os EUA e a China. A empresa causou impacto no início deste ano com seu modelo R1, treinado principalmente com aprendizado por reforço a um custo muito menor do que seus concorrentes americanos.

No entanto, o modelo não conseguiu desencadear a revolução em larga escala no treinamento de IA que alguns previram, e a empresa lentamente se retirou dos holofotes nos meses seguintes.

É improvável que a nova abordagem de “atenção esparsa” cause tanta indignação quanto a R1 — mas ainda pode ensinar aos provedores de serviços dos EUA alguns truques muito necessários para ajudar a manter os custos de inferência baixos.

https://techcrunch.com/2025/09/29/deepseek-releases-sparse-attention-model-that-cuts-api-costs-in-half/

Fonte: https://khoahocdoisong.vn/deepseek-dao-tao-da-re-nay-con-co-ban-suy-luan-re-hon-post2149057353.html

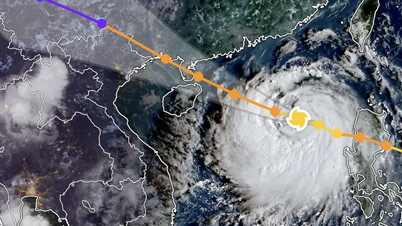

![[Foto] Primeiro-ministro Pham Minh Chinh preside reunião para superar as consequências da tempestade nº 10](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/544f420dcc844463898fcbef46247d16)

![[Foto] Alunos da Escola Primária Binh Minh aproveitam o festival da lua cheia, recebendo as alegrias da infância](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/8cf8abef22fe4471be400a818912cb85)

![[Infográfico] Números notáveis após 3 meses de "reorganização do país"](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/4/ce8bb72c722348e09e942d04f0dd9729)

![[Infográfico] Números notáveis após 3 meses de "reorganização do país"](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/10/4/ce8bb72c722348e09e942d04f0dd9729)

Comentário (0)