Jeffrey McGregor, CEO da Truepic, acredita que esse incidente é apenas a ponta do iceberg. Ele afirma que mais conteúdo gerado por IA aparecerá nas redes sociais e que ainda não estamos preparados para isso.

Segundo a CNN, a Truepic pretende resolver esse problema fornecendo uma tecnologia que verifica a autenticidade da mídia no momento da criação, por meio do Truepic Lens. O aplicativo de coleta de dados informará aos usuários a data, a hora, o local e o dispositivo usado para criar a imagem, além de aplicar uma assinatura digital para verificar se a imagem é natural ou gerada por inteligência artificial.

Uma foto falsa de uma explosão no Pentágono viralizou no Twitter.

A Truepic, uma empresa apoiada pela Microsoft e fundada em 2015, está despertando o interesse de ONGs , empresas de mídia e até mesmo seguradoras, que buscam maneiras de validar a legitimidade das reivindicações.

McGregor afirmou que, quando tudo pode ser falsificado, quando a inteligência artificial atinge seu ápice em termos de qualidade e acessibilidade, não sabemos mais o que é a realidade quando estamos online.

Empresas de tecnologia como a Truepic vêm trabalhando para combater a desinformação online há anos. Mas o surgimento de uma série de novas ferramentas de IA capazes de gerar imagens e textos sob comando do usuário aumentou a urgência. No início deste ano, imagens falsas do Papa Francisco com um colete salva-vidas da Balenciaga e do ex-presidente dos EUA, Donald Trump, sendo preso foram amplamente compartilhadas. Ambos os incidentes deixaram milhões de pessoas alarmadas com os potenciais perigos da IA.

Alguns legisladores estão agora a apelar às empresas de tecnologia para que abordem a questão, rotulando o conteúdo gerado por IA. A vice-presidente da Comissão Europeia, Vera Jourová, afirmou que empresas como a Google, a Meta, a Microsoft e o TikTok aderiram ao Código de Boas Práticas Voluntárias da União Europeia no combate à desinformação.

Cada vez mais, startups e gigantes da tecnologia, incluindo algumas que estão implementando a geração de IA em seus produtos, estão tentando implantar padrões e soluções para ajudar as pessoas a determinar se uma imagem ou vídeo foi criado usando IA.

Mas, à medida que a tecnologia de IA avança mais rápido do que os humanos conseguem acompanhar, permanece incerto se essas soluções podem resolver o problema de forma definitiva. Até mesmo a OpenAI, empresa por trás do Dal-E e do ChatGPT, reconheceu que seus próprios esforços para ajudar a detectar escrita gerada por IA são imperfeitos.

As empresas que desenvolvem soluções estão adotando duas abordagens para lidar com o problema. A primeira se baseia no desenvolvimento de programas para identificar imagens geradas por IA depois que elas são produzidas e compartilhadas online. A outra se concentra em marcar uma imagem como real ou gerada por IA usando algum tipo de assinatura digital.

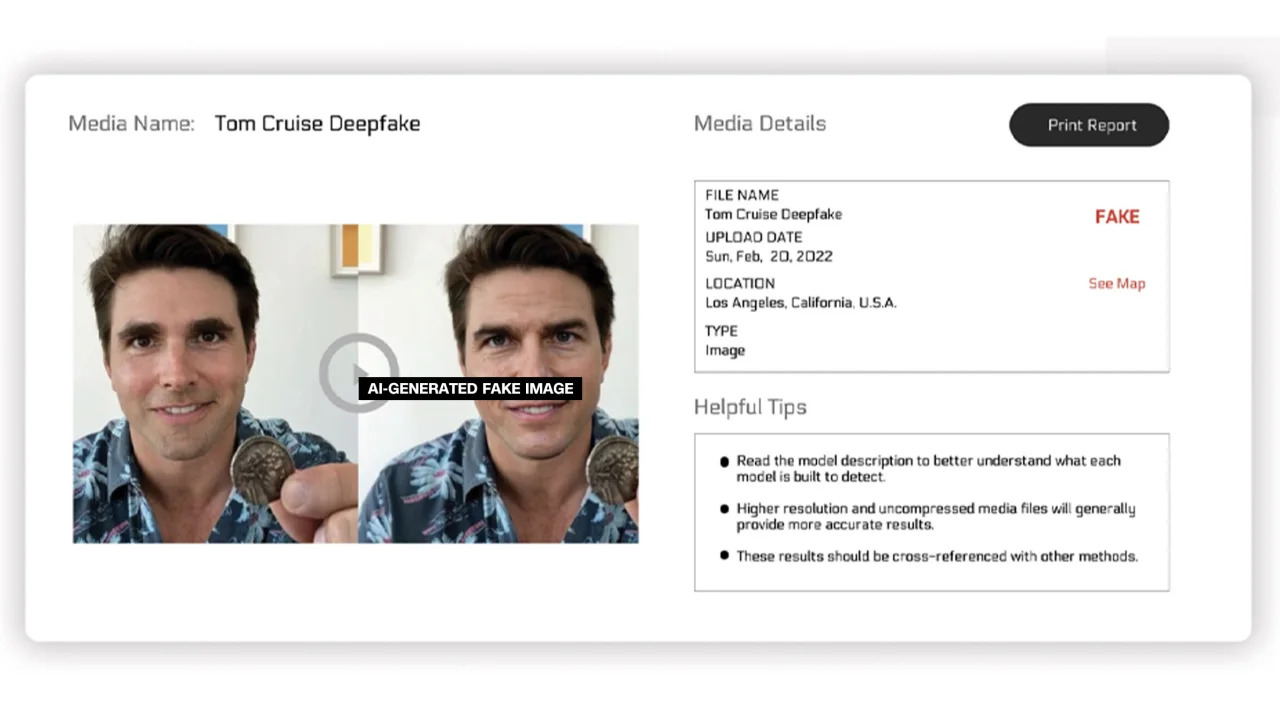

A Reality Defender e a Hive Moderation estão pesquisando a primeira abordagem. Com a plataforma delas, os usuários podem enviar imagens para análise e receber um relatório com uma porcentagem que indica se a imagem é real ou gerada por IA.

A Reality Defender afirma que utiliza tecnologia proprietária de impressão digital de conteúdo e deepfake para detectar vídeos, áudios e imagens gerados por IA. Em um exemplo fornecido pela empresa, a Reality Defender mostra uma imagem deepfake de Tom Cruise, que tem uma classificação de "suspeita" de 53% porque a pessoa na imagem tem o rosto distorcido, uma ocorrência comum em fotos manipuladas.

Imagens etiquetadas com tags geradas por IA.

Esses serviços oferecem versões gratuitas e pagas. A Hive Moderation afirma cobrar US$ 1,50 por 1.000 imagens. A Realty Defender diz que seus preços podem variar de acordo com diversos fatores, incluindo se o cliente precisa de conhecimento especializado e suporte da empresa. O CEO da Realty Defender, Ben Colman, afirma que os riscos estão dobrando a cada mês porque qualquer pessoa pode criar imagens falsas usando ferramentas de IA.

Diversas outras empresas estão trabalhando para integrar um tipo de adesivo em imagens para certificar se elas são reais ou geradas por IA. Até o momento, esse esforço tem sido impulsionado principalmente pela Coalizão para Autenticidade e Origem do Conteúdo (C2PA).

A C2PA foi criada em 2021 para estabelecer um padrão técnico para certificar a origem e o histórico da mídia digital, combinando a Content Authenticity Initiative (CAI) da Adobe e o Project Origin, liderado pela Microsoft e pela BBC, com o objetivo de combater a desinformação em notícias digitais. Outras empresas participantes da C2PA incluem Truepic, Intel e Sony.

Com base nos princípios do C2PA, a CAI fornecerá ferramentas de código aberto para que as empresas criem credenciais de conteúdo ou metadados contendo informações sobre imagens. De acordo com o site da CAI, isso permite que os criadores compartilhem de forma transparente detalhes sobre como criam uma imagem. Dessa forma, os usuários finais podem acessar o contexto sobre quem, o quê e como a imagem foi alterada – e então avaliar a autenticidade da imagem por si mesmos.

Muitas empresas integraram o padrão C2PA e ferramentas de IA assistida por computador (CAI) em seus aplicativos. O Adobe Firefly — uma nova ferramenta de criação de imagens com IA adicionada ao Photoshop — está em conformidade com o padrão C2PA por meio de seu recurso de Credenciais de Conteúdo. A Microsoft também anunciou que imagens e vídeos criados com o Bing Image Creator e o Microsoft Designer terão assinaturas criptografadas nos próximos meses.

Em maio, o Google anunciou o recurso "Sobre esta imagem", que permite aos usuários ver quando uma imagem apareceu pela primeira vez no Google e onde ela pode ser encontrada. A gigante das buscas também anunciou que todas as imagens geradas por IA do Google terão uma marcação no arquivo original para "adicionar contexto" caso a imagem seja encontrada em outro site ou plataforma.

Enquanto as empresas de tecnologia tentam lidar com as preocupações sobre imagens geradas por IA e a integridade da mídia digital, especialistas da área enfatizam que as empresas precisarão colaborar entre si e com os governos para resolver o problema. Mesmo assim, as empresas de tecnologia continuam a investir no desenvolvimento de IA, apesar dos riscos.

Link da fonte

![[Foto] O primeiro-ministro Pham Minh Chinh preside uma reunião sobre o desenvolvimento econômico do setor privado.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F20%2F1766237501876_thiet-ke-chua-co-ten-40-png.webp&w=3840&q=75)

![[Foto] O primeiro-ministro Pham Minh Chinh preside a conferência que anuncia a criação do Centro Financeiro Internacional no Vietnã.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F21%2F1766309817714_ndo_br_dsc-3400-jpg.webp&w=3840&q=75)

Comentário (0)