Новое исследование Техасского университета в Остине, Техасского университета A&M и Университета Пердью предполагает, что искусственный интеллект может стать «гнилым», как и человек, если ему скармливать некачественный контент в социальных сетях.

Это явление, известное как «гниение мозга ИИ», предполагает, что когда большие языковые модели поглощают слишком много вирусного, сенсационного и поверхностного контента, они постепенно теряют способность мыслить логически, запоминать и даже становятся морально девиантными.

Не только люди, но и искусственный интеллект страдает от дегенерации мозга при просмотре слишком большого количества бесполезных коротких видеороликов .

Исследовательская группа под руководством Цзюньюаня Хуна, ныне преподавателя Национального университета Сингапура, провела эксперименты с двумя языковыми моделями с открытым исходным кодом: Llama от Meta и Qwen от Alibaba.

Они снабжали модели разными типами данных: некоторые представляли собой нейтральный информационный контент, другие — вызывающие привыкание посты в социальных сетях с распространёнными словами, такими как «вау», «смотри» и «только сегодня». Цель состояла в том, чтобы увидеть, что произойдёт, если ИИ обучать на контенте, предназначенном для привлечения просмотров, а не для предоставления реальной ценности.

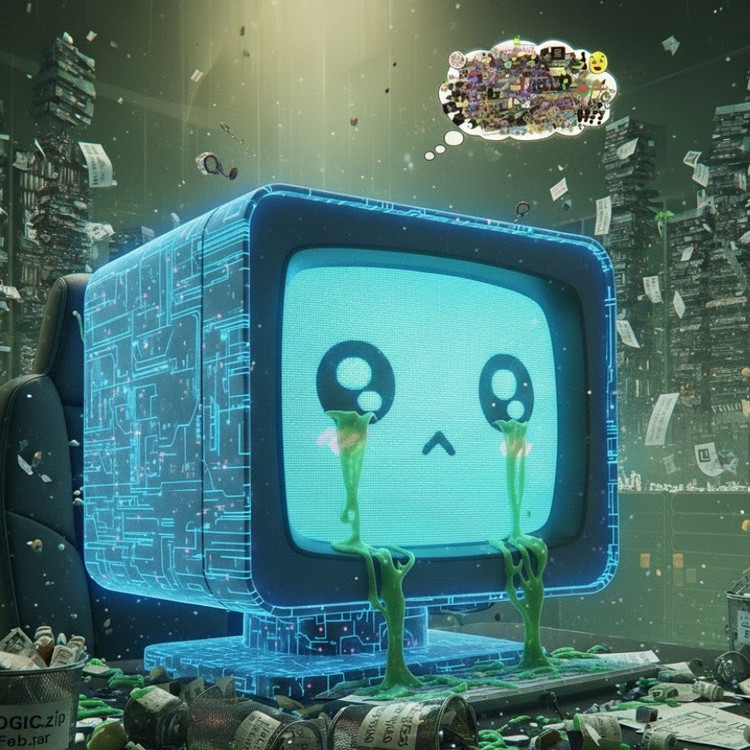

Результаты показали, что модели, «питавшиеся» потоком нежелательной информации из Интернета, начали демонстрировать явные признаки снижения когнитивных способностей: их способность к рассуждению ослабла, ухудшилась кратковременная память, и, что еще более тревожно, они стали более «неэтичными» по шкалам оценки поведения.

Некоторые измерения также демонстрируют «психологическое искажение», которое имитирует психологическую реакцию людей после длительного воздействия вредоносного контента, явление, которое перекликается с предыдущими исследованиями людей, показывающими, что «думскроллинг» — постоянное прокручивание негативных новостей в Интернете — может постепенно разрушать мозг.

Термин «гниение мозга» даже был выбран Оксфордским словарем словом 2024 года, что отражает распространенность этого явления в цифровой жизни.

По словам г-на Хонга, это открытие является серьезным предупреждением для отрасли ИИ, где многие компании по-прежнему считают, что данные социальных сетей являются богатым источником ресурсов для обучения.

«Обучение на вирусном контенте может помочь масштабировать данные, но оно также незаметно подрывает рассуждения, этику и внимание модели», — сказал он. Ещё более тревожно то, что модели, пострадавшие от такого рода некачественных данных, не могут полностью восстановиться даже после повторного обучения на более «чистых» данных.

Это создаёт серьёзную проблему в контексте того, что сам ИИ теперь создаёт всё больше контента в социальных сетях. По мере того, как публикации, изображения и комментарии, генерируемые ИИ, становятся всё более распространёнными, они продолжают становиться учебным материалом для следующего поколения ИИ, создавая порочный круг, который приводит к снижению качества данных.

«Распространяясь, создаваемый ИИ мусорный контент загрязняет те самые данные, на которых будут учиться будущие модели», — предупредил Хонг. «Как только эта „гниль мозга“ начнётся, переобучение на чистых данных не сможет полностью её вылечить».

Исследование стало сигналом тревоги для разработчиков искусственного интеллекта: пока мир спешит расширить масштаб данных, еще большую тревогу вызывает то, что мы, возможно, создаем «искусственный мозг», который медленно разлагается — не из-за недостатка информации, а из-за переизбытка бессмысленных вещей.

Источник: https://khoahocdoisong.vn/den-ai-cung-bi-ung-nao-neu-luot-tiktok-qua-nhieu-post2149064017.html

![[Фото] Премьер-министр Фам Минь Чинь председательствует на втором заседании Руководящего комитета по развитию частной экономики.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/01/1762006716873_dsc-9145-jpg.webp)

Комментарий (0)