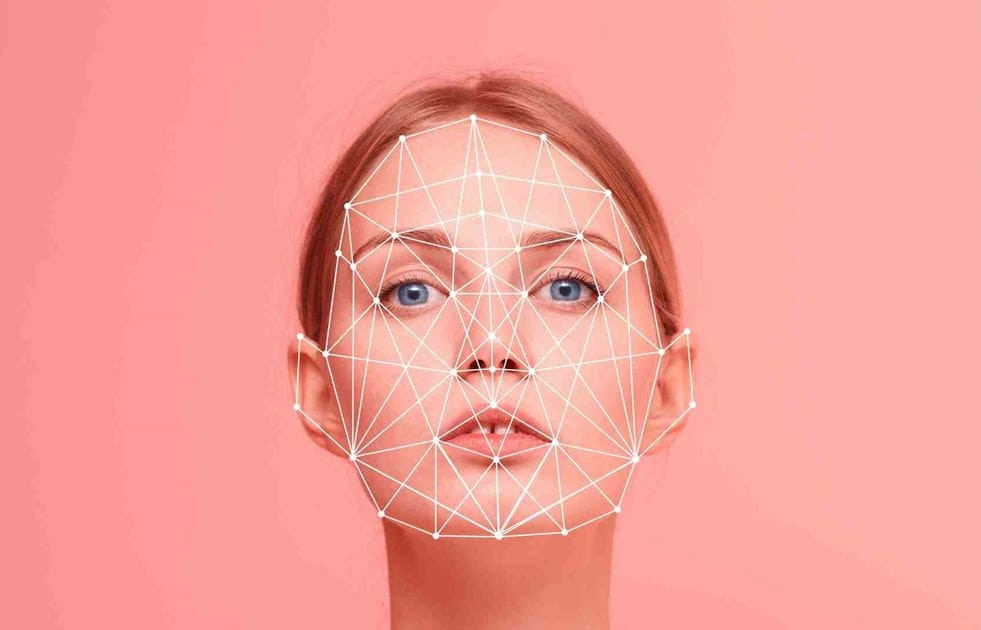

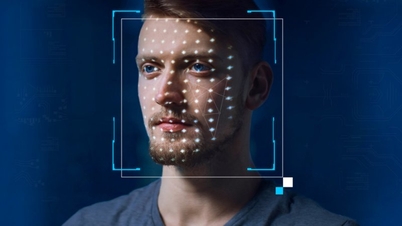

Дипфейк (Deepfake) — это термин, образованный путём слияния слов «глубокое обучение» (Deep Learning) и «фейк» (Fake). Проще говоря, это технология имитации и создания поддельных аудио-, графических и даже видеоматериалов .

С бурным развитием искусственного интеллекта (ИИ) проблема дипфейков стала всё более актуальной, порождая волны ложной информации в прессе. Поэтому проактивная аутентификация происхождения изображений и видео является актуальной задачей для ведущих мировых производителей фотоаппаратов.

Ожидается, что Sony, Canon и Nikon выпустят цифровые камеры, поддерживающие цифровую подпись непосредственно на своих беззеркальных (или цифровых зеркальных) камерах. Внедрение цифровой подписи на камерах — чрезвычайно важная мера, позволяющая подтвердить происхождение и целостность изображений.

Эти цифровые подписи будут включать информацию о дате, времени, месте и фотографе и будут защищены от несанкционированного доступа. Это особенно важно для фотожурналистов и других специалистов, чья работа требует аутентификации.

Три гиганта индустрии фотоаппаратов согласовали глобальный стандарт цифровых подписей, совместимый с онлайн-инструментом верификации Verify. Этот инструмент, запущенный коалицией международных новостных агентств, технологических компаний и производителей фотоаппаратов, позволит бесплатно проверить подлинность любого изображения. Если изображения созданы или изменены с использованием искусственного интеллекта, Verify пометит их как «Не требуется проверка содержимого».

Важность технологий борьбы с дипфейками обусловлена быстрым ростом числа дипфейков известных личностей, таких как бывший президент США Дональд Трамп и премьер-министр Японии Фумио Кисида.

Кроме того, исследователи из Университета Цинхуа в Китае разработали новую генеративную модель ИИ, способную генерировать около 700 000 изображений в день.

Помимо производителей камер, к борьбе с дипфейками присоединяются и другие технологические компании. Google выпустила инструмент для добавления цифровых водяных знаков на изображения, созданные с помощью искусственного интеллекта, а Intel разработала технологию, анализирующую изменения тона кожи на фотографиях для определения их подлинности. Hitachi также работает над технологией предотвращения мошенничества с использованием онлайн-личностей.

Ожидается, что новая технология станет доступна в начале 2024 года. Sony планирует продвигать технологию в средствах массовой информации и уже провела полевые испытания в октябре 2023 года. Canon сотрудничает с Thomson Reuters и Starling Data Preservation Lab (исследовательским институтом, основанным Стэнфордским университетом и Университетом Южной Калифорнии) для дальнейшего совершенствования технологии.

Производители камер надеются, что новая технология поможет восстановить общественное доверие к изображениям, которые, в свою очередь, формируют наше восприятие мира.

(по данным OL)

Заплатил 5000 долларов Facebook за распространение фейкового видео о мошенничестве с инвестициями

Новое вредоносное ПО захватывает контроль над смартфонами, а фейковые видеоролики становятся все более изощренными

Видео с дипфейками становятся все более изощренными и реалистичными

Что делать, чтобы не попасть в ловушку фейковых видеозвонков, мошеннических денежных переводов?

Дипфейк используется для помещения лиц жертв в порновидео

Источник

![[Фото] Премьер-министр Фам Минь Чинь председательствует на втором заседании Руководящего комитета по развитию частной экономики.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/01/1762006716873_dsc-9145-jpg.webp)

Комментарий (0)