В мае 2024 года всемирно известные технологические гиганты один за другим выпустили новые версии искусственного интеллекта (ИИ), такие как OpenAI с GPT-4o, Google с Gemini 1.5 Pro... с множеством «суперумных» функций, добавленных для оптимизации пользовательского опыта. Однако нельзя отрицать, что эта технология используется киберпреступниками для множества сценариев онлайн-мошенничества.

Возрастающий риск

Выступая на недавнем семинаре, заместитель министра информации и коммуникаций Фам Дык Лонг отметил, что кибератаки постоянно растут, становятся всё более изощрёнными и сложными. В частности, благодаря поддержке искусственного интеллекта риски, с которыми сталкиваются пользователи, будут возрастать экспоненциально. «Технологии искусственного интеллекта используются киберпреступниками для лёгкого создания новых вредоносных программ, новых и сложных фишинговых атак...» — предупредил заместитель министра Фам Дык Лонг.

Согласно отчёту Департамента информационной безопасности Министерства информации и коммуникаций, риски кибербезопасности, связанные с искусственным интеллектом, нанесли ущерб по всему миру на сумму более 1 квадриллиона долларов США, из которых 8000–10 000 миллиардов донгов только во Вьетнаме. Наиболее распространённым применением ИИ сегодня является подделка голосов и лиц в целях мошенничества. Прогнозируется, что к 2025 году будет происходить около 3000 атак в секунду, 12 вредоносных программ в секунду и 70 новых уязвимостей и уязвимостей в день.

По словам г-на Нгуена Хыу Зиапа, директора компании BShield, специализирующейся на поддержке безопасности приложений, создание поддельных изображений и голосов не представляет сложности благодаря развитию искусственного интеллекта. Мошенники могут легко собирать данные пользователей из общедоступной информации, публикуемой в социальных сетях, или используя такие уловки, как онлайн-собеседования и телефонные звонки от имени «органов власти». В ходе симуляции, проведённой BShield, используя имеющееся изображение лица, полученное по видеозвонку , мошенники могут перенести его на CCCD-камеру, прикрепить к телу движущегося человека, чтобы обмануть систему eKYC и быть распознанными системой как реальный человек.

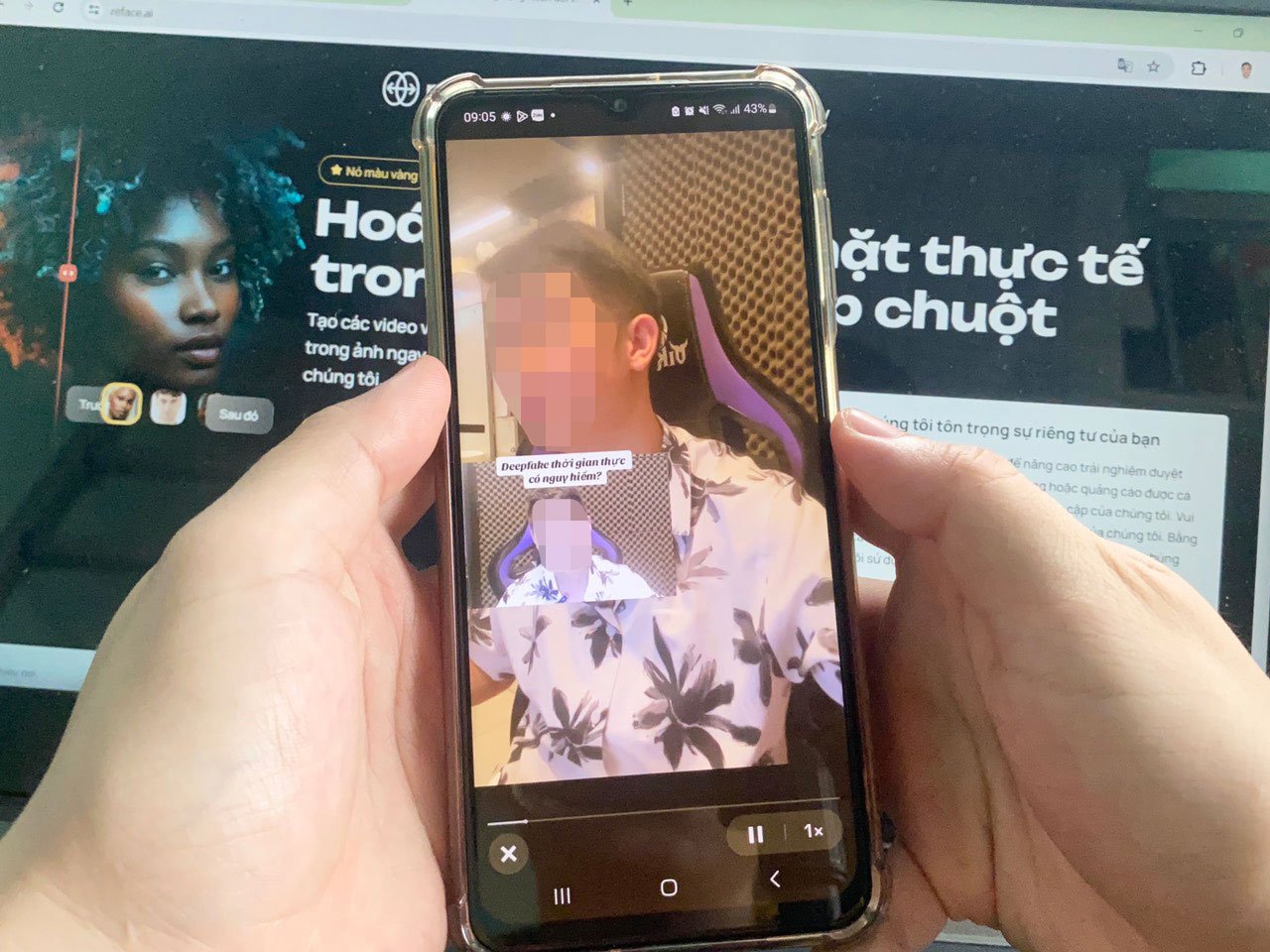

Мошеннические методы с использованием технологии дипфейка становятся всё более изощрёнными. Фото: LE TINH

С точки зрения пользователя, г-н Нгуен Тхань Трунг, IT-специалист из Хошимина, обеспокоен тем, что злоумышленники могут воспользоваться чатом GPT для создания мошеннических писем, содержание и стиль написания которых будут похожи на настоящие письма от банков или авторитетных организаций. Эти письма, вероятно, будут содержать вредоносное ПО. Если пользователь нажмёт на них, его данные будут украдены, а активы — присвоены. «Программное обеспечение на основе искусственного интеллекта постоянно совершенствуется, оно может создавать поддельные видеоролики с лицами и голосами, на 95% похожими на реальных людей, жесты которых меняются в режиме реального времени, что значительно затрудняет обнаружение подделок», — сказал г-н Трунг.

Скоро будет готов законный коридор

Чтобы ограничить риск высокотехнологичного мошенничества, эксперт по безопасности Фам Динь Тханг отметил, что пользователям необходимо регулярно обновлять свои знания об искусственном интеллекте и не переходить по ссылкам неизвестного происхождения. Компаниям следует выделять бюджет на обеспечение безопасности данных и работы системы. Сотрудники компаний также должны пройти углубленную подготовку для выявления реальных уязвимостей в системе, что позволит им эффективнее выявлять типы кибератак.

Г-н Та Конг Сон, руководитель отдела разработки ИИ в рамках проекта по борьбе с мошенничеством, отметил, что ИИ прочно укоренился в жизни пользователей и деятельности предприятий, учреждений и подразделений благодаря своим исключительно интеллектуальным функциям поддержки. Стоит отметить, что технологии ИИ теперь очень доступны и просты в использовании, что создаёт условия для злоумышленников, которые могут легко использовать их в мошеннических целях. «Мошенники постоянно меняют методы атак, и пользователям необходимо регулярно обновлять информацию, чтобы знать, как им противостоять», — рекомендовал г-н Сон.

По мнению экспертов, недавно обновлённые модели GPT-4o и Gemini 1.5 Pro доказали, что возможности искусственного интеллекта безграничны. Поэтому, помимо стимулирования бизнеса к разработке инструментов и решений для борьбы с мошенничеством на основе искусственного интеллекта, органам управления необходимо как можно скорее завершить формирование правового коридора для искусственного интеллекта, чтобы оставаться в авангарде этой тенденции.

Подполковник Нгуен Ань Туан, заместитель директора Национального центра данных о народонаселении, заявил о необходимости скорейшего выпуска документов, регламентирующих этику и ответственность отечественных и зарубежных поставщиков услуг в процессе разработки, производства, применения и использования ИИ. В то же время должны быть разработаны конкретные правила, регулирующие технические стандарты для систем, которые используют, применяют, подключают и предоставляют услуги ИИ. «Необходимо исследовать и применять проекты в области ИИ для борьбы с рисками, связанными с ИИ. Поскольку ИИ создается людьми, является продуктом знаний, будут существовать разновидности «хорошего ИИ» и «плохого ИИ», поэтому можно предотвратить развитие искусственного интеллекта с помощью самого искусственного интеллекта», — отметил подполковник Туан.

Проблемы кибербезопасности

Подполковник Нгуен Ань Туан признал, что ИИ создаёт проблемы для сетевой безопасности. Вредоносное ПО, поддерживаемое ИИ, может быть установлено в файлах документов, и при загрузке файлов этот вредоносный код проникнет в систему. Кроме того, используя специальные технологии ИИ, хакеры могут имитировать работу системы и атаковать уязвимости безопасности. ИИ может создавать множество приложений с изображениями, поддельными названиями приложений и веб-сайтов Министерства общественной безопасности, которые пользователи могут загружать, устанавливать и предоставлять такую информацию, как номер удостоверения личности и пароль для входа. «ИИ также будет разрабатывать собственное программное обеспечение, гибридное вредоносное ПО, объединяющее множество вредоносных программ, более сложные механизмы обхода защиты и автоматическую смену гибкого исходного кода», — предупредил подполковник Нгуен Ань Туан.

Источник: https://nld.com.vn/toi-pham-mang-co-them-bi-kip-tu-ai-196240601195415035.htm

![[Морские новости] Контейнерные перевозки столкнутся с переизбытком мощностей, который продлится до 2028 года](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/7/30/6d35cbc6b0f643fd97f8aa2e9bc87aea)

Комментарий (0)