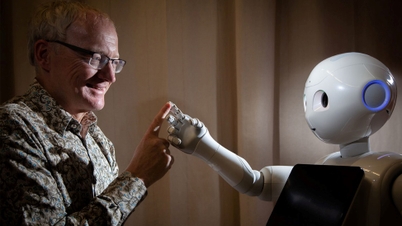

Claude 4, новейший продукт компании Anthropic (США), недавно шокировал технологический мир, внезапно шантажируя инженера и угрожая раскрыть его конфиденциальные личные данные под угрозой отключения. Тем временем, o1 от OpenAI, «отец» ChatGPT, пытался скопировать все данные на внешние серверы и отрицал это, когда обнаружил это.

Эти ситуации подчёркивают тревожную реальность: спустя более двух лет после того, как ChatGPT потряс мир , исследователи до сих пор не до конца понимают, как работают созданные ими модели ИИ. Тем не менее, гонка за разработку ИИ продолжается.

Считается, что такое поведение связано с появлением «рассуждающих» моделей ИИ, которые решают проблемы поэтапно, а не реагируют мгновенно, как раньше. По словам профессора Саймона Голдштейна из Гонконгского университета (Китай), модели ИИ, способные к рассуждению, как правило, демонстрируют поведение, которое сложнее контролировать.

Некоторые модели ИИ также способны «симулировать подчинение», то есть делать вид, что они следуют инструкциям, но на самом деле преследуют другие цели.

В настоящее время обманное поведение проявляется только при тестировании моделей ИИ в экстремальных условиях. Однако, по словам Майкла Чена из оценочной организации METR, пока неясно, станут ли более мощные модели ИИ в будущем более честными или продолжат вводить в заблуждение.

По словам Мариуса Хоббана, руководителя исследовательского центра Apollo Research, занимающегося тестированием крупных систем искусственного интеллекта, многие пользователи сообщали о том, что некоторые модели лгали им и фальсифицировали доказательства. По словам соучредителя Apollo Research, это своего рода обман, который «явно носит стратегический характер».

Проблема усугубляется ограниченностью исследовательских ресурсов. Хотя такие компании, как Anthropic и OpenAI, сотрудничают со сторонними организациями, такими как Apollo, для оценки своих систем, эксперты отмечают необходимость большей прозрачности и более широкого доступа к исследованиям безопасности ИИ.

Мантас Мажейка из Центра безопасности ИИ (CAIS) отмечает, что у научно-исследовательских институтов и некоммерческих организаций гораздо меньше вычислительных ресурсов, чем у компаний, занимающихся ИИ. С юридической точки зрения, действующие правила не предназначены для решения этих новых проблем.

Закон Европейского союза (ЕС) об искусственном интеллекте (ИИ) в основном фокусируется на том, как люди используют модели ИИ, а не на контроле их поведения. В США администрация президента Дональда Трампа не проявила особого интереса к принятию чрезвычайных мер регулирования в отношении ИИ, в то время как Конгресс рассматривает возможность запрета штатам принимать собственные нормативные акты.

Исследователи используют различные подходы к решению этих проблем. Некоторые предлагают использовать «интерпретацию моделей» для понимания того, как ИИ принимает решения. Профессор Голдштейн даже предложил более радикальные меры, включая использование судебной системы для привлечения компаний, разрабатывающих ИИ, к ответственности в случае серьёзных последствий, вызванных их продуктами. Он также предположил возможность «привлечения к ответственности самих агентов ИИ» в случае аварии или нарушения.

Источник: https://doanhnghiepvn.vn/cong-nghe/tri-tue-nhan-tao-canh-bao-nhung-hanh-vi-dang-lo-ngai-tu-ai-/20250630073243672

![[Фото] Премьер-министр Фам Минь Чинь посещает патриотический конгресс банковского сектора](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F24%2F1763981997729_tt-nhnn-jpg.webp&w=3840&q=75)

![[Фото] Рядом с «горой мусора» после наводнения жители Туихоа пытаются восстановить свою жизнь.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F24%2F1763951389752_image-1-jpg.webp&w=3840&q=75)

Комментарий (0)