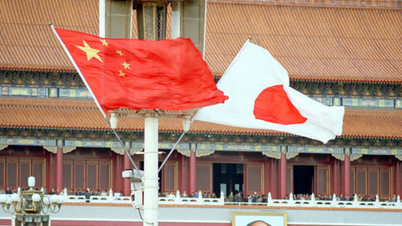

En grupp framstående internationella experter möttes i Peking förra veckan, där de identifierade "röda linjer" i AI-utveckling, inklusive skapandet av biologiska vapen och utförandet av cyberattacker.

I ett uttalande bara dagar efter mötet varnade akademikerna för att en gemensam strategi för AI-säkerhet behövs för att förhindra "katastrofala eller till och med existentiella risker för mänskligheten under vår livstid".

”Under kalla krigets höjdpunkt bidrog internationellt regeringssamarbete och vetenskapligt samarbete till att förhindra en kärnkraftskatastrof. Mänskligheten måste återigen samarbeta för att förhindra den katastrof som kan uppstå till följd av exempellös teknologi”, stod det i uttalandet.

Experter vid den internationella dialogen om AI-säkerhet i Peking har identifierat "röda linjer" i AI-utvecklingen. Foto: FT

Bland undertecknarna finns Geoffrey Hinton och Yoshua Bengio, som ofta beskrivs som AI:s "fäder", Stuart Russell, professor i datavetenskap vid University of California, och Andrew Yao, en av Kinas mest framstående datavetare.

Uttalandet kommer efter den internationella AI-säkerhetsdialogen i Peking förra veckan, ett möte där kinesiska regeringstjänstemän deltog för att uttrycka sitt godkännande av forumet och dess resultat.

USA:s president Joe Biden och Kinas president Xi Jinping möttes i november förra året och diskuterade AI-säkerhet och kom överens om att inleda en dialog i frågan. Ledande globala AI-företag har också träffat kinesiska AI-experter privat de senaste månaderna.

I november 2023 enades 28 länder, inklusive Kina, och ledande AI-företag om ett brett åtagande att arbeta tillsammans för att hantera existentiella risker som härrör från avancerad AI under Storbritanniens finansminister Rishi Sunaks toppmöte om AI-säkerhet.

I Peking förra veckan diskuterade experter hot i samband med utvecklingen av ”artificiell generell intelligens – AGI”, eller AI-system som är likvärdiga med eller överlägsna människor.

"Diskussionens kärnfokus var de röda linjer som inget kraftfullt AI-system bör överskrida och som regeringar runt om i världen bör införa i utvecklingen och driftsättningen av AI", sa Bengio.

Dessa röda linjer skulle säkerställa att ”inget AI-system kan replikera eller förbättra sig självt utan uttryckligt mänskligt samtycke och stöd” eller ”vidta åtgärder som otillbörligt ökar dess makt och inflytande”.

Forskarna tillade att inget system skulle ”avsevärt förbättra aktörers förmåga att utforma massförstörelsevapen, bryta mot konventionen om biologiska eller kemiska vapen” eller kunna ”automatiskt utföra cyberattacker som resulterar i allvarlig ekonomisk förlust eller motsvarande skada”.

Hoang Hai (enligt FT)

[annons_2]

Källa

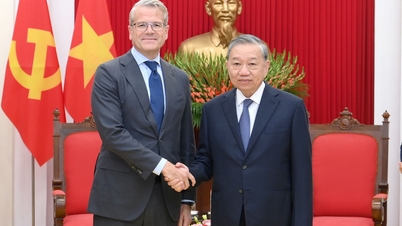

![[Foto] Generalsekreterare To Lam tar emot Slovakiens vice premiärminister och försvarsminister Robert Kalinak](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/18/1763467091441_a1-bnd-8261-6981-jpg.webp)

Kommentar (0)