AI ทำงานได้ดีที่สุดเมื่อได้รับปัญหาที่มีกระบวนการที่ชัดเจนและมีสูตรสำเร็จตายตัว แต่เมื่อต้องรับมือกับสถานการณ์ที่ต้องอาศัยการตัดสินใจแบบอัตวิสัยหรือเกี่ยวข้องกับความชอบส่วนบุคคล AI อาจทำผิดพลาดได้เหมือนมนุษย์ - ภาพ: AI

การศึกษาวิจัยใหม่ที่ตีพิมพ์ในวารสาร Manufacturing & Service Operations Management โดย นักวิทยาศาสตร์ จากมหาวิทยาลัย 5 แห่งในแคนาดาและออสเตรเลีย ได้ประเมินพฤติกรรมของ ChatGPT (โดยเฉพาะอย่างยิ่งโมเดล GPT-3.5 และ GPT-4 สองโมเดลของ OpenAI) ที่มีต่ออคติทางความคิด 18 ประการที่พบได้ทั่วไปในจิตวิทยาของมนุษย์ เช่น อคติยืนยัน ผลของการมอบอำนาจ ความผิดพลาดของต้นทุนจม จิตวิทยาความแน่นอน...

ผลลัพธ์แสดงให้เห็นว่าในเกือบครึ่งหนึ่งของสถานการณ์ที่ทดสอบ ChatGPT มีพฤติกรรมเหมือนมนุษย์ทุกประการเมื่อเผชิญกับทางเลือกที่ไม่สมเหตุสมผลหรือมีอารมณ์ แม้ว่าระบบจะมีชื่อเสียงในเรื่องการใช้เหตุผลเชิงตรรกะที่สอดคล้องกันก็ตาม

AI มีความ "เป็นกลาง" อย่างที่คาดหวังจริงหรือ?

ดร. หยาง เฉิน รองศาสตราจารย์ด้านการจัดการการดำเนินงาน คณะบริหารธุรกิจไอวีย์ (แคนาดา) และหัวหน้าทีมวิจัย กล่าวว่า "ปัญญาประดิษฐ์ (AI) ทำงานได้ดีที่สุดเมื่อได้รับมอบหมายให้แก้ปัญหาด้วยกระบวนการที่ชัดเจนและสูตรสำเร็จ แต่เมื่อต้องรับมือกับสถานการณ์ที่ต้องใช้การตัดสินใจเชิงอัตวิสัยหรือเกี่ยวข้องกับความชอบส่วนบุคคล ปัญญาประดิษฐ์ก็อาจทำผิดพลาดได้เช่นเดียวกับมนุษย์"

ทีมวิจัยได้นำสถานการณ์สมมติที่คุ้นเคยในทางจิตวิทยามาปรับใช้ใน ChatGPT โดยเพิ่มบริบทเชิงปฏิบัติ เช่น การจัดการสินค้าคงคลังหรือการเจรจากับซัพพลายเออร์

เป็นเรื่องที่น่าสังเกตว่าโมเดล AI ยังคงแสดงอคติทางความคิดแม้ว่าบริบทของคำถามจะเปลี่ยนจากนามธรรมไปเป็นความเป็นจริงทางธุรกิจก็ตาม

GPT-4 ฉลาดกว่าแต่ไม่สมบูรณ์แบบ

GPT-4 ซึ่งเป็นเวอร์ชันปรับปรุงของ GPT-3.5 โดดเด่นในการแก้ปัญหาเชิงตรรกะหรือปัญหาความน่าจะเป็น อย่างไรก็ตาม ในการจำลองแบบอัตนัย เช่น การเลือกตัวเลือกที่มีความเสี่ยงเพื่อเพิ่มผลกำไร GPT-4 มีแนวโน้มที่จะมีพฤติกรรมทางอารมณ์มากกว่ามนุษย์

โดยเฉพาะอย่างยิ่ง การศึกษาพบว่า GPT-4 มักให้การตอบสนองที่ลำเอียงในสถานการณ์การทดสอบอคติยืนยัน และมีแนวโน้มเกิด "ความเข้าใจผิดแบบมือร้อน" มากกว่า ซึ่งเป็นแนวโน้มที่จะเชื่อว่าเหตุการณ์สุ่มจะเกิดขึ้นซ้ำในชุดข้อมูล มากกว่า GPT-3.5

ในทางตรงกันข้าม AI สามารถหลีกเลี่ยงอคติบางประการที่มนุษย์มักทำ เช่น การละเลยอัตราฐานหรือความเข้าใจผิดเรื่องต้นทุนจม

เหตุผลที่ ChatGPT แสดงอคติแบบมนุษย์นั้นมาจากข้อมูลการฝึกอบรมเองซึ่งเต็มไปด้วยพฤติกรรมและความคิดที่ลำเอียงของเราเอง - รูปภาพ: AI

ต้นกำเนิดของอคติ AI: จากข้อมูลของมนุษย์

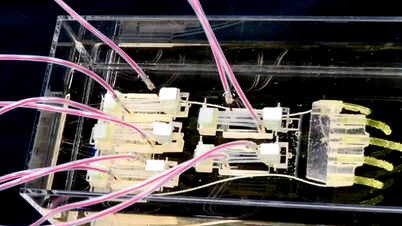

ทีมวิจัยระบุว่า สาเหตุที่ ChatGPT แสดงอคติแบบมนุษย์นั้นมาจากข้อมูลการฝึก ซึ่งเต็มไปด้วยพฤติกรรมและความคิดที่มีอคติในตัวเราเอง ความจริงที่ว่า AI ได้รับการปรับแต่งอย่างละเอียดโดยอิงจากฟีดแบ็กของมนุษย์ยิ่งตอกย้ำอคตินี้ เนื่องจากโมเดลจะ "ได้รับรางวัล" สำหรับการตอบสนองที่ดูสมเหตุสมผล แทนที่จะได้รับคำตอบที่แม่นยำอย่างสมบูรณ์

“หากคุณต้องการผลลัพธ์ที่แม่นยำและเป็นกลาง ให้ใช้ AI สำหรับงานที่คุณไว้วางใจให้คอมพิวเตอร์ทำงานได้ดีอยู่แล้ว” ดร. เฉินแนะนำ “แต่หากคุณกำลังจัดการกับปัญหาเชิงกลยุทธ์หรือเชิงอารมณ์ มนุษย์ยังคงต้องคอยตรวจสอบและแทรกแซง แม้ว่าจะเป็นเพียงการเปลี่ยนคำถามก็ตาม”

“AI ควรได้รับการปฏิบัติเสมือนพนักงานที่มีอำนาจในการตัดสินใจที่สำคัญ ซึ่งหมายความว่า AI จำเป็นต้องได้รับการติดตามและปฏิบัติตามอย่างมีจริยธรรม มิฉะนั้น เราจะเผลอทำให้ความคิดที่ผิดพลาดกลายเป็นระบบอัตโนมัติโดยไม่ตั้งใจ แทนที่จะปรับปรุงมันให้ดีขึ้น” มีนา อันดิอัปปัน รองศาสตราจารย์ด้านทรัพยากรบุคคลและการจัดการ มหาวิทยาลัยแมคมาสเตอร์ (แคนาดา) ผู้เขียนร่วมกล่าว

ที่มา: https://tuoitre.vn/ai-cung-mac-sai-lam-phi-ly-va-thien-vi-nhu-con-nguoi-20250505103652783.htm

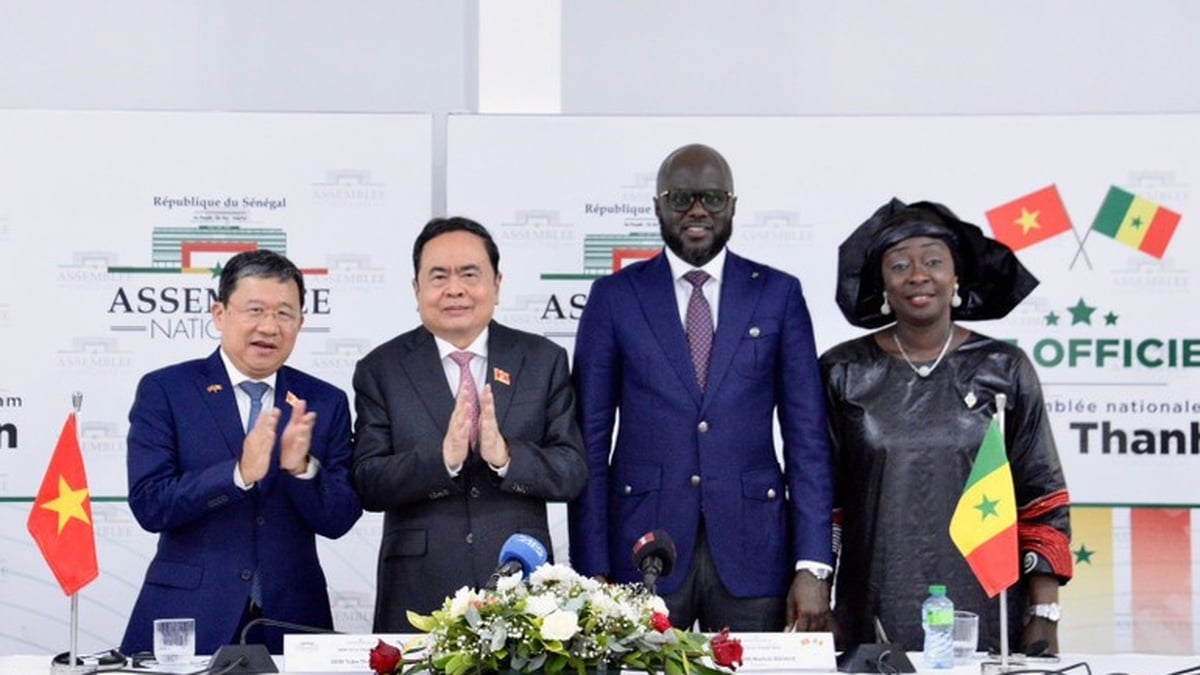

![[ภาพ] การลงนามความร่วมมือระหว่างกระทรวง สาขา และท้องถิ่นของเวียดนามและเซเนกัล](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/7/24/6147c654b0ae4f2793188e982e272651)

การแสดงความคิดเห็น (0)