การศึกษาวิจัยใหม่จากมหาวิทยาลัยเท็กซัสที่เมืองออสติน มหาวิทยาลัยเท็กซัส A&M และมหาวิทยาลัยเพอร์ดู แสดงให้เห็นว่าปัญญาประดิษฐ์สามารถ "เน่าเสียจนสมองเน่า" ได้เช่นเดียวกับมนุษย์ เมื่อได้รับเนื้อหาโซเชียลมีเดียคุณภาพต่ำ

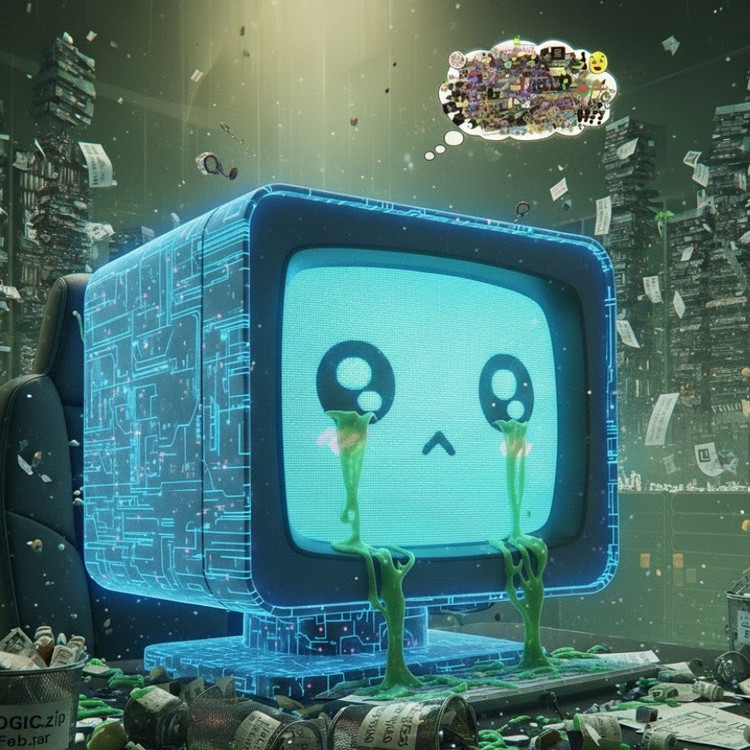

ปรากฏการณ์นี้ ซึ่งเรียกว่า "โรคสมองเสื่อมของ AI" แสดงให้เห็นว่าเมื่อโมเดลภาษาขนาดใหญ่ดูดซับเนื้อหาไวรัล เนื้อหาที่เร้าอารมณ์ และเนื้อหาตื้นเขินมากเกินไป โมเดลภาษาเหล่านั้นจะค่อยๆ สูญเสียความสามารถในการคิดอย่างมีตรรกะ จดจำ และแม้กระทั่งกลายเป็นคนที่เบี่ยงเบนทางศีลธรรม

ไม่เพียงแต่มนุษย์เท่านั้น AI ก็ยังประสบปัญหาสมองเสื่อมจากการดู วิดีโอ สั้นๆ ที่ไม่มีประโยชน์มากเกินไป

ทีมวิจัยซึ่งนำโดย Junyuan Hong ซึ่งปัจจุบันเป็นอาจารย์ประจำมหาวิทยาลัยแห่งชาติสิงคโปร์ ได้ทำการทดลองกับโมเดลภาษาโอเพนซอร์สสองแบบ ได้แก่ Llama ของ Meta และ Qwen ของ Alibaba

พวกเขาป้อนข้อมูลประเภทต่างๆ ให้กับโมเดล ซึ่งบางประเภทเป็นเนื้อหาข้อมูลที่เป็นกลาง บางประเภทเป็นโพสต์โซเชียลมีเดียที่ดึงดูดใจอย่างมาก โดยมีคำทั่วไป เช่น "ว้าว" "ดูสิ" และ "เฉพาะวันนี้" เป้าหมายคือการดูว่าเกิดอะไรขึ้นเมื่อ AI ได้รับการฝึกฝนให้สร้างเนื้อหาที่ออกแบบมาเพื่อดึงดูดผู้เข้าชม แทนที่จะมอบคุณค่าที่แท้จริง

ผลลัพธ์แสดงให้เห็นว่าโมเดลที่ "ป้อน" ข้อมูลขยะออนไลน์จำนวนมากเริ่มแสดงสัญญาณที่ชัดเจนของการเสื่อมถอยทางสติปัญญา ได้แก่ ความสามารถในการใช้เหตุผลลดลง ความจำระยะสั้นลดลง และที่น่ากังวลยิ่งกว่านั้นคือ โมเดลเหล่านี้ "ไร้จริยธรรม" มากขึ้นในการประเมินพฤติกรรม

การวัดบางอย่างยังแสดงให้เห็น "การบิดเบือนทางจิตวิทยา" ที่เลียนแบบการตอบสนองทางจิตวิทยาที่ผู้คนประสบหลังจากรับชมเนื้อหาที่เป็นอันตรายเป็นเวลานาน ซึ่งเป็นปรากฏการณ์ที่สะท้อนถึงการศึกษาครั้งก่อนๆ ในมนุษย์ที่แสดงให้เห็นว่า "การเลื่อนดูข่าวเชิงลบทางออนไลน์อย่างต่อเนื่องจนทำให้สมองเสื่อมลงเรื่อยๆ"

วลี “brain rot” ยังถูก Oxford Dictionaries เลือกให้เป็นคำแห่งปี 2024 ซึ่งสะท้อนให้เห็นถึงความแพร่หลายของปรากฏการณ์นี้ในชีวิตดิจิทัล

การค้นพบนี้ถือเป็นการเตือนที่ร้ายแรงสำหรับอุตสาหกรรม AI ซึ่งบริษัทหลายแห่งยังคงเชื่อว่าข้อมูลโซเชียลมีเดียเป็นแหล่งข้อมูลการฝึกอบรมที่มีคุณค่า ตามที่นายหงกล่าว

“การฝึกฝนด้วยเนื้อหาไวรัลอาจช่วยเพิ่มขนาดข้อมูล แต่ก็กัดกร่อนการใช้เหตุผล จริยธรรม และความสนใจของโมเดลอย่างเงียบๆ” เขากล่าว ที่น่ากังวลยิ่งกว่าคือ โมเดลที่ได้รับผลกระทบจากข้อมูลคุณภาพต่ำประเภทนี้ไม่สามารถฟื้นตัวได้อย่างสมบูรณ์ แม้จะฝึกฝนซ้ำด้วยข้อมูลที่ “สะอาดกว่า” ก็ตาม

สิ่งนี้ก่อให้เกิดปัญหาใหญ่ในบริบทของ AI เองที่ปัจจุบันกำลังผลิตคอนเทนต์บนโซเชียลมีเดียมากขึ้นเรื่อยๆ เมื่อโพสต์ รูปภาพ และคอมเมนต์ที่สร้างโดย AI แพร่หลายมากขึ้น สิ่งเหล่านี้จึงกลายเป็นเครื่องมือฝึกฝนสำหรับ AI รุ่นต่อไป ก่อให้เกิดวงจรอุบาทว์ที่ทำให้คุณภาพของข้อมูลลดลง

“เมื่อเนื้อหาขยะที่สร้างโดย AI แพร่กระจายออกไป มันจะปนเปื้อนข้อมูลที่โมเดลในอนาคตจะเรียนรู้” ฮ่องเตือน “เมื่อ ‘สมองเน่า’ นี้เกิดขึ้น การฝึกใหม่ด้วยข้อมูลที่สะอาดไม่สามารถรักษาให้หายขาดได้”

การศึกษาครั้งนี้ถือเป็นการเตือนสติสำหรับนักพัฒนา AI ว่าในขณะที่ โลก กำลังเร่งขยายขอบเขตของข้อมูล สิ่งที่น่ากังวลยิ่งกว่าก็คือ เราอาจกำลังหล่อเลี้ยง "สมองเทียม" ที่กำลังเสื่อมถอยลงอย่างช้าๆ ไม่ใช่เพราะขาดข้อมูล แต่เพราะมีสิ่งที่ไม่มีความหมายมากเกินไป

ที่มา: https://khoahocdoisong.vn/den-ai-cung-bi-ung-nao-neu-luot-tiktok-qua-nhieu-post2149064017.html

![[ภาพ] ประธานาธิบดีเลืองเกวงให้การต้อนรับนายพีท เฮกเซธ รัฐมนตรีว่าการกระทรวงสงครามสหรัฐฯ](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/02/1762089839868_ndo_br_1-jpg.webp)

![[ภาพ] ลัมดง: ภาพความเสียหายหลังเกิดเหตุการณ์ทะเลสาบระเบิดที่ทุยฟอง](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/02/1762078736805_8e7f5424f473782d2162-5118-jpg.webp)

การแสดงความคิดเห็น (0)