Законодавці продовжать обговорення детальних правил найближчими тижнями, щоб остаточний процес можна було завершити на початку наступного року, який, як очікується, набуде чинності з 2026 року.

До того часу компаніям рекомендується приєднатися до добровільного Пакту про штучний інтелект для виконання ключових зобов'язань, передбачених правилами.

Нижче наведено основний зміст угоди, узгодженої ЄС.

Система високого ризику

Так звані системи штучного інтелекту високого ризику – ті, що вважаються такими, що можуть завдати значної шкоди здоров’ю, безпеці, основним правам, довкіллю, демократії, виборам та верховенству права – повинні будуть відповідати низці вимог, таких як проходження випробувань, що оцінюють вплив на основні права та зобов’язання ЄС щодо доступу до ринку.

Тим часом системи з низьким рівнем ризику підлягатимуть меншим зобов'язанням щодо прозорості, таким як маркування контенту, створеного штучним інтелектом, щоб користувачі могли розглянути можливість його використання.

Штучний інтелект у правоохоронних органах

Правоохоронним органам дозволено використовувати системи дистанційної біометричної ідентифікації в режимі реального часу лише в громадських місцях для ідентифікації жертв викрадення людей, торгівлі людьми, сексуальної експлуатації та запобігання конкретним і неминучим терористичним загрозам.

Владі також буде дозволено використовувати технології штучного інтелекту для відстеження підозрюваних у тероризмі, торгівлі людьми, сексуальній експлуатації, вбивствах, викраденнях людей, зґвалтуванні, збройному пограбуванні, участі у злочинній організації та екологічних злочинах.

Загальні та платформні системи штучного інтелекту (GPAI)

GPAI та базові моделі підлягатимуть вимогам прозорості, таким як створення технічної документації, дотримання законодавства ЄС про авторське право та публікація детальних описів контенту, що використовується для навчання алгоритмів.

Моделі платформ, що належать до категорії потенційно створюють системний ризик та мають високий вплив на GPAI, повинні будуть проводити загальну оцінку моделі, переглядати та пом'якшувати ризики, проводити зворотне проектування, повідомляти Європейську Комісію про серйозні інциденти, забезпечувати кібербезпеку та звітувати про споживання енергії.

До публікації гармонізованих стандартів ЄС, GPAI перебувають під системним ризиком покладання на кодекси практики для дотримання нормативних актів.

Системи штучного інтелекту заборонені

Заборонена поведінка та контент включають: біометричні системи класифікації, що використовують конфіденційні характеристики, такі як політичні , релігійні, філософські переконання, сексуальна орієнтація та раса;

Нецільове сканування зображень обличчя з Інтернету або записів з камер відеоспостереження для створення бази даних розпізнавання облич;

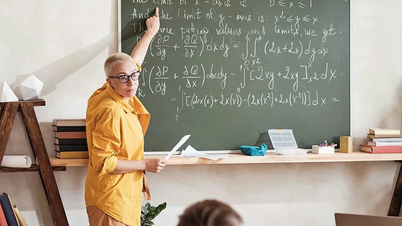

Розпізнавання емоцій на робочому місці та в освітньому середовищі;

Соціальний скоринг базується на соціальній поведінці або особистих рисах;

Системи штучного інтелекту маніпулюють поведінкою людей, щоб підірвати їхню вільну волю;

Штучний інтелект використовується для використання людських слабкостей, спричинених їхнім віком, інвалідністю, економічними чи соціальними обставинами.

Санкції

Залежно від порушення та розміру компанії, штрафи починатимуться від 7,5 мільйонів євро (8 мільйонів доларів США) або 1,5% від річного світового обороту та зростатимуть до 35 мільйонів євро або 7% від світового обороту.

(За даними Reuters)

ЄС досяг історичної угоди щодо регулювання штучного інтелекту

ЄС досяг угоди щодо Закону про захист смарт-пристроїв

ЄС жорсткіше ставиться до технологічних гігантів, погрожуючи ліквідувати компанії-порушники

Джерело

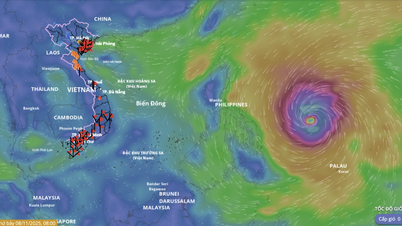

![[Фото] «Кладовище кораблів» у затоці Суань Дай](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/08/1762577162805_ndo_br_tb5-jpg.webp)

![[Фото] Значні руйнування після шторму № 13 у районі Сонгкау, провінція Даклак](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/08/1762574759594_img-0541-7441-jpg.webp)

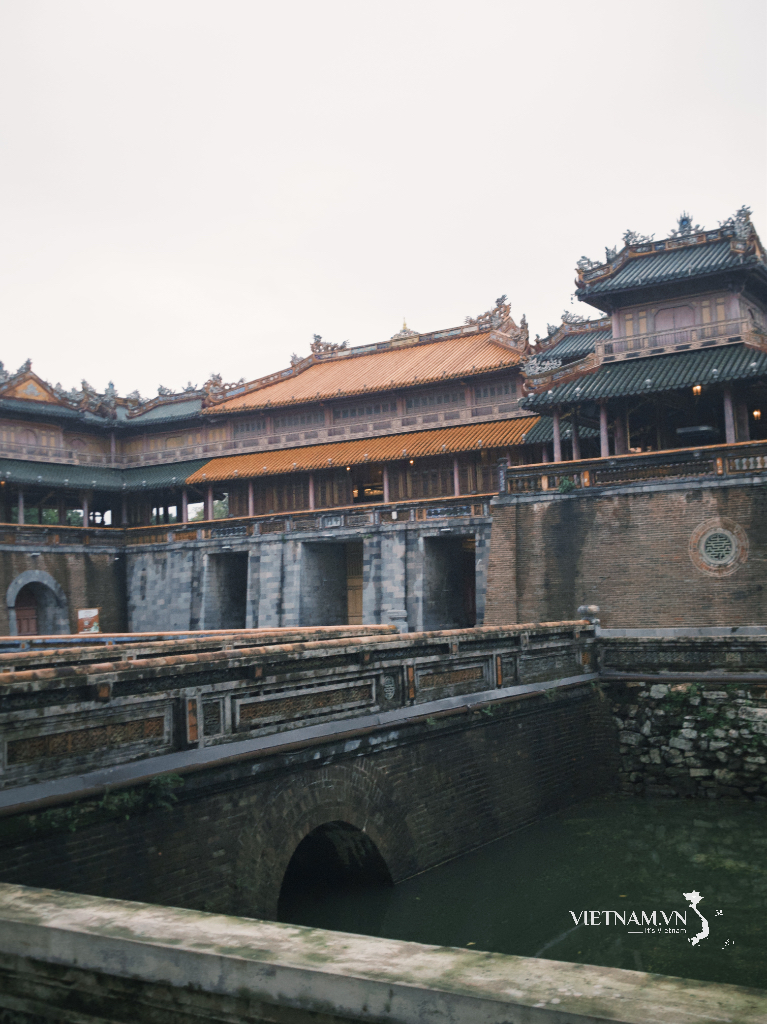

![[Відео] Пам'ятники Хюе знову відкриваються для відвідувачів](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/05/1762301089171_dung01-05-43-09still013-jpg.webp)

Коментар (0)