مصنوعی ذہانت لوگوں کو ای میلز لکھنے، فلموں کی سفارش کرنے، ڈیٹا کا تجزیہ کرنے اور بیماریوں کی تشخیص میں مدد کر رہی ہے...

لیکن جیسے جیسے AI ہوشیار ہوتا جاتا ہے، اسی طرح اس سے عدم تحفظ کا احساس بھی پیدا ہوتا ہے۔ اس کا ایک حصہ یہ ہے کہ ہم اس ٹیکنالوجی کو پوری طرح سے نہیں سمجھتے جو ہم استعمال کر رہے ہیں۔ باقی ہماری اپنی نفسیاتی جبلتوں سے پیدا ہوتا ہے۔

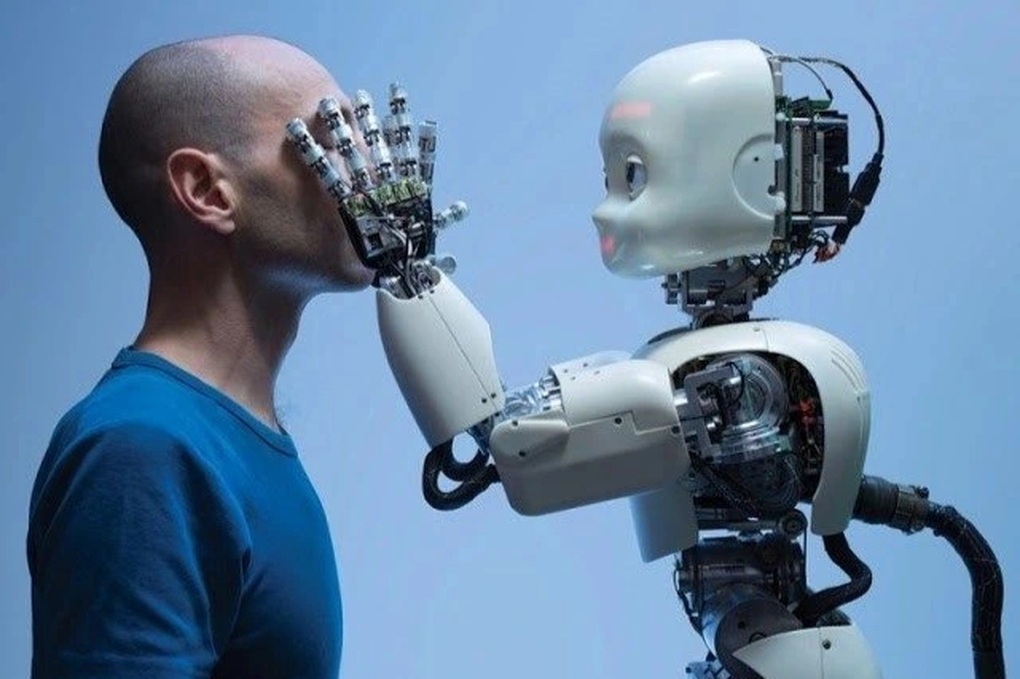

AI انسانی نفسیاتی موافقت سے زیادہ تیزی سے ترقی کر رہا ہے (تصویر تصویر)۔

جب AI ایک "بلیک باکس" بن جاتا ہے اور صارفین کنٹرول کھو دیتے ہیں۔

لوگ اس پر بھروسہ کرتے ہیں جو وہ سمجھتے ہیں اور کنٹرول کرتے ہیں۔ جب آپ بٹن دباتے ہیں تو لفٹ حرکت کرتی ہے۔ جب آپ سوئچ پلٹتے ہیں تو لائٹ جل جاتی ہے۔ واضح جوابات تحفظ کا احساس پیدا کرتے ہیں۔

اس کے برعکس، بہت سے AI سسٹم بند باکس کی طرح کام کرتے ہیں۔ آپ ڈیٹا داخل کرتے ہیں، لیکن یہ جس طرح سے نتائج پیدا کرتا ہے وہ پوشیدہ ہے۔ اس سے صارفین کو سمجھنا یا استفسار کرنا ناممکن ہو جاتا ہے۔

دھندلاپن کا یہ احساس پریشان کن ہے۔ صارفین کو نہ صرف کام کرنے والے ٹول کی ضرورت ہے بلکہ یہ جاننے کی بھی ضرورت ہے کہ یہ کیوں کام کرتا ہے۔

اگر AI وضاحت فراہم کرنے میں ناکام رہتا ہے، تو لوگ اس سے سوال کرنا شروع کر دیتے ہیں۔ یہ ایک تصور کی طرف لے جاتا ہے جسے "الگورتھم ایورژن" کہا جاتا ہے، جسے رویے کے محققین اس رجحان کے طور پر بیان کرتے ہیں جہاں لوگ مشین کے فیصلے پر بھروسہ کرنے کے بجائے دوسروں کے فیصلوں کا انتخاب کرتے ہیں، چاہے وہ غلط ہی کیوں نہ ہوں۔

بہت سے لوگ AI کے بہت درست ہونے سے ڈرتے ہیں۔ مواد کی سفارش کرنے والا انجن اگر انہیں بہت اچھی طرح پڑھتا ہے تو پریشان کن ہوسکتا ہے۔ دیکھے جانے یا ہیرا پھیری کرنے کا احساس ابھرنا شروع ہو جاتا ہے، حالانکہ نظام خود کوئی جذبات یا ارادہ نہیں رکھتا۔

یہ ردعمل ایک فطری رویے سے پیدا ہوتا ہے: بشریت۔ اگرچہ ہم جانتے ہیں کہ AI انسان نہیں ہے، ہم پھر بھی اس کا جواب ایسے دیتے ہیں جیسے ہم کسی فرد کے ساتھ بات چیت کر رہے ہوں۔ جب AI بہت شائستہ یا بہت ٹھنڈا ہوتا ہے، تو صارفین عجیب اور بے اعتمادی محسوس کرتے ہیں۔

انسان انسانوں کو تو معاف کرتے ہیں مگر مشینوں کو نہیں۔

ایک دلچسپ تضاد یہ ہے کہ جب انسان غلطیاں کرتے ہیں، تو ہم ہمدرد اور قبول کر سکتے ہیں۔ لیکن جب غلطی AI سے آتی ہے، خاص طور پر جب اس کی تشہیر مقصد اور ڈیٹا پر مبنی کے طور پر کی جاتی ہے، تو صارفین اکثر دھوکہ دہی کا احساس کرتے ہیں۔

یہ توقع کی خلاف ورزیوں کے رجحان سے متعلق ہے۔ ہم توقع کرتے ہیں کہ مشینیں منطقی، درست اور درست ہوں گی۔ جب اس اعتماد کی خلاف ورزی کی جاتی ہے، تو نفسیاتی ردعمل اکثر زیادہ شدید ہوتا ہے۔ یہاں تک کہ الگورتھم میں ایک چھوٹی سی غلطی کو بھی سنگین سمجھا جا سکتا ہے اگر صارف اپنے قابو سے باہر یا غیر واضح محسوس کرے۔

ہمیں فطری طور پر غلطی کی وجہ کو سمجھنے کی ضرورت ہے۔ انسانوں کے ساتھ، ہم پوچھ سکتے ہیں کہ کیوں؟ AI کے ساتھ، جواب اکثر غیر موجود یا بہت مبہم ہوتا ہے۔

جب اساتذہ، مصنفین، وکلاء یا ڈیزائنرز AI کو اپنی ملازمتوں کا حصہ کرتے ہوئے دیکھتے ہیں، تو وہ نہ صرف اپنی ملازمتیں کھونے سے ڈرتے ہیں بلکہ اپنی صلاحیتوں اور ذاتی شناخت کی قدر کے بارے میں بھی فکر مند ہوتے ہیں۔

یہ ایک فطری ردعمل ہے، جسے شناخت کا خطرہ کہا جاتا ہے۔ یہ انکار، مزاحمت، یا نفسیاتی دفاع کا باعث بن سکتا ہے۔ ان صورتوں میں، شک اب جذباتی ردعمل نہیں بلکہ خود تحفظ کا طریقہ کار ہے۔

اعتماد صرف منطق سے نہیں آتا۔

انسان جذبات، اشاروں، آنکھ سے رابطہ اور ہمدردی کے ذریعے اعتماد کرتے ہیں۔ AI واضح، مزاحیہ بھی ہو سکتا ہے، لیکن یہ نہیں جانتا کہ حقیقی تعلق کیسے بنایا جائے۔

"غیر معمولی وادی" کے رجحان کو ماہرین نے ان چیزوں کے ساتھ سامنا کرنے کے غیر آرام دہ احساس کے طور پر بیان کیا ہے جو تقریبا انسانی ہیں، لیکن کسی چیز کی کمی ہے جو انہیں غیر حقیقی بناتی ہے.

جب مشینیں بہت زیادہ انسان بن جاتی ہیں، تو عدم تحفظ کا احساس اور بھی واضح ہو جاتا ہے (تصویر: گیٹی)۔

AI کے ساتھ، یہ جذبات کی عدم موجودگی ہے جس کی وجہ سے بہت سے لوگ مایوسی کا شکار ہو جاتے ہیں، یقین نہیں آتا کہ بھروسہ کرنا ہے یا شک کرنا۔

جعلی خبروں، جعلی ویڈیوز اور الگورتھمک فیصلوں سے بھری دنیا میں، جذباتی طور پر ترک کرنے کے احساسات لوگوں کو ٹیکنالوجی سے ہوشیار کرتے ہیں۔ اس لیے نہیں کہ AI کچھ غلط کرتا ہے، بلکہ اس لیے کہ ہم نہیں جانتے کہ اس کے بارے میں کیسا محسوس کرنا ہے۔

مزید یہ کہ، شک بعض اوقات محض ایک احساس سے زیادہ ہوتا ہے۔ الگورتھم نے پہلے سے ہی خدمات حاصل کرنے، مجرمانہ فیصلے، اور کریڈٹ کی منظوری میں تعصب پیدا کیا ہے۔ ان لوگوں کے لیے جنہیں مبہم ڈیٹا سسٹمز سے تکلیف ہوئی ہے، ہوشیار رہنا سمجھ میں آتا ہے۔

ماہرین نفسیات اسے سیکھے ہوئے عدم اعتماد کا نام دیتے ہیں۔ جب ایک نظام بار بار ناکام ہو جاتا ہے، تو یہ سمجھ میں آتا ہے کہ اعتماد ختم ہو جائے گا۔ لوگ صرف اس لیے بھروسہ نہیں کریں گے کہ انہیں بتایا گیا ہے۔ اعتماد کمایا جانا چاہیے، مسلط نہیں۔

اگر AI کو وسیع پیمانے پر اپنایا جانا ہے تو، ڈویلپرز کو ایسے نظام بنانے کی ضرورت ہے جو سمجھے، پوچھ گچھ اور جوابدہ ٹھہرے۔ صارفین کو فیصلہ سازی میں شامل ہونے کی ضرورت ہے، بجائے اس کے کہ صرف کنارے سے مشاہدہ کریں۔ اعتماد تب ہی صحیح معنوں میں برقرار رہ سکتا ہے جب لوگ خود کو عزت اور بااختیار محسوس کریں۔

ماخذ: https://dantri.com.vn/cong-nghe/vi-sao-tri-tue-nhan-tao-cham-vao-noi-so-sau-nhat-cua-con-nguoi-20251110120843170.htm

![[تصویر] جنرل سکریٹری ٹو لام نے لانگ تھانہ انٹرنیشنل ایئرپورٹ پروجیکٹ کا دورہ کیا۔](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/13/1763008564398_vna-potal-tong-bi-thu-to-lam-tham-du-an-cang-hang-khong-quoc-te-long-thanh-8404600-1261-jpg.webp)

![ڈونگ نائی OCOP منتقلی: [آرٹیکل 3] سیاحت کو OCOP مصنوعات کی کھپت سے جوڑنا](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/10/1762739199309_1324-2740-7_n-162543_981.jpeg)

تبصرہ (0)