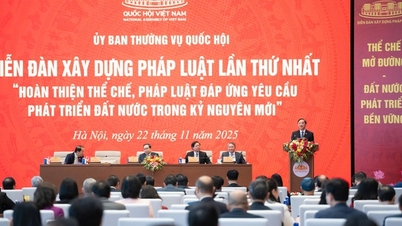

Theo đại biểu (ĐB) Đồng Ngọc Ba, Luật Trí tuệ nhân tạo (AI) được ban hành sẽ góp phần tạo cơ sở pháp lý thống nhất, đồng bộ, vừa thúc đẩy phát triển vừa bảo đảm quản lý hiệu quả rủi ro trong nghiên cứu, phát triển, sử dụng AI, đáp ứng yêu cầu của phát triển kinh tế - xã hội trong kỷ nguyên số.

Đại biểu cho rằng cơ quan soạn thảo đã rất tích cực, trách nhiệm, nghiên cứu tiếp thu nhiều ý kiến của cơ quan thẩm tra, các cơ quan liên quan để hoàn thiện dự án Luật. Đại biểu đánh giá cao nhiều nội dung đã tiếp thu, chỉnh lý trong dự thảo mới.

Đồng thời, đề nghị tiếp tục rà soát, chỉnh lý, nhất là bảo đảm thống nhất, đồng bộ với các luật liên quan như Bộ luật Dân sự, Luật Chất lượng sản phẩm, hàng hóa, Luật Sở hữu trí tuệ, Luật Công nghệ cao, Luật Tiêu chuẩn, quy chuẩn kỹ thuật; bảo đảm tư duy lập pháp mới và kỹ thuật lập pháp.

Bên cạnh đó, ĐB Đồng Ngọc Ba cũng nêu một số kiến nghị cụ thể.

Dự thảo Luật Trí tuệ nhân tạo (các điều 7 đến 11) quy định phân loại quản lý rủi ro của hệ thống AI theo 4 mức độ là rủi ro thấp, rủi ro trung bình, rủi ro cao và rủi ro không chấp nhận được.

ĐB Ba cho rằng, với tính chất của AI, nếu coi hệ thống AI là một loại sản phẩm, hàng hóa thì quy định của dự thảo Luật chưa hợp lý và chưa thống nhất, tương thích với quy định của Luật Chất lượng sản phẩm, hàng hóa (chia sản phẩm, hàng hóa thành 3 nhóm là rủi ro thấp, rủi ro trung bình và rủi ro cao).

Do đó, đề nghị cơ quan soạn thảo nghiên cứu kỹ lưỡng, quy định phân loại hệ thống AI theo hướng thống nhất với Luật Chất lượng sản phẩm, hàng hóa (3 cấp độ rủi ro) để thuận lợi trong triển khai thực hiện.

“Đối với trường hợp hệ thống AI “rủi ro không chấp nhận được”, nên tiếp cận đây là hoạt động bị cấm, cần quy định riêng thành điều cấm trong dự thảo Luật. Trong đó cần bổ sung các hành vi bị cấm khác trong nghiên cứu, phát triển, sử dụng AI (ví dụ: sử dụng AI xâm phạm an ninh quốc gia, sử dụng AI nhằm phân biệt đối xử dựa trên dữ liệu sinh trắc học…) để bảo đảm đầy đủ, chặt chẽ”-ĐB Ba đề xuất.

Về trách nhiệm bồi thường thiệt hại do hệ thống AI gây ra, tại điểm a khoản 3 Điều 30 dự thảo Luật Trí tuệ nhân tạo quy định: “Đối với hệ thống AI có rủi ro cao: Trường hợp thiệt hại phát sinh do hành vi vi phạm trong việc quản lý, sử dụng hệ thống AI thì tổ chức, cá nhân có hành vi vi phạm phải bồi thường thiệt hại theo quy định của pháp luật dân sự”.

Theo khoản 1 Điều 601 Bộ luật Dân sự, nguồn nguy hiểm cao độ bao gồm phương tiện giao thông vận tải cơ giới, hệ thống tải điện, nhà máy công nghiệp đang hoạt động, vũ khí, chất nổ, chất cháy, chất độc, chất phóng xạ, thú dữ và các nguồn nguy hiểm cao độ khác do pháp luật quy định.

Theo ĐB Đồng Ngọc Ba, Bộ luật Dân sự có sự phân biệt giữa bồi thường thiệt hại do nguồn nguy hiểm cao độ gây ra với các trường hợp khác, nhất là về yếu tố lỗi trong xác định trách nhiệm bồi thường. Với quy định của dự thảo Luật Trí tuệ nhân tạo tại điểm a khoản 3 Điều 30 nêu trên thì chưa rõ “hệ thống AI có rủi ro cao” có phải là “nguồn nguy hiểm cao độ” hay không. Trong khi về tính chất kỹ thuật, công nghệ, hệ thống AI rủi ro cao có tính chất của nguồn nguy hiểm cao độ.

Vì vậy, đại biểu đề nghị nghiên cứu chỉnh lý quy định tại điểm a khoản 3 Điều 30 dự thảo Luật Trí tuệ nhân tạo theo hướng quy định hệ thống AI rủi ro cao là nguồn nguy hiểm cao độ, để có cơ sở áp dụng quy định về trách nhiệm bồi thường thiệt hại do hệ thống AI gây ra theo quy định của Bộ luật Dân sự.

Về đổi mới tư duy và kỹ thuật lập pháp, ĐB Ba đề nghị rà soát để bảo đảm Luật Trí tuệ nhân tạo không quy định những vấn đề thuộc thẩm quyền của Chính phủ. Cụ thể như nội dung Chương VI (thanh tra, kiểm tra, xử lý vi phạm), cân nhắc không quy định về kiểm tra chuyên ngành mà để Chính phủ quy định theo thẩm quyền. Rà soát Chương VII (quản lý nhà nước về AI), lược bỏ những quy định thuộc thẩm quyền của Chính phủ như về trách nhiệm quản lý nhà nước của các bộ... Đề nghị gộp Chương VI vào Chương VII, vì thanh tra, kiểm tra, xử lý vi phạm về bản chất là những nội dung cụ thể của quản lý nhà nước về AI.

Phó Trưởng đoàn ĐBQH tỉnh Gia Lai Siu Hương bày tỏ sự quan tâm đến quy định về đạo đức và trách nhiệm trong hoạt động AI ở chương 5.

Theo ĐB Hương, hiện nay, nhiều mô hình AI được huấn luyện bằng việc thu thập dữ liệu, tác phẩm nghệ thuật và nội dung sáng tạo từ Internet mà không có sự đồng ý của tác giả, chưa có cơ chế bồi thường cho tác giả. Điều này tiềm ẩn nguy cơ xâm phạm quyền sở hữu trí tuệ của người sáng tạo nội dung.

Do đó, đại biểu đề nghị cơ quan soạn thảo nghiên cứu xem xét có thể bổ sung vào Chương 5 quy định nhà phát triển hệ thống AI phải có cơ chế xin phép rõ ràng, cho phép chủ sở hữu nội dung lựa chọn đồng ý hoặc từ chối việc sử dụng tác phẩm của mình vào mục đích huấn luyện AI. Đồng thời, nghiên cứu xây dựng cơ chế bồi thường hoặc chia sẻ lợi ích cho tác giả khi tác phẩm của họ được sử dụng trong huấn luyện mô hình AI.

Tham gia thảo luận, ĐB Nguyễn Văn Cảnh (thành viên đoàn ĐBQH tỉnh Gia Lai) nêu vấn đề dưới góc độ là một người tiêu dùng lo ngại khi sử dụng sản phẩm “có AI”, nếu có sự cố ngoài kiểm soát, gây thiệt hại thì ai chịu trách nhiệm bồi thường.

Theo ĐB Cảnh, trong dự thảo Luật Trí tuệ nhân tạo không giải thích từ ngữ “sản phẩm sử dụng công nghệ AI”. Người tiêu dùng chỉ biết sản phẩm, còn công nghệ AI như thế nào chỉ các nhà nghiên cứu, các nhà khoa học mới nắm chắc.

ĐB Cảnh đề nghị phân biệt rõ AI là sản phẩm đầu vào, là phương tiện-công cụ, là bán thành phẩm hay là thành phẩm hàng hóa. Từ đó, có những quy định cụ thể về trách nhiệm của bên cung cấp.

“Ví dụ như AI chỉ được tích hợp vào sản phẩm, khi xảy ra thiệt hại thì người bán sản phẩm đó phải chịu trách nhiệm hoàn toàn, không được đổ thừa do AI, “tại công ty làm ra AI bán cho tôi, tôi không kiểm soát được””-ĐB Cảnh phân tích.

Nguồn: https://baogialai.com.vn/viec-ban-hanh-luat-tri-tue-nhan-tao-la-van-de-cap-bach-post573129.html

Bình luận (0)