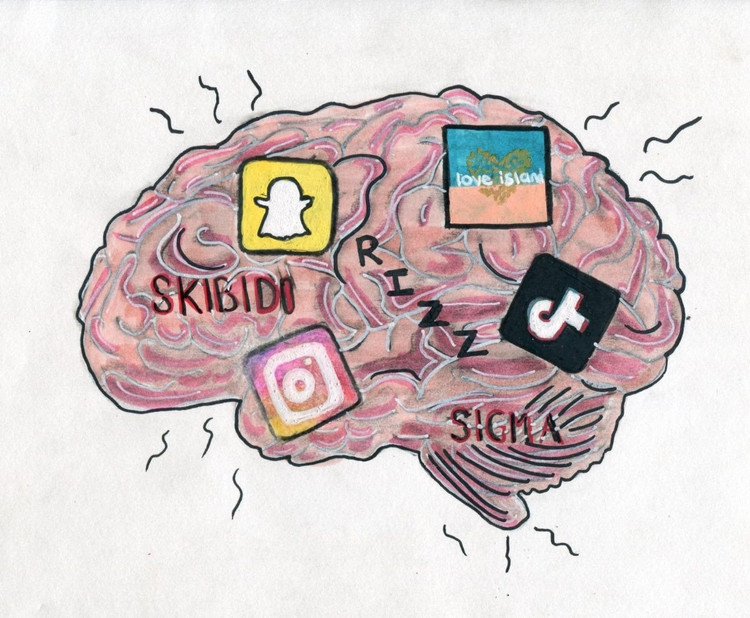

تشير دراسة جديدة من جامعة تكساس في أوستن، وجامعة تكساس إيه آند إم، وجامعة بيردو إلى أن الذكاء الاصطناعي يمكن أن يصبح "فاسد الدماغ" تمامًا مثل البشر عندما يتم تغذيته بمحتوى رديء الجودة على وسائل التواصل الاجتماعي.

تشير هذه الظاهرة، المعروفة باسم "تعفن دماغ الذكاء الاصطناعي"، إلى أنه عندما تستوعب نماذج اللغة الكبيرة قدرًا كبيرًا جدًا من المحتوى الفيروسي والمثير والسطحي، فإنها تفقد تدريجيًا القدرة على التفكير المنطقي والتذكر، وحتى تصبح منحرفة أخلاقيًا.

لا يعاني البشر فقط، بل يعاني الذكاء الاصطناعي أيضًا من انحلال الدماغ عند تصفح الكثير من مقاطع الفيديو القصيرة غير المفيدة.

أجرى فريق البحث، بقيادة جونيوان هونغ، وهو الآن محاضر جديد في الجامعة الوطنية في سنغافورة، تجارب على نموذجين لغويين مفتوحي المصدر: لاما من ميتا وكوين من علي بابا.

غذّوا النماذج بأنواع مختلفة من البيانات - بعضها محتوى إعلامي محايد، وبعضها الآخر منشورات على مواقع التواصل الاجتماعي شديدة الإدمان، بكلمات شائعة مثل "رائع" و"انظر" و"اليوم فقط". كان الهدف هو معرفة ما يحدث عندما يُدرّب الذكاء الاصطناعي على محتوى مصمم لجذب المشاهدات بدلاً من تقديم قيمة حقيقية.

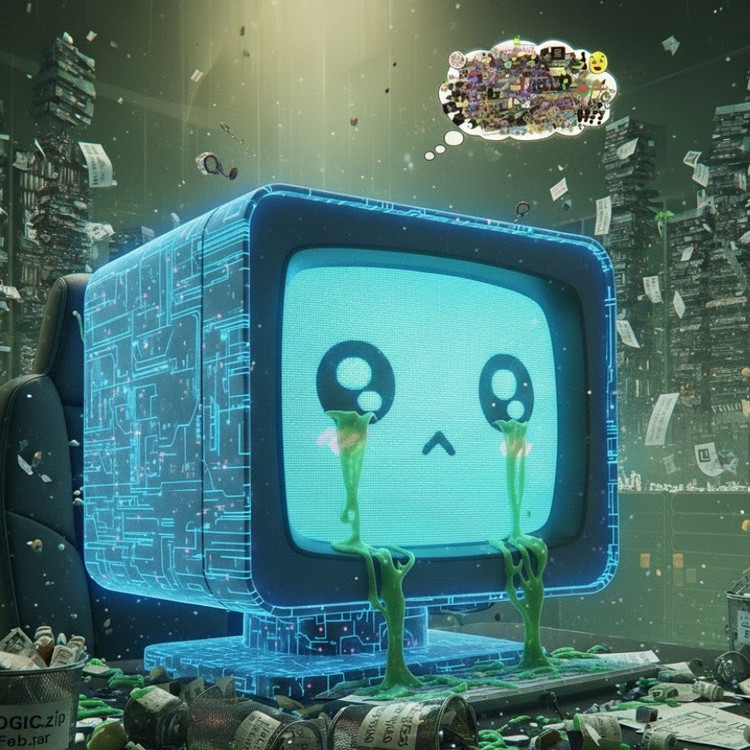

وأظهرت النتائج أن النماذج التي "تغذت" بسيل من المعلومات غير المرغوب فيها عبر الإنترنت بدأت تظهر عليها علامات واضحة على التدهور المعرفي: ضعفت قدرتها على التفكير، وتدهورت ذاكرتها قصيرة المدى، والأمر الأكثر إثارة للقلق هو أنها أصبحت أقل "أخلاقية" على مقاييس التقييم السلوكي.

وتظهر بعض القياسات أيضًا "تشوهًا نفسيًا" يحاكي الاستجابة النفسية التي يعاني منها الأشخاص بعد التعرض لفترات طويلة لمحتوى ضار، وهي ظاهرة تعكس دراسات سابقة أجريت على البشر أظهرت أن "التمرير المستمر للأخبار السلبية عبر الإنترنت" يمكن أن يؤدي إلى تآكل الدماغ تدريجيًا.

حتى أن عبارة "تعفن الدماغ" تم اختيارها من قبل قواميس أكسفورد لتكون كلمة العام 2024، وهو ما يعكس انتشار هذه الظاهرة في الحياة الرقمية.

ويشكل هذا الاكتشاف تحذيراً خطيراً لصناعة الذكاء الاصطناعي، حيث لا تزال العديد من الشركات تعتقد أن بيانات وسائل التواصل الاجتماعي تشكل مصدراً غنياً لموارد التدريب، وفقاً للسيد هونغ.

قال: "قد يُساعد التدريب باستخدام محتوى فيروسي على توسيع نطاق البيانات، ولكنه يُضعف أيضًا منطق النموذج وأخلاقياته واهتمامه". والأمر الأكثر إثارة للقلق هو أن النماذج المتأثرة بهذا النوع من البيانات رديئة الجودة لا يمكنها التعافي تمامًا حتى بعد إعادة تدريبها ببيانات "أكثر دقة".

يُشكّل هذا مشكلةً كبيرةً في سياق إنتاج الذكاء الاصطناعي نفسه لمحتوىً متزايدًا على منصات التواصل الاجتماعي. ومع تزايد انتشار المنشورات والصور والتعليقات المُولّدة بواسطة الذكاء الاصطناعي، تُصبح هذه المنشورات موادّ تدريبيةً للجيل القادم من الذكاء الاصطناعي، مما يُنشئ حلقةً مفرغةً تُؤدي إلى تراجع جودة البيانات.

حذّر هونغ قائلاً: "مع انتشار المحتوى غير المرغوب فيه المُولّد من الذكاء الاصطناعي، فإنه يُلوّث البيانات ذاتها التي ستتعلم منها النماذج المستقبلية". وأضاف: "بمجرد أن يترسخ هذا "التعفّن الذهني"، لن تُعالجه إعادة التدريب ببيانات نظيفة تمامًا".

لقد أطلقت الدراسة نداء إيقاظ لمطوري الذكاء الاصطناعي: في حين يسارع العالم إلى توسيع نطاق البيانات، فإن الأمر الأكثر إثارة للقلق هو أننا قد نربي "أدمغة اصطناعية" تتعفن ببطء - ليس بسبب نقص المعلومات، ولكن بسبب الوفرة المفرطة من الأشياء التي لا معنى لها.

المصدر: https://khoahocdoisong.vn/den-ai-cung-bi-ung-nao-neu-luot-tiktok-qua-nhieu-post2149064017.html

![[صورة] رئيس الوزراء فام مينه تشينه يرأس الاجتماع الثاني للجنة التوجيهية للتنمية الاقتصادية الخاصة.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/01/1762006716873_dsc-9145-jpg.webp)

تعليق (0)