Pokud jste někdy procházeli sociální média, je pravděpodobné, že jste narazili na obrázky nebo videa vytvořená umělou inteligencí. Mnoho lidí se nechalo oklamat, například virálním videem králíků skákajících na trampolíně. Sora – sesterská aplikace ChatGPT vyvinutá společností OpenAI – však posouvá videa s umělou inteligencí na novou úroveň, takže detekce falešného obsahu je stále naléhavější.

Nástroje pro tvorbu videa s umělou inteligencí ztěžují identifikaci skutečných videí více než kdy jindy. (Zdroj: CNET)

Tato aplikace, spuštěná v roce 2024 a nedávno aktualizovaná o Sora 2, má rozhraní podobné TikToku, kde jsou všechna videa generována umělou inteligencí. Funkce „cameo“ umožňuje vkládat skutečné osoby do simulovaných záběrů a vytvářet tak děsivě realistická videa.

Mnoho odborníků se proto obává, že Sora způsobí šíření deepfaků, které zkreslují informace a stírají hranice mezi realitou a falešnými informacemi. Obzvláště zranitelné jsou celebrity, což vede organizace jako SAG-AFTRA k tomu, aby vyzvaly OpenAI k posílení ochrany.

Identifikace obsahu generovaného umělou inteligencí je velkou výzvou pro technologické společnosti, platformy sociálních médií i uživatele. Existují však způsoby, jak rozpoznat videa vytvořená pomocí Sora.

Najít vodoznak Sora

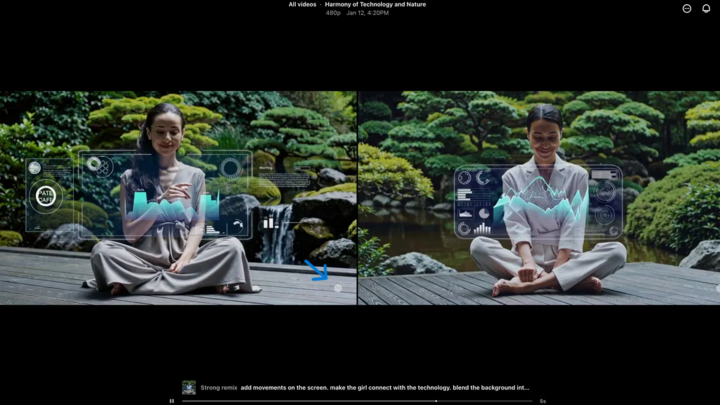

Vodoznak Sora (označený modrou šipkou) je značka, která identifikuje nástroj použitý k vytvoření videa. (Zdroj: CNET)

Každé video vytvořené v aplikaci Sora pro iOS má po stažení vodoznak – bílé logo Sora (ikona mraku) se pohybuje po okrajích videa, podobně jako vodoznak na TikToku.

Toto je vizuální způsob, jak identifikovat obsah generovaný umělou inteligencí. Například model „nano-banánů“ od Googlu Gemini také automaticky přidává k obrázkům vodoznak. Vodoznaky však nejsou vždy spolehlivé. Pokud je vodoznak statický, lze jej snadno oříznout. Dokonce i dynamické vodoznaky, jako je ten od Sory, lze odstranit pomocí specializovaných aplikací.

Když se generálního ředitele OpenAI Sama Altmana na to zeptali, argumentoval tím, že společnost se musí přizpůsobit realitě, že kdokoli může vytvářet falešná videa. Před Sorou neexistoval nástroj, který by byl tak populární, dostupný a nevyžadoval žádné dovednosti k vytváření takových videí. Jeho pohled zdůrazňuje potřebu spoléhat se na alternativní metody ověřování.

Zkontrolovat metadata

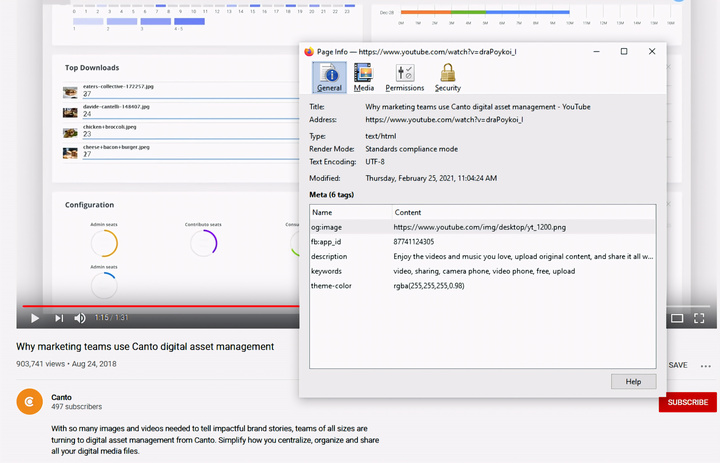

Kontrola metadat – klíčový krok k určení, zda video vytvořila umělá inteligence, jako je Sora. (Zdroj: Canto)

Možná si myslíte, že kontrola metadat je příliš složitá, ale ve skutečnosti je to docela jednoduché a velmi efektivní.

Metadata jsou sada informací, které se automaticky připojují k obsahu při jeho vytváření, jako je typ kamery, umístění, čas záznamu a název souboru. Ať už je obsah generován člověkem nebo umělou inteligencí, má metadata. U obsahu generovaného umělou inteligencí metadata často zahrnují informace o zdroji.

OpenAI je členem Koalice pro původ a autenticitu obsahu (C2PA), takže videa Sora budou obsahovat metadata C2PA. Ověřit to můžete pomocí nástroje pro ověřování autenticity obsahu, který je součástí iniciativy:

Jak zkontrolovat metadata:

- Navštivte stránky verify.contentauthenticity.org

- Nahrajte soubor ke kontrole.

- Stiskněte tlačítko „Otevřít“

- Informace naleznete v tabulce vpravo.

Pokud bylo video vytvořeno umělou inteligencí, bude to v shrnutí jasně uvedeno. Při kontrole videí Sora uvidíte řádek „publikováno OpenAI“ a informace potvrzující, že video bylo vytvořeno pomocí umělé inteligence. Všechna videa Sora musí tuto informaci obsahovat, aby se ověřil jejich původ.

Zdroj: https://vtcnews.vn/cach-nhan-biet-video-that-hay-do-ai-tao-ar972891.html

![[Fotografie] Premiér Pham Minh Chinh přijal guvernéra provincie Točigi (Japonsko)](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765892133176_dsc-8082-6425-jpg.webp&w=3840&q=75)

![[Živě] Slavnostní předávání cen komunitní činnosti 2025](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765899631650_ndo_tr_z7334013144784-9f9fe10a6d63584c85aff40f2957c250-jpg.webp&w=3840&q=75)

![[Obrázek] Uniklé snímky před slavnostním předáváním cen Community Action Awards 2025.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765882828720_ndo_br_thiet-ke-chua-co-ten-45-png.webp&w=3840&q=75)

![[Foto] Premiér Pham Minh Chinh přijal laoského ministra školství a sportu Thongsalitha Mangnormeka](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765876834721_dsc-7519-jpg.webp&w=3840&q=75)

![[Živě] Slavnostní zakončení a předání cen v soutěži o nejlepší video/klip „Působivý vietnamský turismus“ 2025](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/17/1765974650260_z7273498850699-00d2fd6b0972cb39494cfa2559bf85ac-1765959338756946072104-627-0-1338-1138-crop-1765959347256801551121.jpeg)

Komentář (0)