|

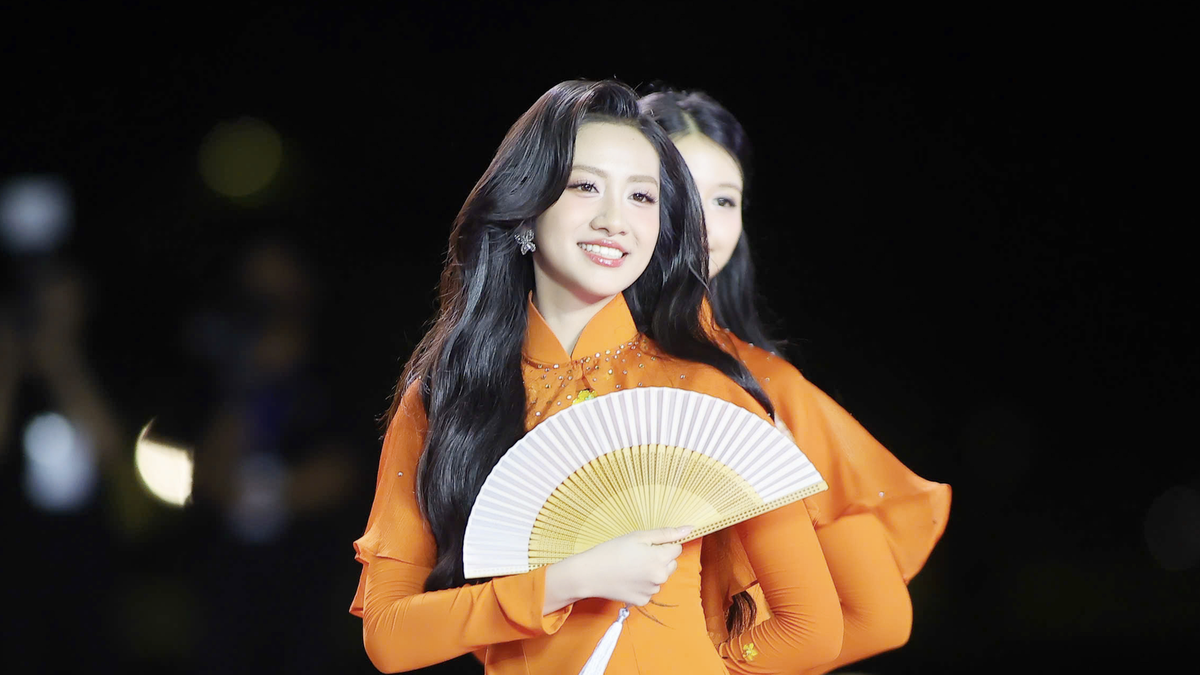

Alibabas R1-Omni-Modell kann in einem Video auf den emotionalen Zustand einer Person schließen. Foto: Xpert.Digital . |

Laut Bloomberg hat Alibabas Tongyi Lab das R1-Omni-Modell am 11. März als Open Source veröffentlicht.

Das bemerkenswerteste Merkmal dieses Modells besteht darin, dass es den emotionalen Zustand einer Person in einem Video ableiten und gleichzeitig Kleidung und Umgebung beschreiben kann.

Dies ist ein Fortschritt im Bereich der Computervision und eine verbesserte Version des bisherigen Open-Source-Modells HumanOmni, das vom Alibaba-Chefforscher Jiaxing Zhao entwickelt wurde. Genauer gesagt hat Alibaba R1-Omni auf der Hugging Face-Plattform zum kostenlosen Download freigegeben.

Der Forschungsbericht zeigt, dass R1-Omni besser versteht, wie visuelle und auditive Informationen die Emotionserkennung unterstützen. Um die Emotionserkennung sowohl visuell als auch akustisch zu verbessern, optimiert das Modell seine KI-Systeme zusätzlich durch Reinforcement-Learning-Algorithmen.

Reinforcement Learning ist eine Art maschineller Lernprozess, der sich auf die Entscheidungsfindung durch automatisierte Agenten konzentriert, darunter fortschrittliche KI-Software, Roboter und selbstfahrende Autos.

Diese automatisierten Agenten lernen durch Versuch und Irrtum, eine Aufgabe ohne menschliche Anleitung auszuführen. Diese Technik ist ein wichtiges Element in der Entwicklung von KI-Modellen, da sie sequenzielle Entscheidungsprobleme in einer unsicheren Umgebung löst.

Die Ergebnisse der Studie zeigen, dass das R1-Omni-Modell über stärkere Argumentations-, Erkenntnis- und Generalisierungsfähigkeiten verfügt als andere Modelle.

Quelle: https://znews.vn/ai-trung-quoc-doc-duoc-cam-xuc-con-nguoi-post1537948.html

Kommentar (0)