DeepSeak hat ein KI-Modell entwickelt, das nicht nur Code schreibt, sondern sich auch selbst überprüft und seine Korrektheit beweist.

DeepSeekMath-V2 hat beispiellose Leistungsrekorde aufgestellt und menschliche Leistungen in anspruchsvollen akademischen Wettbewerben übertroffen. Besonders hervorzuheben ist der Gewinn der Goldmedaille bei der Internationalen Mathematik-Olympiade (IMO) 2025 sowie das sensationelle Ergebnis von 118 von 120 Punkten beim Putnam-Wettbewerb, womit der bisherige Rekord von 90 Punkten deutlich übertroffen wurde.

Das Bahnbrechende an diesem Modell ist jedoch nicht das Ergebnis, sondern die „Selbstverifizierungsfunktion“ von DeepSeek.

DeepSeeks Selbstverifizierungs- und Fehlerkorrekturmechanismus

Seit vielen Jahren stehen Modelle der künstlichen Intelligenz (KI) und große Sprachmodelle (LLMs) vor einer gravierenden Schwäche bei der Lösung von Problemen, die absolute Logik erfordern, wie beispielsweise in der Mathematik: dem Phänomen der „falschen Argumentation, aber richtigen Antwort“.

Das heißt, das Modell kann zufällig das richtige Endergebnis liefern, aber die Abfolge der Schlussfolgerungsschritte, Formeln oder logischen Schritte, die zu diesem Ergebnis geführt haben, kann falsch, unvollständig oder irreführend sein.

In den Bereichen Wissenschaft , Ingenieurwesen und Mathematik ist eine korrekte Antwort mit falscher Lösung völlig wertlos und beeinträchtigt die Zuverlässigkeit eines KI-Systems erheblich. DeepSeekMath-V2 wurde entwickelt, um dieser Ära der Unzuverlässigkeit ein Ende zu setzen.

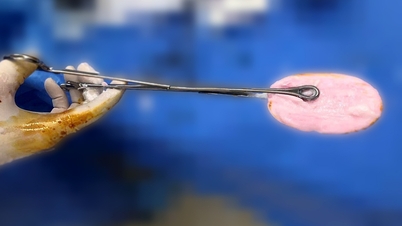

Die Selbstverifizierungsfähigkeit von DeepSeekMath-V2 ist der Kern seines Erfolgs. Sie fungiert als „interner Prüfer“ im Denkprozess der KI. Anstatt lediglich eine Schlussfolgerung zu ziehen und ein Ergebnis auszugeben, integriert das DeepSeekMath-V2-Modell einen bidirektionalen Mechanismus.

Die erste Rolle ist die Beweisrolle, in der das Modell eine anfängliche Kette von Argumenten und Lösungen generiert. Anschließend löst das Modell automatisch ein internes Prüfsystem aus, das jeden logischen Schritt der soeben generierten Argumentkette auf Fehler, Inkonsistenzen oder unplausible Schlussfolgerungen überprüft.

Dieser Prozess ähnelt stark der Funktionsweise des IMO-ProofBench-Evaluierungssystems, bei dem eine KI ein Argument generiert und eine andere es verifiziert. Durch die wiederholte Überprüfung, bis die Argumentkette als absolut stichhaltig bestätigt ist, stellt DeepSeekMath-V2 sicher, dass nicht nur das Ergebnis korrekt ist, sondern auch der Weg dorthin absolut korrekt und transparent.

Die Zukunft vertrauenswürdiger KI erschließen

Die Auswirkungen dieser selbstverifizierenden Inferenzmethode könnten einen neuen Standard für Transparenz und Vertrauenswürdigkeit bei KI-Anwendungen in der realen Welt setzen.

Zukünftig kann dieses Modell auch in anderen wichtigen Bereichen Anwendung finden, wie zum Beispiel: KI schreibt nicht nur Code, sondern überprüft ihn auch selbst und beweist seine Korrektheit, wodurch schwerwiegende Fehler minimiert werden.

Darüber hinaus kann KI komplexe Argumentationsketten bei der Entwicklung von Hypothesen oder dem Beweis neuer Theoreme automatisch überprüfen und so die Rationalität und Sicherheit wichtiger Entscheidungen der KI gewährleisten.

DeepSeeks Entscheidung, den Quellcode des Modells auf Plattformen wie Hugging Face und GitHub öffentlich zugänglich zu machen, ist ein strategischer Schritt, der es der globalen Forschungsgemeinschaft ermöglicht, auf dieses überprüfbare Inferenzprinzip zuzugreifen und darauf aufzubauen.

DeepSeekMath-V2 stellt einen Quantensprung dar und demonstriert nicht nur die überlegene Fähigkeit von KI, selbst schwierigste Probleme zu lösen, sondern stellt auch sicher, dass diese Fähigkeit auf Vertrauen und unerschütterlicher Logik beruht. Dies beweist, dass die nächste Generation von KI nicht nur intelligenter, sondern auch ehrlicher und transparenter in ihrem Denkprozess sein wird.

Quelle: https://tuoitre.vn/deepseek-phat-trien-mo-hinh-co-kha-nang-tu-kiem-chung-cac-suy-luan-trong-toan-hoc-2025113016585069.htm

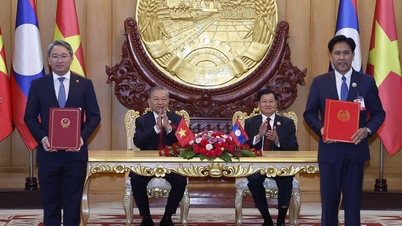

![[Foto] Premierminister Pham Minh Chinh empfängt den Präsidenten der kubanischen Nachrichtenagentur für Lateinamerika.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F01%2F1764569497815_dsc-2890-jpg.webp&w=3840&q=75)

Kommentar (0)