|

KI hat den Menschen in der Programmierung noch nicht ersetzt. Foto: John McGuire . |

In letzter Zeit werden führende KI-Modelle von OpenAI und Anthropic zunehmend für Programmieranwendungen eingesetzt. ChatGPT und Claude haben Speicher und Rechenleistung erhöht, um Hunderte von Codezeilen analysieren zu können, oder Gemini hat eine Canvas-Ergebnisanzeige speziell für Programmierer integriert.

Im Oktober 2024 erklärte Google-CEO Sundar Pichai, dass 25 % des neuen Codes im Unternehmen durch KI generiert würden. Mark Zuckerberg, CEO von Meta, äußerte ebenfalls die Ambition, KI-Modelle für die Code-Erstellung im Unternehmen flächendeckend einzusetzen.

Eine neue Studie von Microsoft Research, der Forschungs- und Entwicklungsabteilung von Microsoft, zeigt jedoch, dass KI-Modelle, darunter Claude 3.7 Sonnet von Anthropic und o3-mini von OpenAI, viele Fehler in einem Programmiertest-Benchmark namens SWE-bench Lite nicht bewältigen konnten.

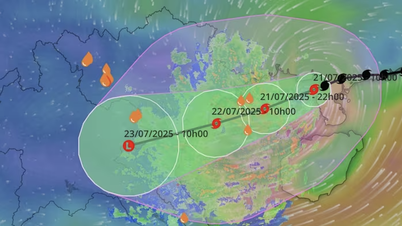

Die Autoren der Studie testeten neun verschiedene KI-Modelle, die mit verschiedenen Debugging-Tools, wie beispielsweise dem Python-Debugger, integriert waren und Probleme mit einer einzigen Anweisung lösen konnten. Die Modelle mussten 300 Softwarefehler beheben, die aus dem SWE-bench Lite-Datensatz ausgewählt wurden.

|

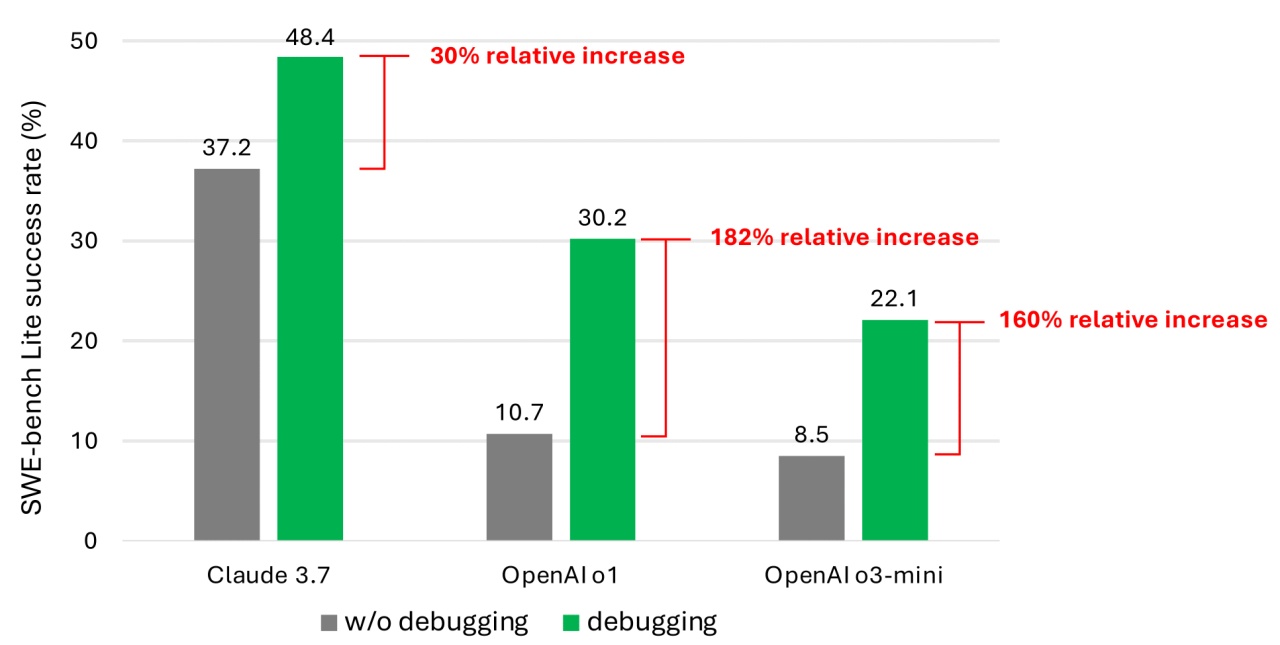

Erfolgsquote beim Lösen von Programmierproblemen aus dem SWE-Bench Lite-Datensatz. Foto: Microsoft. |

Selbst mit neueren, leistungsstärkeren Modellen zeigten die Ergebnisse, dass KI-Agenten selten mehr als die Hälfte der zugewiesenen Debugging-Aufgaben erfolgreich erledigten. Unter den getesteten Modellen erreichte Claude 3.7 Sonnet mit 48,4 % die höchste durchschnittliche Erfolgsquote, gefolgt von OpenAIs o1 mit 30,2 % und o3-mini mit 22,1 %.

Zu den Gründen für die niedrige Leistung gehört, dass manche Modelle die bereitgestellten Debugging-Tools nicht richtig anwenden können. Darüber hinaus liegt das größere Problem laut den Autoren in unzureichenden Daten.

Sie argumentieren, dass dem System, das die Modelle trainiert, noch Daten fehlen, die die Debugging-Schritte simulieren, die Menschen von Anfang bis Ende durchführen. Mit anderen Worten: Die KI hat nicht genug darüber gelernt, wie Menschen bei der Lösung eines echten Softwarefehlers Schritt für Schritt denken und handeln.

Durch Training und Feinabstimmung der Modelle könnten diese besser Software debuggen. „Dies würde jedoch spezielle Trainingsdatensätze erfordern“, so die Autoren.

Zahlreiche Studien haben auf Sicherheitslücken und Fehler bei der KI-Codegenerierung hingewiesen, die auf Schwächen wie das eingeschränkte Verständnis der Programmierlogik zurückzuführen sind. Eine aktuelle Überprüfung des KI-Programmiertools Devin ergab, dass es nur drei von 20 Programmiertests erfolgreich absolvierte.

Die Programmierfähigkeiten von KI sind nach wie vor umstritten. Kevin Weil, Chief Product Officer von OpenAI, sagte bereits, dass KI bis Ende dieses Jahres menschliche Programmierer übertreffen werde.

Bill Gates, Mitbegründer von Microsoft, ist hingegen überzeugt, dass Programmieren auch in Zukunft eine zukunftsfähige Karriere sein wird. Auch andere Führungskräfte wie Amjad Masad (CEO von Replit), Todd McKinnon (CEO von Okta) und Arvind Krishna (CEO von IBM) unterstützen diese Ansicht.

Die Forschung von Microsoft ist zwar nicht neu, soll Programmierern und Managern aber auch eine Mahnung sein, sorgfältiger nachzudenken, bevor sie der KI die vollständige Kontrolle über die Codierung überlassen.

Quelle: https://znews.vn/diem-yeu-chi-mang-cua-ai-post1545220.html

![[Foto] Der Vorsitzende der Nationalversammlung, Tran Thanh Man, besucht die vietnamesische Heldin Ta Thi Tran](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/7/20/765c0bd057dd44ad83ab89fe0255b783)

Kommentar (0)